INFO: starting new backup job: vzdump 100 --node fsp-proxmox --storage fsp_home --notes-template '{{guestname}}' --mailnotification always --mode snapshot --quiet 1

INFO: Starting Backup of VM 100 (qemu)

INFO: Backup started at 2023-05-17 02:00:00

INFO: status = running

INFO: VM Name: fs-srv-01

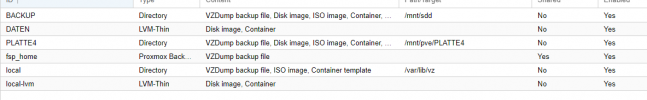

INFO: include disk 'scsi0' 'local-lvm:vm-100-disk-0' 250G

INFO: include disk 'scsi1' 'DATEN:vm-100-disk-0' 1224G

INFO: include disk 'scsi2' 'DATEN:vm-100-disk-1' 1224G

INFO: backup mode: snapshot

INFO: ionice priority: 7

INFO: creating Proxmox Backup Server archive 'vm/100/2023-05-17T00:00:00Z'

INFO: started backup task '4745f306-3425-403f-b42a-c060ad048a68'

INFO: resuming VM again

INFO: scsi0: dirty-bitmap status: created new

INFO: scsi1: dirty-bitmap status: created new

INFO: scsi2: dirty-bitmap status: created new

INFO: 0% (148.0 MiB of 2.6 TiB) in 3s, read: 49.3 MiB/s, write: 28.0 MiB/s

INFO: 1% (27.4 GiB of 2.6 TiB) in 29m 38s, read: 15.7 MiB/s, write: 8.0 MiB/s

INFO: 2% (56.2 GiB of 2.6 TiB) in 29m 49s, read: 2.6 GiB/s, write: 3.6 MiB/s

INFO: 3% (81.8 GiB of 2.6 TiB) in 30m 46s, read: 460.0 MiB/s, write: 10.0 MiB/s

INFO: 4% (108.1 GiB of 2.6 TiB) in 31m 1s, read: 1.7 GiB/s, write: 6.9 MiB/s

INFO: 5% (135.5 GiB of 2.6 TiB) in 31m 31s, read: 937.5 MiB/s, write: 9.1 MiB/s

INFO: 6% (161.9 GiB of 2.6 TiB) in 31m 41s, read: 2.6 GiB/s, write: 1.6 MiB/s

INFO: 7% (190.4 GiB of 2.6 TiB) in 31m 50s, read: 3.2 GiB/s, write: 0 B/s

INFO: 8% (217.7 GiB of 2.6 TiB) in 32m 2s, read: 2.3 GiB/s, write: 4.0 MiB/s

INFO: 9% (243.4 GiB of 2.6 TiB) in 32m 11s, read: 2.9 GiB/s, write: 1.8 MiB/s

INFO: 10% (270.9 GiB of 2.6 TiB) in 32m 19s, read: 3.4 GiB/s, write: 0 B/s

INFO: 11% (299.1 GiB of 2.6 TiB) in 32m 27s, read: 3.5 GiB/s, write: 0 B/s

INFO: 12% (324.5 GiB of 2.6 TiB) in 32m 35s, read: 3.2 GiB/s, write: 0 B/s

INFO: 13% (352.8 GiB of 2.6 TiB) in 32m 45s, read: 2.8 GiB/s, write: 0 B/s

INFO: 14% (379.9 GiB of 2.6 TiB) in 32m 54s, read: 3.0 GiB/s, write: 0 B/s

INFO: 15% (407.1 GiB of 2.6 TiB) in 33m 3s, read: 3.0 GiB/s, write: 0 B/s

INFO: 16% (433.8 GiB of 2.6 TiB) in 33m 12s, read: 3.0 GiB/s, write: 0 B/s

INFO: 17% (458.9 GiB of 2.6 TiB) in 33m 20s, read: 3.1 GiB/s, write: 0 B/s

INFO: 18% (486.8 GiB of 2.6 TiB) in 33m 29s, read: 3.1 GiB/s, write: 0 B/s

INFO: 19% (515.9 GiB of 2.6 TiB) in 33m 37s, read: 3.6 GiB/s, write: 0 B/s

INFO: 20% (540.2 GiB of 2.6 TiB) in 33m 45s, read: 3.0 GiB/s, write: 0 B/s

INFO: 21% (568.1 GiB of 2.6 TiB) in 33m 55s, read: 2.8 GiB/s, write: 0 B/s

INFO: 22% (593.9 GiB of 2.6 TiB) in 34m 4s, read: 2.9 GiB/s, write: 0 B/s

INFO: 23% (621.2 GiB of 2.6 TiB) in 34m 14s, read: 2.7 GiB/s, write: 0 B/s

INFO: 24% (648.4 GiB of 2.6 TiB) in 34m 24s, read: 2.7 GiB/s, write: 0 B/s

INFO: 25% (677.3 GiB of 2.6 TiB) in 34m 34s, read: 2.9 GiB/s, write: 0 B/s

INFO: 26% (704.4 GiB of 2.6 TiB) in 34m 43s, read: 3.0 GiB/s, write: 0 B/s

INFO: 27% (730.6 GiB of 2.6 TiB) in 34m 52s, read: 2.9 GiB/s, write: 0 B/s

INFO: 28% (756.0 GiB of 2.6 TiB) in 35m 2s, read: 2.5 GiB/s, write: 0 B/s

INFO: 29% (783.0 GiB of 2.6 TiB) in 35m 12s, read: 2.7 GiB/s, write: 0 B/s

INFO: 30% (811.4 GiB of 2.6 TiB) in 35m 23s, read: 2.6 GiB/s, write: 372.4 KiB/s

INFO: 31% (837.1 GiB of 2.6 TiB) in 35m 33s, read: 2.6 GiB/s, write: 0 B/s

INFO: 32% (866.0 GiB of 2.6 TiB) in 35m 44s, read: 2.6 GiB/s, write: 0 B/s

INFO: 33% (891.6 GiB of 2.6 TiB) in 35m 54s, read: 2.6 GiB/s, write: 0 B/s

INFO: 34% (917.6 GiB of 2.6 TiB) in 36m 5s, read: 2.4 GiB/s, write: 0 B/s

INFO: 35% (944.4 GiB of 2.6 TiB) in 36m 15s, read: 2.7 GiB/s, write: 0 B/s

INFO: 36% (971.6 GiB of 2.6 TiB) in 36m 24s, read: 3.0 GiB/s, write: 0 B/s

INFO: 37% (999.7 GiB of 2.6 TiB) in 36m 33s, read: 3.1 GiB/s, write: 0 B/s

INFO: 38% (1.0 TiB of 2.6 TiB) in 36m 42s, read: 3.1 GiB/s, write: 0 B/s

INFO: 39% (1.0 TiB of 2.6 TiB) in 37m 14s, read: 818.1 MiB/s, write: 50.5 MiB/s

INFO: 40% (1.1 TiB of 2.6 TiB) in 37m 42s, read: 1016.6 MiB/s, write: 30.9 MiB/s

INFO: 41% (1.1 TiB of 2.6 TiB) in 38m, read: 1.4 GiB/s, write: 41.6 MiB/s

INFO: 42% (1.1 TiB of 2.6 TiB) in 38m 34s, read: 833.2 MiB/s, write: 26.0 MiB/s

INFO: 43% (1.1 TiB of 2.6 TiB) in 38m 57s, read: 1.2 GiB/s, write: 35.1 MiB/s

INFO: 44% (1.2 TiB of 2.6 TiB) in 39m 24s, read: 1002.1 MiB/s, write: 31.7 MiB/s

INFO: 45% (1.2 TiB of 2.6 TiB) in 39m 43s, read: 1.5 GiB/s, write: 43.2 MiB/s

INFO: 46% (1.2 TiB of 2.6 TiB) in 40m 1s, read: 1.6 GiB/s, write: 22.7 MiB/s

INFO: 47% (1.2 TiB of 2.6 TiB) in 40m 9s, read: 3.0 GiB/s, write: 0 B/s

INFO: 48% (1.3 TiB of 2.6 TiB) in 40m 17s, read: 3.3 GiB/s, write: 0 B/s

INFO: 49% (1.3 TiB of 2.6 TiB) in 40m 26s, read: 3.3 GiB/s, write: 0 B/s

INFO: 50% (1.3 TiB of 2.6 TiB) in 40m 33s, read: 3.5 GiB/s, write: 0 B/s

INFO: 51% (1.3 TiB of 2.6 TiB) in 40m 41s, read: 3.3 GiB/s, write: 0 B/s

INFO: 52% (1.4 TiB of 2.6 TiB) in 40m 50s, read: 3.2 GiB/s, write: 0 B/s

INFO: 53% (1.4 TiB of 2.6 TiB) in 40m 58s, read: 3.5 GiB/s, write: 0 B/s

INFO: 54% (1.4 TiB of 2.6 TiB) in 41m 5s, read: 3.5 GiB/s, write: 0 B/s

INFO: 55% (1.5 TiB of 2.6 TiB) in 41m 14s, read: 3.1 GiB/s, write: 0 B/s

INFO: 56% (1.5 TiB of 2.6 TiB) in 41m 24s, read: 2.8 GiB/s, write: 0 B/s

INFO: 57% (1.5 TiB of 2.6 TiB) in 41m 33s, read: 3.1 GiB/s, write: 910.2 KiB/s

INFO: 58% (1.5 TiB of 2.6 TiB) in 41m 40s, read: 3.4 GiB/s, write: 0 B/s

INFO: 59% (1.6 TiB of 2.6 TiB) in 41m 48s, read: 3.4 GiB/s, write: 0 B/s

INFO: 60% (1.6 TiB of 2.6 TiB) in 41m 56s, read: 3.4 GiB/s, write: 0 B/s

INFO: 61% (1.6 TiB of 2.6 TiB) in 42m 4s, read: 3.3 GiB/s, write: 0 B/s

INFO: 62% (1.6 TiB of 2.6 TiB) in 42m 12s, read: 3.3 GiB/s, write: 0 B/s

INFO: 63% (1.7 TiB of 2.6 TiB) in 42m 21s, read: 3.1 GiB/s, write: 0 B/s

INFO: 64% (1.7 TiB of 2.6 TiB) in 42m 30s, read: 3.2 GiB/s, write: 455.1 KiB/s

INFO: 65% (1.7 TiB of 2.6 TiB) in 42m 37s, read: 3.4 GiB/s, write: 0 B/s

INFO: 66% (1.7 TiB of 2.6 TiB) in 42m 45s, read: 3.4 GiB/s, write: 0 B/s

INFO: 67% (1.8 TiB of 2.6 TiB) in 42m 53s, read: 3.5 GiB/s, write: 0 B/s

INFO: 68% (1.8 TiB of 2.6 TiB) in 43m 2s, read: 3.2 GiB/s, write: 910.2 KiB/s

INFO: 69% (1.8 TiB of 2.6 TiB) in 43m 12s, read: 2.5 GiB/s, write: 1.6 MiB/s

INFO: 70% (1.8 TiB of 2.6 TiB) in 43m 23s, read: 2.6 GiB/s, write: 0 B/s

INFO: 71% (1.9 TiB of 2.6 TiB) in 43m 33s, read: 2.7 GiB/s, write: 0 B/s

INFO: 72% (1.9 TiB of 2.6 TiB) in 43m 43s, read: 2.6 GiB/s, write: 0 B/s

INFO: 73% (1.9 TiB of 2.6 TiB) in 43m 53s, read: 2.8 GiB/s, write: 0 B/s

INFO: 74% (2.0 TiB of 2.6 TiB) in 44m 3s, read: 2.6 GiB/s, write: 0 B/s

INFO: 75% (2.0 TiB of 2.6 TiB) in 44m 14s, read: 2.6 GiB/s, write: 372.4 KiB/s

INFO: 76% (2.0 TiB of 2.6 TiB) in 44m 24s, read: 2.7 GiB/s, write: 0 B/s

INFO: 77% (2.0 TiB of 2.6 TiB) in 44m 34s, read: 2.7 GiB/s, write: 0 B/s

INFO: 78% (2.1 TiB of 2.6 TiB) in 44m 44s, read: 2.6 GiB/s, write: 0 B/s

INFO: 79% (2.1 TiB of 2.6 TiB) in 44m 54s, read: 2.6 GiB/s, write: 409.6 KiB/s

INFO: 80% (2.1 TiB of 2.6 TiB) in 45m 4s, read: 2.8 GiB/s, write: 0 B/s

INFO: 81% (2.1 TiB of 2.6 TiB) in 45m 15s, read: 2.6 GiB/s, write: 372.4 KiB/s

INFO: 82% (2.2 TiB of 2.6 TiB) in 45m 25s, read: 2.7 GiB/s, write: 0 B/s

INFO: 83% (2.2 TiB of 2.6 TiB) in 45m 36s, read: 2.5 GiB/s, write: 372.4 KiB/s

INFO: 84% (2.2 TiB of 2.6 TiB) in 45m 46s, read: 2.7 GiB/s, write: 0 B/s

INFO: 85% (2.2 TiB of 2.6 TiB) in 45m 56s, read: 2.7 GiB/s, write: 0 B/s

INFO: 86% (2.3 TiB of 2.6 TiB) in 46m 6s, read: 2.8 GiB/s, write: 0 B/s

INFO: 87% (2.3 TiB of 2.6 TiB) in 46m 16s, read: 2.5 GiB/s, write: 0 B/s

INFO: 88% (2.3 TiB of 2.6 TiB) in 46m 27s, read: 2.6 GiB/s, write: 0 B/s

INFO: 89% (2.3 TiB of 2.6 TiB) in 46m 37s, read: 2.6 GiB/s, write: 0 B/s

INFO: 90% (2.4 TiB of 2.6 TiB) in 46m 48s, read: 2.6 GiB/s, write: 0 B/s

INFO: 91% (2.4 TiB of 2.6 TiB) in 53m 41s, read: 61.5 MiB/s, write: 9.2 MiB/s

INFO: 92% (2.4 TiB of 2.6 TiB) in 1h 51m 30s, read: 8.0 MiB/s, write: 7.9 MiB/s

INFO: 93% (2.5 TiB of 2.6 TiB) in 2h 7m 59s, read: 28.2 MiB/s, write: 6.3 MiB/s

INFO: 94% (2.5 TiB of 2.6 TiB) in 2h 8m 8s, read: 3.1 GiB/s, write: 0 B/s

INFO: 95% (2.5 TiB of 2.6 TiB) in 2h 8m 17s, read: 3.1 GiB/s, write: 0 B/s

INFO: 96% (2.5 TiB of 2.6 TiB) in 2h 8m 26s, read: 3.0 GiB/s, write: 0 B/s

INFO: 97% (2.6 TiB of 2.6 TiB) in 2h 8m 36s, read: 2.7 GiB/s, write: 0 B/s

INFO: 98% (2.6 TiB of 2.6 TiB) in 2h 8m 44s, read: 3.3 GiB/s, write: 0 B/s

INFO: 99% (2.6 TiB of 2.6 TiB) in 2h 8m 52s, read: 3.3 GiB/s, write: 0 B/s