Guten Morgen,

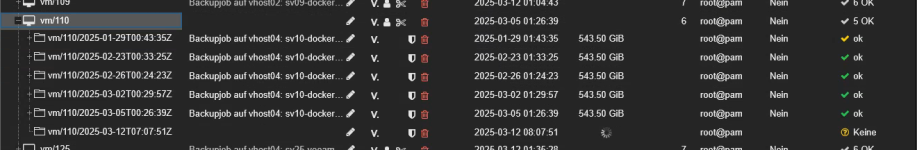

seit einer Woche schlägt das Backup genau einer VM fehl, während andere VMs und LXC Container weg gesichert werden.

Der Fehler sieht folgendermaßen aus:

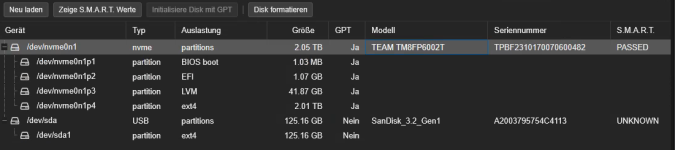

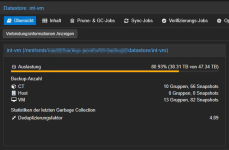

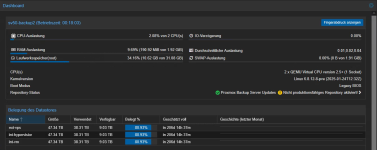

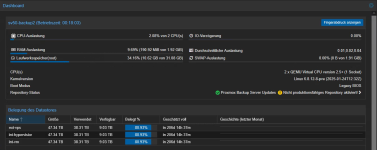

Ich sichere meine VMs per ProxmoxBackupServer weg.

Der PBS läuft in der Version 3.3.3 und ist per SMB an einen Storage angebunden.

Andere VMs werden regulär weg gesichert, weshalb ich verwirrt darüber bin, dass es eben bei dieser einen VM nicht funktioniert.

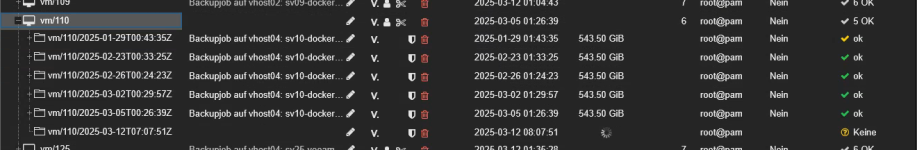

Ich würde behaupten, dass diese VM mit der ID 110 mit eine der größten VMs ist, die ich habe.

Ich habe letzte Woche eine Partition auf dieser VM um noch mal 16 GB erhöht (was ich schon oft gemacht habe, also nichts ungewöhnliches).

Ansonsten fällt mir erst mal nichts ein.

Auf dieser VM laufen nur Docker Container.

Hat jemand eine Idee?

Vielen Dank, Patrick

seit einer Woche schlägt das Backup genau einer VM fehl, während andere VMs und LXC Container weg gesichert werden.

Der Fehler sieht folgendermaßen aus:

Code:

Details

VMID Name Status Time Size Filename

110 sv10-docker02 err 15s 0 B null

Total running time: 15s

Total size: 0 B

Logs

vzdump 110 --node vhost04 --notification-mode auto --remove 0 --notes-template '{{guestname}}' --storage pbs_int-vm --mode suspend

110: 2025-03-12 08:07:51 INFO: Starting Backup of VM 110 (qemu)

110: 2025-03-12 08:07:51 INFO: status = running

110: 2025-03-12 08:07:51 INFO: backup mode: suspend

110: 2025-03-12 08:07:51 INFO: ionice priority: 7

110: 2025-03-12 08:07:51 INFO: VM Name: sv10-docker02

110: 2025-03-12 08:07:51 INFO: include disk 'scsi0' 'vmdata1:110/vm-110-disk-1.qcow2' 44544M

110: 2025-03-12 08:07:51 INFO: include disk 'scsi1' 'vmdata1:110/vm-110-disk-2.qcow2' 512G

110: 2025-03-12 08:07:51 INFO: include disk 'efidisk0' 'vmdata1:110/vm-110-disk-0.qcow2' 4M

110: 2025-03-12 08:07:51 INFO: suspending guest

110: 2025-03-12 08:07:52 INFO: creating Proxmox Backup Server archive 'vm/110/2025-03-12T07:07:51Z'

110: 2025-03-12 08:07:55 INFO: skipping guest-agent 'fs-freeze', agent configured but not running?

110: 2025-03-12 08:07:55 INFO: started backup task 'e4d95ab0-7e38-46eb-9cd5-d77c8bc2ba0c'

110: 2025-03-12 08:07:55 INFO: resuming VM again after 4 seconds

110: 2025-03-12 08:07:55 INFO: efidisk0: dirty-bitmap status: OK (drive clean)

110: 2025-03-12 08:07:55 INFO: scsi0: dirty-bitmap status: OK (9.3 GiB of 43.5 GiB dirty)

110: 2025-03-12 08:07:55 INFO: scsi1: dirty-bitmap status: existing bitmap was invalid and has been cleared

110: 2025-03-12 08:07:55 INFO: using fast incremental mode (dirty-bitmap), 521.3 GiB dirty of 555.5 GiB total

110: 2025-03-12 08:07:58 INFO: 0% (2.9 GiB of 521.3 GiB) in 3s, read: 989.3 MiB/s, write: 157.3 MiB/s

110: 2025-03-12 08:08:01 INFO: 1% (7.2 GiB of 521.3 GiB) in 6s, read: 1.4 GiB/s, write: 76.0 MiB/s

110: 2025-03-12 08:08:04 INFO: 2% (11.4 GiB of 521.3 GiB) in 9s, read: 1.4 GiB/s, write: 46.7 MiB/s

110: 2025-03-12 08:08:05 INFO: 2% (11.4 GiB of 521.3 GiB) in 10s, read: 4.0 MiB/s, write: 0 B/s

110: 2025-03-12 08:08:05 ERROR: job failed with err -61 - No data available

110: 2025-03-12 08:08:05 INFO: aborting backup job

110: 2025-03-12 08:08:05 INFO: resuming VM again

110: 2025-03-12 08:08:05 INFO: resume vm

110: 2025-03-12 08:08:06 ERROR: Backup of VM 110 failed - job failed with err -61 - No data availableIch sichere meine VMs per ProxmoxBackupServer weg.

Der PBS läuft in der Version 3.3.3 und ist per SMB an einen Storage angebunden.

Andere VMs werden regulär weg gesichert, weshalb ich verwirrt darüber bin, dass es eben bei dieser einen VM nicht funktioniert.

Ich würde behaupten, dass diese VM mit der ID 110 mit eine der größten VMs ist, die ich habe.

Ich habe letzte Woche eine Partition auf dieser VM um noch mal 16 GB erhöht (was ich schon oft gemacht habe, also nichts ungewöhnliches).

Ansonsten fällt mir erst mal nichts ein.

Auf dieser VM laufen nur Docker Container.

Hat jemand eine Idee?

Vielen Dank, Patrick