Guten Morgen

Aktuelle sichere ich meine Maschinen mit der internen Backup-Funktion über Nutzung von stop. Bisher bin ich davon ausgegangen dass die Maschine runterfährt, ein snapchat erstellt wird und die Maschine wieder startet. Die Sicherung erfolgt dann übern Nutzung des erstellten snapshots. Scheinbar ist das aber nicht der Fall da bei der Sicherung von den großen Maschinen der restart erst erfolgt nachdem das Backup komplett durch ist.

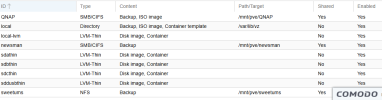

Das Volume ist dünn besetzt und unterstützt damit auch snapshots.

Ich habe das Forum schon gewälzt und noch die Doku aber so richtig schlau werde ich nicht daraus ob das nun eine Funktion von der internen Backup-Funktion ist oder ob ich dafür den Backup Server als solches benötige.

Daher meine Frage: kann ich über die interne Backup Funktion bei Nutzung von stop ein schnelles Backup erstellen bei dem die Maschine möglichst schnell wieder verfügbar ist und ich nicht warten muss bis das komplette Backup durch ist? Wenn nicht wie mache ich es dann?

Aktuelle sichere ich meine Maschinen mit der internen Backup-Funktion über Nutzung von stop. Bisher bin ich davon ausgegangen dass die Maschine runterfährt, ein snapchat erstellt wird und die Maschine wieder startet. Die Sicherung erfolgt dann übern Nutzung des erstellten snapshots. Scheinbar ist das aber nicht der Fall da bei der Sicherung von den großen Maschinen der restart erst erfolgt nachdem das Backup komplett durch ist.

Das Volume ist dünn besetzt und unterstützt damit auch snapshots.

Ich habe das Forum schon gewälzt und noch die Doku aber so richtig schlau werde ich nicht daraus ob das nun eine Funktion von der internen Backup-Funktion ist oder ob ich dafür den Backup Server als solches benötige.

Daher meine Frage: kann ich über die interne Backup Funktion bei Nutzung von stop ein schnelles Backup erstellen bei dem die Maschine möglichst schnell wieder verfügbar ist und ich nicht warten muss bis das komplette Backup durch ist? Wenn nicht wie mache ich es dann?