Wird die atime nicht für die cutoff-Tine bei der garbage vollection benötigt oder übersehe ich etwas?Noatime ist bei mir auch default, das bringt natürlich beim lesen eine Menge.

Performance Probleme

- Thread starter Nerion

- Start date

You are using an out of date browser. It may not display this or other websites correctly.

You should upgrade or use an alternative browser.

You should upgrade or use an alternative browser.

Die Garbage Collection prüft ob ob ein Chunk noch referenziert ist. Das löschen des letzten Chunks, was ja getrackt wird, ist ja kein lesen sondern auch ein schreiben. Atime ist ja access Time (lesen)

Soweit ich weiß setzt PBS das ohnehin explizit. Ich selbst nutze meist entweder

Relevant:

- https://forum.proxmox.com/threads/z...fect-on-garbage-collection.76590/#post-451830

- https://forum.proxmox.com/threads/pbs-datastore-on-zfs-dataset-without-atime.116383/#post-604652

relatime oder lazytime.Relevant:

- https://forum.proxmox.com/threads/z...fect-on-garbage-collection.76590/#post-451830

- https://forum.proxmox.com/threads/pbs-datastore-on-zfs-dataset-without-atime.116383/#post-604652

Last edited:

Kurzes Update.

Habe jetzt einen Server mit 12x NVMe auf ZFS aufgebaut mit Raidz2 und erste Tests sind sehr positiv.

Habe jetzt einen Server mit 12x NVMe auf ZFS aufgebaut mit Raidz2 und erste Tests sind sehr positiv.

Ich möchte hier noch ein finales Update geben. Nachdem wir nun alle PBS auf ZFS umgestellt haben, erreichen wir gigantische Backupzeiten und Datenübertragungsraten. Für alle die vor dem gleichen Problem stehen. Einfach auf ZFS umstellen, und das Problem ist gelöst.

Nochmals danke an alle, die hier im Thread geholfen haben.

Nochmals danke an alle, die hier im Thread geholfen haben.

Für PBS mach ich hier compression=off denn der PBS komprimiert ja seine chunks schon. Und doppelt gemoppelt bringt da m.E. nix.Habe mit ZFS keine Erfahrung. Hast da einen Best Practise Guide irgendwo? Muss ich da noch was einstellen?

z.B.

- compression=lz4

- atime=off

- recordsize=1M

- xattr=sa

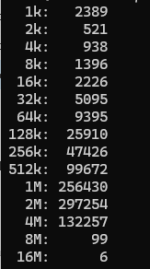

Haben Mann oder Frau auch eine Begründung dafür? M.E. spielen in der heutigen Welt kleine Dateien keine Rolle mehr.Default ist recordsize=128k, Mann und Frau gehen heute zu recordsize=64k über.

Code:

find /path/to/pbs-repo -type f -print0 | xargs -0 ls -l | awk '{ n=int(log($5)/log(2)); if (n<10) { n=10; } size[n]++ } END { for (i in size) printf("%d %d\n", 2^i, size[i]) }' | sort -n | awk 'function human(x) { x[1]/=1024; if (x[1]>=1024) { x[2]++; human(x) } } { a[1]=$1; a[2]=0; human(a); printf("%3d%s: %6d\n", a[1],substr("kMGTEPYZ",a[2]+1,1),$2) }'

Also der weitaus größte Teil der Dateien auch vom PBS liegt bei 1M oder größer. Daher steht bei mir die recordsize bei 1M.