Hallo zusammen,

ich habe auf einem ESXi Host (7.0u3s) mehrere nahezu identische VMs die ich auf einen Proxmox 8.3.5 migrieren will. Diese Unterscheiden sich nur durch die Disk und RAM Größe.

Auf den VMs läuft überall ein Windows 10 aktueller Patch Stand.

Bei einigen funktioniert die migration nach Anleitung ohne Probleme, d.h. VM startet mit SATA Disk, im Nachgang lassen sich auch die VirtIO Treiber nachinstallieren und die VM startet fehlerfrei mit SCSI Disk.

Bei ca. der hälfte der Maschinen bekomme ich aber nach dem Start der VM ein inaccessible boot device angezeigt.

Hier die config von einer funktionierenden Migration:

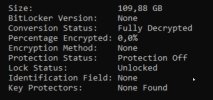

hier die von einer mit Inaccessible boot device:

Mir gehen ein wenig die Ideen aus wie ich die VMs noch zum booten bringen könnte.

Ein Versuch die VM manuell mit dem ovftool zu importieren und einzubinden bracht mir das selbe Resultat, also ein Inaccessible Boot Device.

Der Versuch den VirtIO Treiber per Reparaturconsole reinzuschmieren, wie erwartet ohne Erfolg da die VM auch ohne Treiber als SATA DIsk starten sollte.

Ich habe im BIOS eine neue Boot Option angelegt was in meinen Augen eher Sinnfrei ist da die VM selbst schon Bootet nur dann irgendwie die Windows Partition nicht zu finden scheint.

Hat jemand ggf. noch eine Idee was ich tun kann um die nicht laufenden VMs an rennen zu bringen? Ich würde ungerne die Kisten neu anlegen müssen.

Sollten noch weitere Informationen benötigt werden bringe ich die gerne.

Euch schon mal eine schöne Restwoche.

ich habe auf einem ESXi Host (7.0u3s) mehrere nahezu identische VMs die ich auf einen Proxmox 8.3.5 migrieren will. Diese Unterscheiden sich nur durch die Disk und RAM Größe.

Auf den VMs läuft überall ein Windows 10 aktueller Patch Stand.

Bei einigen funktioniert die migration nach Anleitung ohne Probleme, d.h. VM startet mit SATA Disk, im Nachgang lassen sich auch die VirtIO Treiber nachinstallieren und die VM startet fehlerfrei mit SCSI Disk.

Bei ca. der hälfte der Maschinen bekomme ich aber nach dem Start der VM ein inaccessible boot device angezeigt.

Hier die config von einer funktionierenden Migration:

Code:

root@inv-clg-pve1:~# qm config 103

bios: ovmf

boot: order=sata1

cores: 2

cpu: x86-64-v2-AES

efidisk0: local-zfs:vm-103-disk-0,size=1M

machine: pc-i440fx-9.2

memory: 8192

meta: creation-qemu=9.2.0,ctime=1743064722

name: Test-SLV9

net0: e1000e=00:50:56:b6:5e:61,bridge=vmbr0,tag=5

ostype: win10

sata0: local:iso/virtio-win-0.1.215.iso,media=cdrom,size=528308K

sata1: local-zfs:vm-103-disk-1,size=55G

scsihw: virtio-scsi-single

smbios1: uuid=4236b687-c4eb-8b6a-0c68-3cc84a02a4df

sockets: 2

vmgenid: fe828607-3c92-484a-ad2a-0d80775d0a4bhier die von einer mit Inaccessible boot device:

Code:

root@inv-clg-pve1:~# qm config 106

bios: ovmf

boot: order=sata1

cores: 8

cpu: x86-64-v2-AES

efidisk0: local-zfs:vm-106-disk-0,size=1M

machine: pc-i440fx-9.2

memory: 24576

meta: creation-qemu=9.2.0,ctime=1743080009

name: Test-SLV11

net0: e1000e=00:50:56:b6:ca:fb,bridge=vmbr0,tag=5

ostype: win10

sata0: local:iso/virtio-win-0.1.215.iso,media=cdrom,size=528308K

sata1: local-zfs:vm-106-disk-1,size=100G

scsihw: virtio-scsi-single

smbios1: uuid=4236721c-1a17-073b-9c82-a575782d9d12

sockets: 2

vmgenid: 8eb38437-b848-425b-b3ac-e558b07b2f08

Code:

root@inv-clg-pve1:~# pveversion -v

proxmox-ve: 8.3.0 (running kernel: 6.8.12-9-pve)

pve-manager: 8.3.5 (running version: 8.3.5/dac3aa88bac3f300)

proxmox-kernel-helper: 8.1.1

proxmox-kernel-6.8: 6.8.12-9

proxmox-kernel-6.8.12-9-pve-signed: 6.8.12-9

proxmox-kernel-6.8.12-8-pve-signed: 6.8.12-8

proxmox-kernel-6.8.12-4-pve-signed: 6.8.12-4

ceph-fuse: 17.2.7-pve3

corosync: 3.1.7-pve3

criu: 3.17.1-2+deb12u1

glusterfs-client: 10.3-5

ifupdown2: 3.2.0-1+pmx11

ksm-control-daemon: 1.5-1

libjs-extjs: 7.0.0-5

libknet1: 1.28-pve1

libproxmox-acme-perl: 1.6.0

libproxmox-backup-qemu0: 1.5.1

libproxmox-rs-perl: 0.3.5

libpve-access-control: 8.2.0

libpve-apiclient-perl: 3.3.2

libpve-cluster-api-perl: 8.0.10

libpve-cluster-perl: 8.0.10

libpve-common-perl: 8.2.9

libpve-guest-common-perl: 5.1.6

libpve-http-server-perl: 5.2.0

libpve-network-perl: 0.10.1

libpve-rs-perl: 0.9.2

libpve-storage-perl: 8.3.3

libspice-server1: 0.15.1-1

lvm2: 2.03.16-2

lxc-pve: 6.0.0-1

lxcfs: 6.0.0-pve2

novnc-pve: 1.5.0-1

proxmox-backup-client: 3.3.4-1

proxmox-backup-file-restore: 3.3.4-1

proxmox-firewall: 0.6.0

proxmox-kernel-helper: 8.1.1

proxmox-mail-forward: 0.3.1

proxmox-mini-journalreader: 1.4.0

proxmox-offline-mirror-helper: 0.6.7

proxmox-widget-toolkit: 4.3.7

pve-cluster: 8.0.10

pve-container: 5.2.4

pve-docs: 8.3.1

pve-edk2-firmware: 4.2023.08-4

pve-esxi-import-tools: 0.7.2

pve-firewall: 5.1.0

pve-firmware: 3.14-3

pve-ha-manager: 4.0.6

pve-i18n: 3.4.1

pve-qemu-kvm: 9.2.0-2

pve-xtermjs: 5.3.0-3

qemu-server: 8.3.8

smartmontools: 7.3-pve1

spiceterm: 3.3.0

swtpm: 0.8.0+pve1

vncterm: 1.8.0

zfsutils-linux: 2.2.7-pve2Mir gehen ein wenig die Ideen aus wie ich die VMs noch zum booten bringen könnte.

Ein Versuch die VM manuell mit dem ovftool zu importieren und einzubinden bracht mir das selbe Resultat, also ein Inaccessible Boot Device.

Der Versuch den VirtIO Treiber per Reparaturconsole reinzuschmieren, wie erwartet ohne Erfolg da die VM auch ohne Treiber als SATA DIsk starten sollte.

Ich habe im BIOS eine neue Boot Option angelegt was in meinen Augen eher Sinnfrei ist da die VM selbst schon Bootet nur dann irgendwie die Windows Partition nicht zu finden scheint.

Hat jemand ggf. noch eine Idee was ich tun kann um die nicht laufenden VMs an rennen zu bringen? Ich würde ungerne die Kisten neu anlegen müssen.

Sollten noch weitere Informationen benötigt werden bringe ich die gerne.

Euch schon mal eine schöne Restwoche.

Last edited: