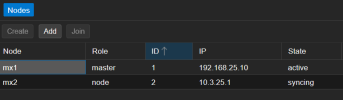

Ich habe einen privaten PMG Cluster aus zwei Nodes und musste diese woanders hinziehen und habe dabei auch deren Namen und IP-Adressen geändert.

Leider wird nun dauerhaft gesynct, ohne je fertig zu werden.

Hat jemand einen Tipp, woran das liegt und/oder wie noch etwas zu retten ist? Ggf. einen Node löschen und neu aufsetzen?

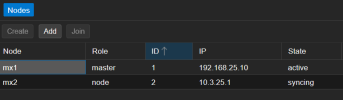

Auf der anderen Seite sieht es so aus.

Leider wird nun dauerhaft gesynct, ohne je fertig zu werden.

Hat jemand einen Tipp, woran das liegt und/oder wie noch etwas zu retten ist? Ggf. einen Node löschen und neu aufsetzen?

Code:

Mar 06 09:27:15 mx2 pmgtunnel[217]: restarting crashed tunnel 4082 192.168.25.10

Mar 06 09:27:16 mx2 pmgtunnel[217]: tunnel finished 4082 192.168.25.10

Mar 06 09:27:39 mx2 pmg-smtp-filter[2074]: starting database maintenance

Mar 06 09:27:39 mx2 pmg-smtp-filter[2074]: end database maintenance (8 ms)

Mar 06 09:28:20 mx2 pmgpolicy[370]: starting policy database maintenance (greylist, rbl)

Mar 06 09:28:20 mx2 pmgpolicy[370]: end policy database maintenance (32 ms, 5 ms)

Mar 06 09:28:24 mx2 pmgmirror[371]: starting cluster synchronization

Mar 06 09:28:25 mx2 pmgmirror[371]: sync error: syncing master configuration from '192.168.25.10' failed: rsync error: unexplained error (code 255) at io.c(232) [Receiver=3.2.7]

Mar 06 09:28:25 mx2 pmgtunnel[217]: restarting crashed tunnel 4092 192.168.25.10

Mar 06 09:28:25 mx2 pmgtunnel[217]: tunnel finished 4092 192.168.25.10

Mar 06 09:28:32 mx2 sshd[4094]: Accepted publickey for root from 192.168.25.10 port 53082 ssh2: RSA SHA256:AwBCbtpqBwxectJVz6ryGm9xZU25RCi/KwFHHFYlM8k

Mar 06 09:28:32 mx2 sshd[4094]: pam_unix(sshd:session): session opened for user root(uid=0) by (uid=0)

Mar 06 09:28:32 mx2 sshd[4094]: pam_env(sshd:session): deprecated reading of user environment enabled

Mar 06 09:28:32 mx2 sshd[4094]: Received disconnect from 192.168.25.10 port 53082:11: disconnected by user

Mar 06 09:28:32 mx2 sshd[4094]: Disconnected from user root 192.168.25.10 port 53082

Mar 06 09:28:32 mx2 sshd[4094]: pam_unix(sshd:session): session closed for user root

Mar 06 09:29:34 mx2 pmgtunnel[217]: restarting crashed tunnel 4105 192.168.25.10Auf der anderen Seite sieht es so aus.

Code:

Mar 06 09:27:16 mx1 sshd[4281]: Connection closed by 10.3.25.1 port 46528 [preauth]

Mar 06 09:27:59 mx1 pmgpolicy[335]: starting policy database maintenance (greylist, rbl)

Mar 06 09:27:59 mx1 pmgpolicy[335]: end policy database maintenance (15 ms, 1 ms)

Mar 06 09:28:25 mx1 sshd[4289]: Connection closed by 10.3.25.1 port 58988 [preauth]

Mar 06 09:28:25 mx1 sshd[4291]: Connection closed by 10.3.25.1 port 58998 [preauth]

Mar 06 09:28:32 mx1 pmgmirror[341]: starting cluster synchronization

Mar 06 09:28:33 mx1 pmgmirror[341]: cluster synchronization finished (0 errors, 0.96 seconds (files 0.62, database 0.34, config 0.00))

Mar 06 09:29:09 mx1 pmg-smtp-filter[1171]: starting database maintenance

Mar 06 09:29:09 mx1 pmg-smtp-filter[1171]: end database maintenance (6 ms)

Mar 06 09:29:35 mx1 sshd[4301]: Connection closed by 10.3.25.1 port 37334 [preauth]