Latest activity

-

BBu66as replied to the thread Umwandeln weil Notlage RAM.@ivenae, das ist ein sehr pragmatischer Ansatz. Gerade bei akuter Knappheit ist das Eliminieren von Variablen (Ballooning, KSM) oft zielführender als das Hoffen auf deren Effizienz. Wie @Falk R. bereits anmerkte, sind die PVE-Defaults oft...

-

BBu66as replied to the thread Proxmox mit ThinkSystem SR650.@bufalla, ja, der SR650 ist grundsätzlich voll kompatibel und ein sehr solides Arbeitspferd für Proxmox VE. Die CPU und vor allem die 256 GB RAM sind eine hervorragende Basis. Hier ein paar spezifische Anmerkungen zu deinen Komponenten: 1...

-

Kkfx replied to the thread Severe system freeze with NFS on Proxmox 9 running kernel 6.14.8-2-pve when mounting NFS shares.Same issue here: we had a perfectly working setup in PVE8 + OVS. With PVE9 (fully updated) the load on the VM explode suddenly, the share are unaccessible and we have to reboot the VM). The setup is as this: - A bare metal NFS server (debian 13...

-

BBu66as replied to the thread NAS UGreen DXP4800 Plus.@IsThisThingOn, du triffst den Nagel auf den Kopf. Das ist der klassische "Perfect Storm": Der Windows-NFS-Client ist per se ineffizient (Locking/Sync), und das dann kombiniert mit VM-Disk-Images auf einem ZFS-Dataset (CoW-on-CoW) potenziert die...

-

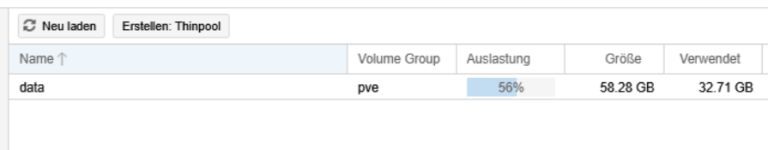

BBu66as replied to the thread Speicherverteilung (Bootdisk-Größe).@noidea, @Ernst T. bezieht sich auf die Werte aus deinem Screenshot unter Knoten 'proxmox' -> Disks -> LVM-Thin. Dort findest du den Eintrag data. Die Rechnung ist simpel: Größe (Gesamtkapazität des Pools) minus Verwendet (tatsächlich...

-

BBu66as replied to the thread Nach HW Tausch (identisch) seltsames Verhalten und kein Backup.Hallo @SteffenDE, das beschriebene Verhalten deutet stark darauf hin, dass durch die geänderten MAC-Adressen die Cluster-Kommunikation gestört ist und Zertifikate nicht mehr passen. Prüfe mittels ip a, ob die Namen der Netzwerkschnittstellen...

-

Eeexodus replied to the thread [SOLVED] Super slow, timeout, and VM stuck while backing up, after updated to PVE 9.1.1 and PBS 4.0.20.Worked, thank you!

-

Eeexodus reacted to sherminator's post in the thread [SOLVED] Super slow, timeout, and VM stuck while backing up, after updated to PVE 9.1.1 and PBS 4.0.20 with

Like.

Welcome to the party! In our case rebooting PBS into kernel 6.14.11-4-pve successfully workarounded the issue.

Like.

Welcome to the party! In our case rebooting PBS into kernel 6.14.11-4-pve successfully workarounded the issue. -

PPete5 posted the thread TrueNAS 25 Installation on Proxmox 9 in Proxmox VE: Installation and configuration.Hi all, I ran TrueNAS 24 on Proxmox 8 without any problems. I tried to do a new installation of TrueNAS 25 on Proxmox 9, without success so far. Hardware: Terramaster F4-424 Max I configured a VM like this Starting up the VM for installation...

-

SSteffenDE posted the thread Nach HW Tausch (identisch) seltsames Verhalten und kein Backup in Proxmox VE (Deutsch/German).Hallo, ich musste in meinem Cluster (2 Nodes + externem Quorum) einen Node tauschen. Identisches Systeme, Platten umgebaut und wieder gestartet. Grundsätzlich läuft der Cluster auch wieder, aber: - Seitdem poppt laufend das Login Fenster auf...

-

KKonstantinPVE reacted to sherminator's post in the thread [SOLVED] Super slow, timeout, and VM stuck while backing up, after updated to PVE 9.1.1 and PBS 4.0.20 with

Like.

Welcome to the party! In our case rebooting PBS into kernel 6.14.11-4-pve successfully workarounded the issue.

Like.

Welcome to the party! In our case rebooting PBS into kernel 6.14.11-4-pve successfully workarounded the issue. -

KKonstantinPVE replied to the thread [SOLVED] Super slow, timeout, and VM stuck while backing up, after updated to PVE 9.1.1 and PBS 4.0.20.Works perfectly, thank you! # Check available kernels proxmox-boot-tool kernel list # Pin working kernel proxmox-boot-tool kernel pin 6.14.11-4-pve # Rewrite bootloader entries (IMPORTANT) proxmox-boot-tool refresh # Reboot PBS reboot...

-

UdoB reacted to IsThisThingOn's post in the thread ZFS storage is very full, we would like to increase the space but... with

UdoB reacted to IsThisThingOn's post in the thread ZFS storage is very full, we would like to increase the space but... with Like.

Sorry, I misunderstood. In that case you can leave it. Sure. So Proxmox uses the good default of 16k volblocksize. That means that all your VMs ZFS raw disks, are offered 16k blocks. Now lets look how ZFS provides 16k blocks. You have RAIDZ1...

Like.

Sorry, I misunderstood. In that case you can leave it. Sure. So Proxmox uses the good default of 16k volblocksize. That means that all your VMs ZFS raw disks, are offered 16k blocks. Now lets look how ZFS provides 16k blocks. You have RAIDZ1... -

DDacron posted the thread Computer shutting down every morning around 3 that I didn't set to happen. in Proxmox VE: Installation and configuration.Hi I have Proxmox running on a mini pc with no other operating system. It's been running for around 3 years with no problems, I upgraded to 9 around a month ago again with no problems. For around a week now Ive been waking up every morning to...

-

gurubert reacted to Eduardo Taboada's post in the thread CEPH Probleme : 2 OSD(s) have spurious read errors with

gurubert reacted to Eduardo Taboada's post in the thread CEPH Probleme : 2 OSD(s) have spurious read errors with Like.

Is a good practice to separate Ceph data traffic in another interface or almost another VLAN and use 10 Gb or more for this traffic, You should keep in mind that modern SSDs have a very high transfer rate and need a network to match this...

Like.

Is a good practice to separate Ceph data traffic in another interface or almost another VLAN and use 10 Gb or more for this traffic, You should keep in mind that modern SSDs have a very high transfer rate and need a network to match this... -

gurubert reacted to Eduardo Taboada's post in the thread CEPH Probleme : 2 OSD(s) have spurious read errors with

gurubert reacted to Eduardo Taboada's post in the thread CEPH Probleme : 2 OSD(s) have spurious read errors with Like.

Is not a critical error, blueStore has recovered the failure, and the cause can be a puntual problem with the network, or some hardware element (controller, disk) but it appears to be for a low response of these OSD. To remove the warning: ceph...

Like.

Is not a critical error, blueStore has recovered the failure, and the cause can be a puntual problem with the network, or some hardware element (controller, disk) but it appears to be for a low response of these OSD. To remove the warning: ceph... -

Ggno posted the thread How can I access data of one LXC container from an other container? in Proxmox VE: Installation and configuration.Hello, I have a privileged LXC-103 that acts as fileserver. The files are stored on a ZFS subvol and provided to the users (family) by NFS. root@pve2:~# cat /etc/pve/lxc/103.conf ... features: mount=nfs;cifs,nesting=1 hostname: srv mp0...

-

IIsThisThingOn replied to the thread ZFS storage is very full, we would like to increase the space but....Sorry, I misunderstood. In that case you can leave it. Sure. So Proxmox uses the good default of 16k volblocksize. That means that all your VMs ZFS raw disks, are offered 16k blocks. Now lets look how ZFS provides 16k blocks. You have RAIDZ1...

-

Nnoidea replied to the thread Speicherverteilung (Bootdisk-Größe).Super. Vielen vielen Dank Euch allen für Eure tolle Unterstützung. Ich habe wirklich viel gelernt. Abschliessend würde ich gerne noch wissen, wo ich die Info mit dem Restspeicher ablesen kann. Das ist mir nämlich nach wie vor ein Rätsel.