Hallo zusammen...

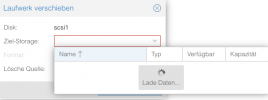

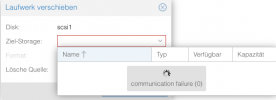

Seit einiger Zeit bekomme ich auf meinem Proxmoxserver beim Zugriff auf Storage-Informationen (im Webgui) keine Antwort mehr und nach einiger Zeit einen CommunicataionFailure(0)

Sei es beim Click auf den Storage in der Serveransicht oder auch beim Auswählen des storage für ein Backup oder beim Hinzufügen einer virtuellen Platte zu einer VM.

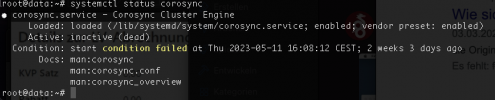

pvecm status bringt mir ein:

Error: Corosync config '/etc/pve/corosync.conf' does not exist - is this node part of a cluster?

Ist die corosync.conf nicht nur für Clusterbertrieb notwendig? Es ist aber ein Standalone-Node.

Ansonsten läuft alles ohne Störungen.

An was könnte das liegen?

pveversion zeigt:

proxmox-ve: 7.4-1 (running kernel: 5.15.107-2-pve)

pve-manager: 7.4-3 (running version: 7.4-3/9002ab8a)

pve-kernel-5.15: 7.4-3

pve-kernel-5.15.107-2-pve: 5.15.107-2

pve-kernel-5.15.102-1-pve: 5.15.102-1

ceph-fuse: 15.2.17-pve1

corosync: 3.1.7-pve1

criu: 3.15-1+pve-1

glusterfs-client: 9.2-1

ifupdown2: 3.1.0-1+pmx3

ksm-control-daemon: 1.4-1

libjs-extjs: 7.0.0-1

libknet1: 1.24-pve2

libproxmox-acme-perl: 1.4.4

libproxmox-backup-qemu0: 1.3.1-1

libproxmox-rs-perl: 0.2.1

libpve-access-control: 7.4-2

libpve-apiclient-perl: 3.2-1

libpve-common-perl: 7.4-1

libpve-guest-common-perl: 4.2-4

libpve-http-server-perl: 4.2-3

libpve-rs-perl: 0.7.6

libpve-storage-perl: 7.4-2

libspice-server1: 0.14.3-2.1

lvm2: 2.03.11-2.1

lxc-pve: 5.0.2-2

lxcfs: 5.0.3-pve1

novnc-pve: 1.4.0-1

proxmox-backup-client: 2.4.1-1

proxmox-backup-file-restore: 2.4.1-1

proxmox-kernel-helper: 7.4-1

proxmox-mail-forward: 0.1.1-1

proxmox-mini-journalreader: 1.3-1

proxmox-widget-toolkit: 3.6.5

pve-cluster: 7.3-3

pve-container: 4.4-3

pve-docs: 7.4-2

pve-edk2-firmware: 3.20230228-2

pve-firewall: 4.3-1

pve-firmware: 3.6-5

pve-ha-manager: 3.6.1

pve-i18n: 2.12-1

pve-qemu-kvm: 7.2.0-8

pve-xtermjs: 4.16.0-1

qemu-server: 7.4-3

smartmontools: 7.2-pve3

spiceterm: 3.2-2

swtpm: 0.8.0~bpo11+3

vncterm: 1.7-1

zfsutils-linux: 2.1.11-pve1

Seit einiger Zeit bekomme ich auf meinem Proxmoxserver beim Zugriff auf Storage-Informationen (im Webgui) keine Antwort mehr und nach einiger Zeit einen CommunicataionFailure(0)

Sei es beim Click auf den Storage in der Serveransicht oder auch beim Auswählen des storage für ein Backup oder beim Hinzufügen einer virtuellen Platte zu einer VM.

pvecm status bringt mir ein:

Error: Corosync config '/etc/pve/corosync.conf' does not exist - is this node part of a cluster?

Ist die corosync.conf nicht nur für Clusterbertrieb notwendig? Es ist aber ein Standalone-Node.

Ansonsten läuft alles ohne Störungen.

An was könnte das liegen?

pveversion zeigt:

proxmox-ve: 7.4-1 (running kernel: 5.15.107-2-pve)

pve-manager: 7.4-3 (running version: 7.4-3/9002ab8a)

pve-kernel-5.15: 7.4-3

pve-kernel-5.15.107-2-pve: 5.15.107-2

pve-kernel-5.15.102-1-pve: 5.15.102-1

ceph-fuse: 15.2.17-pve1

corosync: 3.1.7-pve1

criu: 3.15-1+pve-1

glusterfs-client: 9.2-1

ifupdown2: 3.1.0-1+pmx3

ksm-control-daemon: 1.4-1

libjs-extjs: 7.0.0-1

libknet1: 1.24-pve2

libproxmox-acme-perl: 1.4.4

libproxmox-backup-qemu0: 1.3.1-1

libproxmox-rs-perl: 0.2.1

libpve-access-control: 7.4-2

libpve-apiclient-perl: 3.2-1

libpve-common-perl: 7.4-1

libpve-guest-common-perl: 4.2-4

libpve-http-server-perl: 4.2-3

libpve-rs-perl: 0.7.6

libpve-storage-perl: 7.4-2

libspice-server1: 0.14.3-2.1

lvm2: 2.03.11-2.1

lxc-pve: 5.0.2-2

lxcfs: 5.0.3-pve1

novnc-pve: 1.4.0-1

proxmox-backup-client: 2.4.1-1

proxmox-backup-file-restore: 2.4.1-1

proxmox-kernel-helper: 7.4-1

proxmox-mail-forward: 0.1.1-1

proxmox-mini-journalreader: 1.3-1

proxmox-widget-toolkit: 3.6.5

pve-cluster: 7.3-3

pve-container: 4.4-3

pve-docs: 7.4-2

pve-edk2-firmware: 3.20230228-2

pve-firewall: 4.3-1

pve-firmware: 3.6-5

pve-ha-manager: 3.6.1

pve-i18n: 2.12-1

pve-qemu-kvm: 7.2.0-8

pve-xtermjs: 4.16.0-1

qemu-server: 7.4-3

smartmontools: 7.2-pve3

spiceterm: 3.2-2

swtpm: 0.8.0~bpo11+3

vncterm: 1.7-1

zfsutils-linux: 2.1.11-pve1