Hallo

also ZFS ist irgendwo noch ein Rätzel. Ich teste damit nebenbei und habe auch einen Backupserver zum Test damit laufen, aber so ganz blicke ich nicht durch.

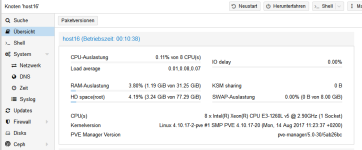

Es geht um einen Host Proxmox V5, auf dem zwei VMs installiert sind (vm101 und vm241). Eine ist inaktiv und die andere ist ein Debian mit einem BackupPC-Script drauf. Nur vm241 ist aktiv.

Jetzt ist vm241 "voll", so das ich wede die Konsole aufrufen kann noch die vm ordnungsgemäß herunterfahren kann. Auf der vm selbst kann ich aber nicht erkennen, wie so viel Plattenspeicher verbraucht wird.

Wo finde ich auf dem Hostsystem die vms?

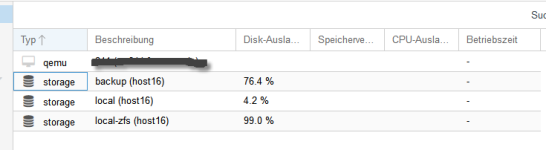

/rpool/data scheint ja voll zu sein, aber welche Pfad ist das? Wenn ich mit SSH nachsehe steht dort nichts drin?

Ich komme hier gerade nicht weiter.

also ZFS ist irgendwo noch ein Rätzel. Ich teste damit nebenbei und habe auch einen Backupserver zum Test damit laufen, aber so ganz blicke ich nicht durch.

Es geht um einen Host Proxmox V5, auf dem zwei VMs installiert sind (vm101 und vm241). Eine ist inaktiv und die andere ist ein Debian mit einem BackupPC-Script drauf. Nur vm241 ist aktiv.

Code:

root@host16:~# zpool status

pool: rpool

state: ONLINE

scan: scrub repaired 0 in 19h29m with 0 errors on Sun Aug 13 19:53:41 2017

config:

NAME STATE READ WRITE CKSUM

rpool ONLINE 0 0 0

raidz1-0 ONLINE 0 0 0

sda2 ONLINE 0 0 0

sdb2 ONLINE 0 0 0

sdc2 ONLINE 0 0 0

errors: No known data errors

root@host16:~# zfs list

NAME USED AVAIL REFER MOUNTPOINT

rpool 7.02T 0 128K /rpool

rpool/ROOT 3.52G 0 128K /rpool/ROOT

rpool/ROOT/pve-1 3.52G 0 3.52G /

rpool/data 7.00T 0 128K /rpool/data

rpool/data/vm-101-disk-1 73.8G 0 73.8G -

rpool/data/vm-241-disk-1 6.93T 0 6.93T -

rpool/swap 8.50G 7.48G 1.03G -Jetzt ist vm241 "voll", so das ich wede die Konsole aufrufen kann noch die vm ordnungsgemäß herunterfahren kann. Auf der vm selbst kann ich aber nicht erkennen, wie so viel Plattenspeicher verbraucht wird.

Wo finde ich auf dem Hostsystem die vms?

/rpool/data scheint ja voll zu sein, aber welche Pfad ist das? Wenn ich mit SSH nachsehe steht dort nichts drin?

Ich komme hier gerade nicht weiter.