Guten Morgen zusammen,

ich teste aktuell einen neuen Server mit zfs-raid10. Dabei ist mir aufgefallen, dass die Schreibperformance deutlich hinter den Erwartungen zurückbleibt.

Ich plane die Verwendung von 2 zfs-pools. Einen mirror aus 2 ssds für das Betriebssystem und einen Verbund aus 8 ssds im zfs-raid10.

Jetzt stellt sich per fio raus, dass die Schreibperformance mit zfs erheblich schlechter ist, als per Hardware-RAID (ohne Puffer).

Zum testen verwende ich aktuell Consumer-SSDs. Dass die Performance insbesondere bei random-IOPS nicht mit Enterprise-Hardware mithalten kann, ist mir bewusst. Trotzdem sollte sich das ja beim RAID-Controller und bei ZFS ähnlich stark auswirken.

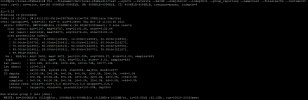

Hier der Test mit Hardware-RAID10:

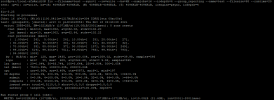

Und hier der Test im ZFS-Raid10:

Sonstiges zum System:

Raid-Controller: LSI MegaRAID SAS 9341-4i (für zfs-Test im JBOD-Modus)

RAM: 256GB DDR4

CPU 2x Xeon E5-2658 v4

Da das Dateisystem noch mehr oder weniger leer ist und die CPUs eigentlich nur vor sich hindümpeln, habe ich keine Idee mehr, was bei ZFS der bottleneck sein könnte und bin dankbar für Ideen.

Viele Grüße

Speedformer

ich teste aktuell einen neuen Server mit zfs-raid10. Dabei ist mir aufgefallen, dass die Schreibperformance deutlich hinter den Erwartungen zurückbleibt.

Ich plane die Verwendung von 2 zfs-pools. Einen mirror aus 2 ssds für das Betriebssystem und einen Verbund aus 8 ssds im zfs-raid10.

Jetzt stellt sich per fio raus, dass die Schreibperformance mit zfs erheblich schlechter ist, als per Hardware-RAID (ohne Puffer).

Zum testen verwende ich aktuell Consumer-SSDs. Dass die Performance insbesondere bei random-IOPS nicht mit Enterprise-Hardware mithalten kann, ist mir bewusst. Trotzdem sollte sich das ja beim RAID-Controller und bei ZFS ähnlich stark auswirken.

Hier der Test mit Hardware-RAID10:

Und hier der Test im ZFS-Raid10:

Sonstiges zum System:

Raid-Controller: LSI MegaRAID SAS 9341-4i (für zfs-Test im JBOD-Modus)

RAM: 256GB DDR4

CPU 2x Xeon E5-2658 v4

Da das Dateisystem noch mehr oder weniger leer ist und die CPUs eigentlich nur vor sich hindümpeln, habe ich keine Idee mehr, was bei ZFS der bottleneck sein könnte und bin dankbar für Ideen.

Viele Grüße

Speedformer