Hallo liebe Forengemeinde,

ich habe schon wieder ein Problem mit meinem ZFS-Pool Import beim Booten.

Dieses Mal komme ich wenigstens über ssh auf den PVE-Server.

Ich habe auch keine Ahnung was ich dieses Mal verstellt habe. Alles was mir heute Morgen schon spanisch vor kam, dass mir der PVE bzw. NUT ab 3:30 Uhr (nach meinem täglichen PBS-Backup) alle 7 Min. eine E-Mail geschickt hat, weil meine USV nicht mehr erreichbar war.

Die Weboberfläche war ebenfalls erreichbar und mit etwas Unwohlsein habe ich dann die

USB-Kabel geprüft und den PVE neu gestartet.

Dann ging nichts mehr.

Ich habe vor ca. 3-4 Wochen eine 4 Port LAN PCIe-Karte eingebaut, dass alte bond entfernt und alle 4 Ports mit LACP über die PCIe laufen lassen. Hat eigentlich auch gut funktioniert, der Switch (unifi US-24-G1) kann LACP und reboot´s haben auch keine Probleme bereitet.

Ich hoffe, Ihr könnt mir weiterhelfen, ich hänge mal wieder fest ☹

Vielen Dank!!

und die gekürzte journalctl -b

Solltet Ihr noch weitere Infos benötigen reiche ich sie heute Abend nach!

Gruß und danke

Frank

ich habe schon wieder ein Problem mit meinem ZFS-Pool Import beim Booten.

Dieses Mal komme ich wenigstens über ssh auf den PVE-Server.

Ich habe auch keine Ahnung was ich dieses Mal verstellt habe. Alles was mir heute Morgen schon spanisch vor kam, dass mir der PVE bzw. NUT ab 3:30 Uhr (nach meinem täglichen PBS-Backup) alle 7 Min. eine E-Mail geschickt hat, weil meine USV nicht mehr erreichbar war.

Die Weboberfläche war ebenfalls erreichbar und mit etwas Unwohlsein habe ich dann die

USB-Kabel geprüft und den PVE neu gestartet.

Dann ging nichts mehr.

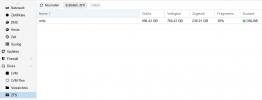

journalctl -b zeigt mir unter anderem auch Probleme mit dem Netzwerk an (bond1).Ich habe vor ca. 3-4 Wochen eine 4 Port LAN PCIe-Karte eingebaut, dass alte bond entfernt und alle 4 Ports mit LACP über die PCIe laufen lassen. Hat eigentlich auch gut funktioniert, der Switch (unifi US-24-G1) kann LACP und reboot´s haben auch keine Probleme bereitet.

Ich hoffe, Ihr könnt mir weiterhelfen, ich hänge mal wieder fest ☹

Vielen Dank!!

pool: vmfs

state: ONLINE

status: Some supported features are not enabled on the pool. The pool can

still be used, but some features are unavailable.

action: Enable all features using 'zpool upgrade'. Once this is done,

the pool may no longer be accessible by software that does not support

the features. See zpool-features(5) for details.

scan: scrub repaired 0B in 00:05:46 with 0 errors on Sun Nov 14 00:29:47 2021

config:

NAME STATE READ WRITE CKSUM

vmfs ONLINE 0 0 0

nvme-Samsung_SSD_970_EVO_1TB_S5H9NS0NA85234E ONLINE 0 0 0

errors: No known data errors

state: ONLINE

status: Some supported features are not enabled on the pool. The pool can

still be used, but some features are unavailable.

action: Enable all features using 'zpool upgrade'. Once this is done,

the pool may no longer be accessible by software that does not support

the features. See zpool-features(5) for details.

scan: scrub repaired 0B in 00:05:46 with 0 errors on Sun Nov 14 00:29:47 2021

config:

NAME STATE READ WRITE CKSUM

vmfs ONLINE 0 0 0

nvme-Samsung_SSD_970_EVO_1TB_S5H9NS0NA85234E ONLINE 0 0 0

errors: No known data errors

sysfs on /sys type sysfs (rw,nosuid,nodev,noexec,relatime)

proc on /proc type proc (rw,relatime)

udev on /dev type devtmpfs (rw,nosuid,relatime,size=16358304k,nr_inodes=4089576,mode=755)

devpts on /dev/pts type devpts (rw,nosuid,noexec,relatime,gid=5,mode=620,ptmxmode=000)

tmpfs on /run type tmpfs (rw,nosuid,noexec,relatime,size=3277240k,mode=755)

/dev/mapper/pve-root on / type ext4 (rw,relatime,errors=remount-ro)

securityfs on /sys/kernel/security type securityfs (rw,nosuid,nodev,noexec,relatime)

tmpfs on /dev/shm type tmpfs (rw,nosuid,nodev)

tmpfs on /run/lock type tmpfs (rw,nosuid,nodev,noexec,relatime,size=5120k)

tmpfs on /sys/fs/cgroup type tmpfs (ro,nosuid,nodev,noexec,mode=755)

cgroup2 on /sys/fs/cgroup/unified type cgroup2 (rw,nosuid,nodev,noexec,relatime)

cgroup on /sys/fs/cgroup/systemd type cgroup (rw,nosuid,nodev,noexec,relatime,xattr,name=systemd)

pstore on /sys/fs/pstore type pstore (rw,nosuid,nodev,noexec,relatime)

efivarfs on /sys/firmware/efi/efivars type efivarfs (rw,nosuid,nodev,noexec,relatime)

none on /sys/fs/bpf type bpf (rw,nosuid,nodev,noexec,relatime,mode=700)

cgroup on /sys/fs/cgroup/freezer type cgroup (rw,nosuid,nodev,noexec,relatime,freezer)

cgroup on /sys/fs/cgroup/cpu,cpuacct type cgroup (rw,nosuid,nodev,noexec,relatime,cpu,cpuacct)

cgroup on /sys/fs/cgroup/devices type cgroup (rw,nosuid,nodev,noexec,relatime,devices)

cgroup on /sys/fs/cgroup/net_cls,net_prio type cgroup (rw,nosuid,nodev,noexec,relatime,net_cls,net_prio)

cgroup on /sys/fs/cgroup/blkio type cgroup (rw,nosuid,nodev,noexec,relatime,blkio)

cgroup on /sys/fs/cgroup/cpuset type cgroup (rw,nosuid,nodev,noexec,relatime,cpuset)

cgroup on /sys/fs/cgroup/memory type cgroup (rw,nosuid,nodev,noexec,relatime,memory)

cgroup on /sys/fs/cgroup/rdma type cgroup (rw,nosuid,nodev,noexec,relatime,rdma)

cgroup on /sys/fs/cgroup/perf_event type cgroup (rw,nosuid,nodev,noexec,relatime,perf_event)

cgroup on /sys/fs/cgroup/hugetlb type cgroup (rw,nosuid,nodev,noexec,relatime,hugetlb)

cgroup on /sys/fs/cgroup/pids type cgroup (rw,nosuid,nodev,noexec,relatime,pids)

debugfs on /sys/kernel/debug type debugfs (rw,relatime)

mqueue on /dev/mqueue type mqueue (rw,relatime)

systemd-1 on /proc/sys/fs/binfmt_misc type autofs (rw,relatime,fd=44,pgrp=1,timeout=0,minproto=5,maxproto=5,direct,pipe_ino=18815)

hugetlbfs on /dev/hugepages type hugetlbfs (rw,relatime,pagesize=2M)

sunrpc on /run/rpc_pipefs type rpc_pipefs (rw,relatime)

configfs on /sys/kernel/config type configfs (rw,relatime)

fusectl on /sys/fs/fuse/connections type fusectl (rw,relatime)

/dev/sdc1 on /mnt/multimedia type ext4 (rw,relatime)

/dev/sdd1 on /mnt/tv type ext4 (rw,relatime)

/dev/sdb1 on /mnt/daten type ext4 (rw,relatime)

vmfs on /vmfs type zfs (rw,xattr,noacl)

vmfs/subvol-100-disk-0 on /vmfs/subvol-100-disk-0 type zfs (rw,xattr,posixacl)

vmfs/subvol-101-disk-0 on /vmfs/subvol-101-disk-0 type zfs (rw,xattr,posixacl)

vmfs/subvol-104-disk-0 on /vmfs/subvol-104-disk-0 type zfs (rw,xattr,posixacl)

vmfs/subvol-106-disk-0 on /vmfs/subvol-106-disk-0 type zfs (rw,xattr,posixacl)

vmfs/subvol-102-disk-0 on /vmfs/subvol-102-disk-0 type zfs (rw,xattr,posixacl)

vmfs/subvol-117-disk-0 on /vmfs/subvol-117-disk-0 type zfs (rw,xattr,posixacl)

vmfs/subvol-108-disk-0 on /vmfs/subvol-108-disk-0 type zfs (rw,xattr,posixacl)

vmfs/subvol-103-disk-0 on /vmfs/subvol-103-disk-0 type zfs (rw,xattr,posixacl)

lxcfs on /var/lib/lxcfs type fuse.lxcfs (rw,nosuid,nodev,relatime,user_id=0,group_id=0,allow_other)

tmpfs on /run/user/1000 type tmpfs (rw,nosuid,nodev,relatime,size=3277236k,mode=700,uid=1000,gid=1001)

proc on /proc type proc (rw,relatime)

udev on /dev type devtmpfs (rw,nosuid,relatime,size=16358304k,nr_inodes=4089576,mode=755)

devpts on /dev/pts type devpts (rw,nosuid,noexec,relatime,gid=5,mode=620,ptmxmode=000)

tmpfs on /run type tmpfs (rw,nosuid,noexec,relatime,size=3277240k,mode=755)

/dev/mapper/pve-root on / type ext4 (rw,relatime,errors=remount-ro)

securityfs on /sys/kernel/security type securityfs (rw,nosuid,nodev,noexec,relatime)

tmpfs on /dev/shm type tmpfs (rw,nosuid,nodev)

tmpfs on /run/lock type tmpfs (rw,nosuid,nodev,noexec,relatime,size=5120k)

tmpfs on /sys/fs/cgroup type tmpfs (ro,nosuid,nodev,noexec,mode=755)

cgroup2 on /sys/fs/cgroup/unified type cgroup2 (rw,nosuid,nodev,noexec,relatime)

cgroup on /sys/fs/cgroup/systemd type cgroup (rw,nosuid,nodev,noexec,relatime,xattr,name=systemd)

pstore on /sys/fs/pstore type pstore (rw,nosuid,nodev,noexec,relatime)

efivarfs on /sys/firmware/efi/efivars type efivarfs (rw,nosuid,nodev,noexec,relatime)

none on /sys/fs/bpf type bpf (rw,nosuid,nodev,noexec,relatime,mode=700)

cgroup on /sys/fs/cgroup/freezer type cgroup (rw,nosuid,nodev,noexec,relatime,freezer)

cgroup on /sys/fs/cgroup/cpu,cpuacct type cgroup (rw,nosuid,nodev,noexec,relatime,cpu,cpuacct)

cgroup on /sys/fs/cgroup/devices type cgroup (rw,nosuid,nodev,noexec,relatime,devices)

cgroup on /sys/fs/cgroup/net_cls,net_prio type cgroup (rw,nosuid,nodev,noexec,relatime,net_cls,net_prio)

cgroup on /sys/fs/cgroup/blkio type cgroup (rw,nosuid,nodev,noexec,relatime,blkio)

cgroup on /sys/fs/cgroup/cpuset type cgroup (rw,nosuid,nodev,noexec,relatime,cpuset)

cgroup on /sys/fs/cgroup/memory type cgroup (rw,nosuid,nodev,noexec,relatime,memory)

cgroup on /sys/fs/cgroup/rdma type cgroup (rw,nosuid,nodev,noexec,relatime,rdma)

cgroup on /sys/fs/cgroup/perf_event type cgroup (rw,nosuid,nodev,noexec,relatime,perf_event)

cgroup on /sys/fs/cgroup/hugetlb type cgroup (rw,nosuid,nodev,noexec,relatime,hugetlb)

cgroup on /sys/fs/cgroup/pids type cgroup (rw,nosuid,nodev,noexec,relatime,pids)

debugfs on /sys/kernel/debug type debugfs (rw,relatime)

mqueue on /dev/mqueue type mqueue (rw,relatime)

systemd-1 on /proc/sys/fs/binfmt_misc type autofs (rw,relatime,fd=44,pgrp=1,timeout=0,minproto=5,maxproto=5,direct,pipe_ino=18815)

hugetlbfs on /dev/hugepages type hugetlbfs (rw,relatime,pagesize=2M)

sunrpc on /run/rpc_pipefs type rpc_pipefs (rw,relatime)

configfs on /sys/kernel/config type configfs (rw,relatime)

fusectl on /sys/fs/fuse/connections type fusectl (rw,relatime)

/dev/sdc1 on /mnt/multimedia type ext4 (rw,relatime)

/dev/sdd1 on /mnt/tv type ext4 (rw,relatime)

/dev/sdb1 on /mnt/daten type ext4 (rw,relatime)

vmfs on /vmfs type zfs (rw,xattr,noacl)

vmfs/subvol-100-disk-0 on /vmfs/subvol-100-disk-0 type zfs (rw,xattr,posixacl)

vmfs/subvol-101-disk-0 on /vmfs/subvol-101-disk-0 type zfs (rw,xattr,posixacl)

vmfs/subvol-104-disk-0 on /vmfs/subvol-104-disk-0 type zfs (rw,xattr,posixacl)

vmfs/subvol-106-disk-0 on /vmfs/subvol-106-disk-0 type zfs (rw,xattr,posixacl)

vmfs/subvol-102-disk-0 on /vmfs/subvol-102-disk-0 type zfs (rw,xattr,posixacl)

vmfs/subvol-117-disk-0 on /vmfs/subvol-117-disk-0 type zfs (rw,xattr,posixacl)

vmfs/subvol-108-disk-0 on /vmfs/subvol-108-disk-0 type zfs (rw,xattr,posixacl)

vmfs/subvol-103-disk-0 on /vmfs/subvol-103-disk-0 type zfs (rw,xattr,posixacl)

lxcfs on /var/lib/lxcfs type fuse.lxcfs (rw,nosuid,nodev,relatime,user_id=0,group_id=0,allow_other)

tmpfs on /run/user/1000 type tmpfs (rw,nosuid,nodev,relatime,size=3277236k,mode=700,uid=1000,gid=1001)

und die gekürzte journalctl -b

Nov 23 23:07:47 proxmox systemd-udevd[483]: link_config: autonegotiation is unset or enabled, the speed and duplex are not writable.

Nov 23 23:07:47 proxmox kernel: iwlwifi 0000:08:00.0 wlp8s0: renamed from wlan0

Nov 23 23:07:47 proxmox kernel: Adding 8388604k swap on /dev/mapper/pve-swap. Priority:-2 extents:1 across:8388604k SSFS

Nov 23 23:07:47 proxmox systemd[1]: Activated swap /dev/pve/swap.

Nov 23 23:07:47 proxmox systemd[1]: Reached target Swap.

Nov 23 23:07:47 proxmox systemd-udevd[488]: Using default interface naming scheme 'v240'.

Nov 23 23:07:47 proxmox systemd[1]: Started udev Wait for Complete Device Initialization.

Nov 23 23:07:47 proxmox systemd[1]: Started Helper to synchronize boot up for ifupdown.

Nov 23 23:07:47 proxmox systemd[1]: Starting Import ZFS pools by cache file...

Nov 23 23:07:47 proxmox systemd[1]: Starting Import ZFS pool vmfs...

Nov 23 23:07:47 proxmox systemd-fsck[649]: /dev/sdc1: clean, 18071/244195328 files, 599009636/976754176 blocks

Nov 23 23:07:47 proxmox systemd-fsck[651]: tv: clean, 76/244195328 files, 66346688/976754176 blocks

Nov 23 23:07:47 proxmox systemd-fsck[652]: hdd-int: clean, 1344430/244191232 files, 1012724008/1953506304 blocks

Nov 23 23:07:47 proxmox lvm[650]: 10 logical volume(s) in volume group "pve" now active

Nov 23 23:07:47 proxmox systemd[1]: Started File System Check on /dev/disk/by-uuid/3dee70c0-6fb0-4a7b-a743-8cd9cc3d23fa.

Nov 23 23:07:47 proxmox systemd[1]: mnt-tv.mount: Directory /mnt/tv to mount over is not empty, mounting anyway.

Nov 23 23:07:47 proxmox systemd[1]: Mounting /mnt/tv...

Nov 23 23:07:47 proxmox systemd[1]: Started File System Check on /dev/disk/by-uuid/44bd59c9-03ef-4d4f-ba52-a9144666e6dd.

Nov 23 23:07:47 proxmox systemd[1]: Mounting /mnt/daten...

Nov 23 23:07:47 proxmox systemd[1]: Started LVM event activation on device 8:3.

Nov 23 23:07:47 proxmox zpool[663]: cannot import 'vmfs': no such pool available

Nov 23 23:07:47 proxmox systemd[1]: Started File System Check on /dev/disk/by-uuid/5258a109-ecd6-4a59-89c4-08b4adb59e69.

Nov 23 23:07:47 proxmox systemd[1]: Mounting /mnt/multimedia...

Nov 23 23:07:47 proxmox systemd[1]: zfs-import@vmfs.service: Main process exited, code=exited, status=1/FAILURE

Nov 23 23:07:47 proxmox systemd[1]: zfs-import@vmfs.service: Failed with result 'exit-code'.

Nov 23 23:07:47 proxmox systemd[1]: Failed to start Import ZFS pool vmfs.

Nov 23 23:07:47 proxmox systemd[1]: Mounted /mnt/multimedia.

Nov 23 23:07:47 proxmox kernel: EXT4-fs (sdc1): mounted filesystem with ordered data mode. Opts: (null)

Nov 23 23:07:47 proxmox systemd[1]: Mounted /mnt/tv.

Nov 23 23:07:47 proxmox kernel: EXT4-fs (sdd1): mounted filesystem with ordered data mode. Opts: (null)

Nov 23 23:07:47 proxmox kernel: EXT4-fs (sdb1): mounted filesystem with ordered data mode. Opts: (null)

Nov 23 23:07:47 proxmox systemd[1]: Mounted /mnt/daten.

Nov 23 23:07:47 proxmox kernel: zd0: p1 p2 p3

Nov 23 23:07:47 proxmox kernel: zd32: p1 p2

Nov 23 23:07:47 proxmox kernel: zd48: p1 p2 p3 p4

Nov 23 23:07:47 proxmox kernel: zd64: p1 p2 < p5 >

Nov 23 23:07:47 proxmox kernel: zd80: p1 p2

Nov 23 23:07:47 proxmox kernel: zd96: p1 p2 < p5 >

Nov 23 23:07:47 proxmox kernel: zd112: p1 p2 p3

Nov 23 23:07:47 proxmox systemd[1]: Started Import ZFS pools by cache file.

Nov 23 23:07:47 proxmox systemd[1]: Reached target ZFS pool import target.

Nov 23 23:07:47 proxmox systemd[1]: Starting Mount ZFS filesystems...

Nov 23 23:07:47 proxmox systemd[1]: Starting Wait for ZFS Volume (zvol) links in /dev...

Nov 23 23:07:47 proxmox systemd[1]: Started Mount ZFS filesystems.

Nov 23 23:07:47 proxmox systemd[1]: Reached target Local File Systems.

Nov 23 23:07:47 proxmox systemd[1]: Condition check resulted in Commit a transient machine-id on disk being skipped.

Nov 23 23:07:47 proxmox systemd[1]: Starting Set console font and keymap...

Nov 23 23:07:47 proxmox systemd[1]: Starting Load AppArmor profiles...

Nov 23 23:07:47 proxmox systemd[1]: Starting Create Volatile Files and Directories...

Nov 23 23:07:47 proxmox systemd[1]: Starting Proxmox VE firewall logger...

Nov 23 23:07:47 proxmox systemd[1]: Starting Proxmox VE Login Banner...

Nov 23 23:07:47 proxmox systemd[1]: Starting Commit Proxmox VE network changes...

Nov 23 23:07:47 proxmox kernel: iwlwifi 0000:08:00.0 wlp8s0: renamed from wlan0

Nov 23 23:07:47 proxmox kernel: Adding 8388604k swap on /dev/mapper/pve-swap. Priority:-2 extents:1 across:8388604k SSFS

Nov 23 23:07:47 proxmox systemd[1]: Activated swap /dev/pve/swap.

Nov 23 23:07:47 proxmox systemd[1]: Reached target Swap.

Nov 23 23:07:47 proxmox systemd-udevd[488]: Using default interface naming scheme 'v240'.

Nov 23 23:07:47 proxmox systemd[1]: Started udev Wait for Complete Device Initialization.

Nov 23 23:07:47 proxmox systemd[1]: Started Helper to synchronize boot up for ifupdown.

Nov 23 23:07:47 proxmox systemd[1]: Starting Import ZFS pools by cache file...

Nov 23 23:07:47 proxmox systemd[1]: Starting Import ZFS pool vmfs...

Nov 23 23:07:47 proxmox systemd-fsck[649]: /dev/sdc1: clean, 18071/244195328 files, 599009636/976754176 blocks

Nov 23 23:07:47 proxmox systemd-fsck[651]: tv: clean, 76/244195328 files, 66346688/976754176 blocks

Nov 23 23:07:47 proxmox systemd-fsck[652]: hdd-int: clean, 1344430/244191232 files, 1012724008/1953506304 blocks

Nov 23 23:07:47 proxmox lvm[650]: 10 logical volume(s) in volume group "pve" now active

Nov 23 23:07:47 proxmox systemd[1]: Started File System Check on /dev/disk/by-uuid/3dee70c0-6fb0-4a7b-a743-8cd9cc3d23fa.

Nov 23 23:07:47 proxmox systemd[1]: mnt-tv.mount: Directory /mnt/tv to mount over is not empty, mounting anyway.

Nov 23 23:07:47 proxmox systemd[1]: Mounting /mnt/tv...

Nov 23 23:07:47 proxmox systemd[1]: Started File System Check on /dev/disk/by-uuid/44bd59c9-03ef-4d4f-ba52-a9144666e6dd.

Nov 23 23:07:47 proxmox systemd[1]: Mounting /mnt/daten...

Nov 23 23:07:47 proxmox systemd[1]: Started LVM event activation on device 8:3.

Nov 23 23:07:47 proxmox zpool[663]: cannot import 'vmfs': no such pool available

Nov 23 23:07:47 proxmox systemd[1]: Started File System Check on /dev/disk/by-uuid/5258a109-ecd6-4a59-89c4-08b4adb59e69.

Nov 23 23:07:47 proxmox systemd[1]: Mounting /mnt/multimedia...

Nov 23 23:07:47 proxmox systemd[1]: zfs-import@vmfs.service: Main process exited, code=exited, status=1/FAILURE

Nov 23 23:07:47 proxmox systemd[1]: zfs-import@vmfs.service: Failed with result 'exit-code'.

Nov 23 23:07:47 proxmox systemd[1]: Failed to start Import ZFS pool vmfs.

Nov 23 23:07:47 proxmox systemd[1]: Mounted /mnt/multimedia.

Nov 23 23:07:47 proxmox kernel: EXT4-fs (sdc1): mounted filesystem with ordered data mode. Opts: (null)

Nov 23 23:07:47 proxmox systemd[1]: Mounted /mnt/tv.

Nov 23 23:07:47 proxmox kernel: EXT4-fs (sdd1): mounted filesystem with ordered data mode. Opts: (null)

Nov 23 23:07:47 proxmox kernel: EXT4-fs (sdb1): mounted filesystem with ordered data mode. Opts: (null)

Nov 23 23:07:47 proxmox systemd[1]: Mounted /mnt/daten.

Nov 23 23:07:47 proxmox kernel: zd0: p1 p2 p3

Nov 23 23:07:47 proxmox kernel: zd32: p1 p2

Nov 23 23:07:47 proxmox kernel: zd48: p1 p2 p3 p4

Nov 23 23:07:47 proxmox kernel: zd64: p1 p2 < p5 >

Nov 23 23:07:47 proxmox kernel: zd80: p1 p2

Nov 23 23:07:47 proxmox kernel: zd96: p1 p2 < p5 >

Nov 23 23:07:47 proxmox kernel: zd112: p1 p2 p3

Nov 23 23:07:47 proxmox systemd[1]: Started Import ZFS pools by cache file.

Nov 23 23:07:47 proxmox systemd[1]: Reached target ZFS pool import target.

Nov 23 23:07:47 proxmox systemd[1]: Starting Mount ZFS filesystems...

Nov 23 23:07:47 proxmox systemd[1]: Starting Wait for ZFS Volume (zvol) links in /dev...

Nov 23 23:07:47 proxmox systemd[1]: Started Mount ZFS filesystems.

Nov 23 23:07:47 proxmox systemd[1]: Reached target Local File Systems.

Nov 23 23:07:47 proxmox systemd[1]: Condition check resulted in Commit a transient machine-id on disk being skipped.

Nov 23 23:07:47 proxmox systemd[1]: Starting Set console font and keymap...

Nov 23 23:07:47 proxmox systemd[1]: Starting Load AppArmor profiles...

Nov 23 23:07:47 proxmox systemd[1]: Starting Create Volatile Files and Directories...

Nov 23 23:07:47 proxmox systemd[1]: Starting Proxmox VE firewall logger...

Nov 23 23:07:47 proxmox systemd[1]: Starting Proxmox VE Login Banner...

Nov 23 23:07:47 proxmox systemd[1]: Starting Commit Proxmox VE network changes...

Nov 23 23:07:48 proxmox systemd-udevd[485]: link_config: autonegotiation is unset or enabled, the speed and duplex are not writable.

Nov 23 23:07:48 proxmox systemd-udevd[485]: Could not generate persistent MAC address for bond1: No such file or directory

Nov 23 23:07:48 proxmox smartd[1591]: Device: /dev/sdd [SAT], is SMART capable. Adding to "monitor" list.

Nov 23 23:07:48 proxmox smartd[1591]: Device: /dev/sdd [SAT], state read from /var/lib/smartmontools/smartd.WDC_WD40EFRX_68N32N0-WD_WCC7K3KAYSJ2.ata.state

Nov 23 23:07:48 proxmox smartd[1591]: Device: /dev/nvme0, opened

Nov 23 23:07:48 proxmox smartd[1591]: Device: /dev/nvme0, Samsung SSD 970 EVO 1TB, S/N:S5H9NS0NA85234E, FW:2B2QEXE7, 1.00 TB

Nov 23 23:07:48 proxmox smartd[1591]: Device: /dev/nvme0, is SMART capable. Adding to "monitor" list.

Nov 23 23:07:48 proxmox smartd[1591]: Device: /dev/nvme0, state read from /var/lib/smartmontools/smartd.Samsung_SSD_970_EVO_1TB-S5H9NS0NA85234E.nvme.state

Nov 23 23:07:48 proxmox smartd[1591]: Monitoring 4 ATA/SATA, 0 SCSI/SAS and 1 NVMe devices

Nov 23 23:07:48 proxmox kernel: bond1: (slave enp1s0f0): Enslaving as a backup interface with a down link

Nov 23 23:07:48 proxmox kernel: bond1: (slave enp1s0f1): Enslaving as a backup interface with a down link

Nov 23 23:07:48 proxmox kernel: bond1: (slave enp1s0f2): Enslaving as a backup interface with a down link

Nov 23 23:07:48 proxmox zed[1683]: eid=2 class=config_sync pool='vmfs'

Nov 23 23:07:48 proxmox kernel: bond1: (slave enp1s0f3): Enslaving as a backup interface with a down link

Nov 23 23:07:48 proxmox systemd-udevd[485]: link_config: autonegotiation is unset or enabled, the speed and duplex are not writable.

Nov 23 23:07:48 proxmox systemd-udevd[485]: Could not generate persistent MAC address for vmbr0: No such file or directory

Nov 23 23:07:48 proxmox kernel: vmbr0: port 1(bond1) entered blocking state

Nov 23 23:07:48 proxmox kernel: vmbr0: port 1(bond1) entered disabled state

Nov 23 23:07:48 proxmox kernel: device bond1 entered promiscuous mode

Nov 23 23:07:48 proxmox kernel: device enp1s0f0 entered promiscuous mode

Nov 23 23:07:48 proxmox kernel: device enp1s0f1 entered promiscuous mode

Nov 23 23:07:48 proxmox kernel: device enp1s0f2 entered promiscuous mode

Nov 23 23:07:48 proxmox kernel: device enp1s0f3 entered promiscuous mode

Nov 23 23:07:48 proxmox avahi-daemon[1582]: Joining mDNS multicast group on interface vmbr0.IPv4 with address 192.168.1.20.

Nov 23 23:07:48 proxmox avahi-daemon[1582]: New relevant interface vmbr0.IPv4 for mDNS.

Nov 23 23:07:48 proxmox avahi-daemon[1582]: Registering new address record for 192.168.1.20 on vmbr0.IPv4.

Nov 23 23:07:48 proxmox systemd-udevd[485]: link_config: autonegotiation is unset or enabled, the speed and duplex are not writable.

Nov 23 23:07:48 proxmox systemd-udevd[485]: Could not generate persistent MAC address for vmbr1: No such file or directory

Nov 23 23:07:48 proxmox kernel: vmbr1: port 1(enp0s31f6) entered blocking state

Nov 23 23:07:48 proxmox kernel: vmbr1: port 1(enp0s31f6) entered disabled state

Nov 23 23:07:48 proxmox kernel: device enp0s31f6 entered promiscuous mode

Nov 23 23:07:48 proxmox zed[1714]: eid=3 class=pool_import pool='vmfs'

Nov 23 23:07:48 proxmox systemd[1]: Started Login Service.

Nov 23 23:07:48 proxmox systemd-udevd[485]: Could not generate persistent MAC address for bond1: No such file or directory

Nov 23 23:07:48 proxmox smartd[1591]: Device: /dev/sdd [SAT], is SMART capable. Adding to "monitor" list.

Nov 23 23:07:48 proxmox smartd[1591]: Device: /dev/sdd [SAT], state read from /var/lib/smartmontools/smartd.WDC_WD40EFRX_68N32N0-WD_WCC7K3KAYSJ2.ata.state

Nov 23 23:07:48 proxmox smartd[1591]: Device: /dev/nvme0, opened

Nov 23 23:07:48 proxmox smartd[1591]: Device: /dev/nvme0, Samsung SSD 970 EVO 1TB, S/N:S5H9NS0NA85234E, FW:2B2QEXE7, 1.00 TB

Nov 23 23:07:48 proxmox smartd[1591]: Device: /dev/nvme0, is SMART capable. Adding to "monitor" list.

Nov 23 23:07:48 proxmox smartd[1591]: Device: /dev/nvme0, state read from /var/lib/smartmontools/smartd.Samsung_SSD_970_EVO_1TB-S5H9NS0NA85234E.nvme.state

Nov 23 23:07:48 proxmox smartd[1591]: Monitoring 4 ATA/SATA, 0 SCSI/SAS and 1 NVMe devices

Nov 23 23:07:48 proxmox kernel: bond1: (slave enp1s0f0): Enslaving as a backup interface with a down link

Nov 23 23:07:48 proxmox kernel: bond1: (slave enp1s0f1): Enslaving as a backup interface with a down link

Nov 23 23:07:48 proxmox kernel: bond1: (slave enp1s0f2): Enslaving as a backup interface with a down link

Nov 23 23:07:48 proxmox zed[1683]: eid=2 class=config_sync pool='vmfs'

Nov 23 23:07:48 proxmox kernel: bond1: (slave enp1s0f3): Enslaving as a backup interface with a down link

Nov 23 23:07:48 proxmox systemd-udevd[485]: link_config: autonegotiation is unset or enabled, the speed and duplex are not writable.

Nov 23 23:07:48 proxmox systemd-udevd[485]: Could not generate persistent MAC address for vmbr0: No such file or directory

Nov 23 23:07:48 proxmox kernel: vmbr0: port 1(bond1) entered blocking state

Nov 23 23:07:48 proxmox kernel: vmbr0: port 1(bond1) entered disabled state

Nov 23 23:07:48 proxmox kernel: device bond1 entered promiscuous mode

Nov 23 23:07:48 proxmox kernel: device enp1s0f0 entered promiscuous mode

Nov 23 23:07:48 proxmox kernel: device enp1s0f1 entered promiscuous mode

Nov 23 23:07:48 proxmox kernel: device enp1s0f2 entered promiscuous mode

Nov 23 23:07:48 proxmox kernel: device enp1s0f3 entered promiscuous mode

Nov 23 23:07:48 proxmox avahi-daemon[1582]: Joining mDNS multicast group on interface vmbr0.IPv4 with address 192.168.1.20.

Nov 23 23:07:48 proxmox avahi-daemon[1582]: New relevant interface vmbr0.IPv4 for mDNS.

Nov 23 23:07:48 proxmox avahi-daemon[1582]: Registering new address record for 192.168.1.20 on vmbr0.IPv4.

Nov 23 23:07:48 proxmox systemd-udevd[485]: link_config: autonegotiation is unset or enabled, the speed and duplex are not writable.

Nov 23 23:07:48 proxmox systemd-udevd[485]: Could not generate persistent MAC address for vmbr1: No such file or directory

Nov 23 23:07:48 proxmox kernel: vmbr1: port 1(enp0s31f6) entered blocking state

Nov 23 23:07:48 proxmox kernel: vmbr1: port 1(enp0s31f6) entered disabled state

Nov 23 23:07:48 proxmox kernel: device enp0s31f6 entered promiscuous mode

Nov 23 23:07:48 proxmox zed[1714]: eid=3 class=pool_import pool='vmfs'

Nov 23 23:07:48 proxmox systemd[1]: Started Login Service.

Nov 23 23:08:01 proxmox pveproxy[2148]: /etc/pve/local/pve-ssl.key: failed to load local private key (key_file or key) at /usr/share/perl5/PVE/APIServer/AnyEvent.pm line 1891.

Nov 23 23:08:01 proxmox cron[1945]: (*system*vzdump) CAN'T OPEN SYMLINK (/etc/cron.d/vzdump)

Nov 23 23:08:06 proxmox pveproxy[2080]: starting 1 worker(s)

Nov 23 23:08:06 proxmox pveproxy[2080]: worker 2151 started

Nov 23 23:08:06 proxmox pveproxy[2147]: worker exit

Nov 23 23:08:06 proxmox pveproxy[2148]: worker exit

Nov 23 23:08:06 proxmox pveproxy[2151]: /etc/pve/local/pve-ssl.key: failed to load local private key (key_file or key) at /usr/share/perl5/PVE/APIServer/AnyEvent.pm line

Nov 23 23:08:01 proxmox cron[1945]: (*system*vzdump) CAN'T OPEN SYMLINK (/etc/cron.d/vzdump)

Nov 23 23:08:06 proxmox pveproxy[2080]: starting 1 worker(s)

Nov 23 23:08:06 proxmox pveproxy[2080]: worker 2151 started

Nov 23 23:08:06 proxmox pveproxy[2147]: worker exit

Nov 23 23:08:06 proxmox pveproxy[2148]: worker exit

Nov 23 23:08:06 proxmox pveproxy[2151]: /etc/pve/local/pve-ssl.key: failed to load local private key (key_file or key) at /usr/share/perl5/PVE/APIServer/AnyEvent.pm line

Solltet Ihr noch weitere Infos benötigen reiche ich sie heute Abend nach!

Gruß und danke

Frank