ich fass das geschehene auf Wunsch nochmal kurz zusammen:

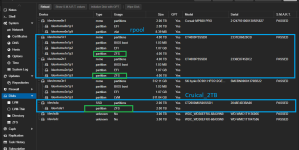

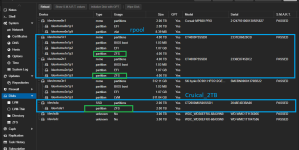

* ursprungssystem mit zwei zfs-pools gecrashed

* neu installiert

* pool mit namen "local-zfs" wieder hergestellt

* VM Config zurückgespielt

* vms in dem pool laufen

-------------------------

* zweiten pool auch eingebunden (bin mir aber beim Namen nicht mehr sicher gewesen)

* der zweite Pool ist nur eine disk (Cruical mit 2TB)

--> da ich beim Einbinden einen Fehler gemacht haben dürfte, und diese dist auch im pool "zfs-local" gelandet ist, sind die vm-disks so komisch sichtbar gewesen.

--> ich hab den pool-namen in storage.cfg geändert und dann ist das Problem 1

Verständnisfrage: keine neue Disk auf ZFS anlegen / Korrekt gemounted? gelöst gewesen.

-------------------------

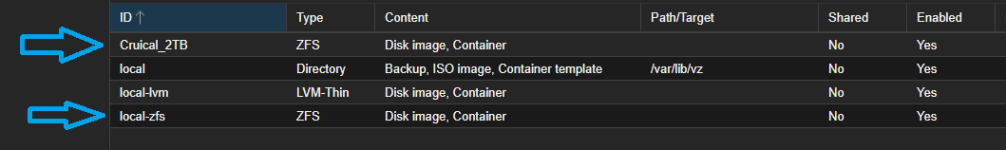

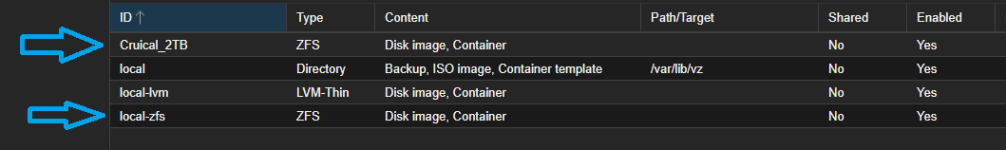

meine jetzige storage.cfg

dir: local

path /var/lib/vz

content iso,vztmpl,backup

lvmthin: local-lvm

thinpool data

vgname pve

content images,rootdir

zfspool: local-zfs

pool rpool/data

content rootdir,images

sparse 1

zfspool: Cruical_2TB

pool Cruical_2TB

content images,rootdir

mountpoint /Cruical_2TB

sparse 0

-------------------------

zpool status

pool: Cruical_2TB

state: ONLINE

scan: scrub repaired 0B in 00:25:13 with 0 errors on Sun Jun 8 00:49:14 2025

config:

NAME STATE READ WRITE CKSUM

Cruical_2TB ONLINE 0 0 0

wwn-0x500a0751e4d3ba00-part1 ONLINE 0 0 0

errors: No known data errors

pool: rpool

state: ONLINE

scan: scrub repaired 0B in 02:15:38 with 0 errors on Sun Jun 8 02:39:40 2025

config:

NAME STATE READ WRITE CKSUM

rpool ONLINE 0 0 0

mirror-0 ONLINE 0 0 0

nvme-CT4000P3SSD8_2336E8745DC2-part3 ONLINE 0 0 0

nvme-CT4000P3SSD8_2331E86828CB-part3 ONLINE 0 0 0

errors: No known data errors

-------------------------

zpool list -v

NAME SIZE ALLOC FREE CKPOINT EXPANDSZ FRAG CAP DEDUP HEALTH ALTROOT

Cruical_2TB 1.81T 751G 1.08T - - 0% 40% 1.00x ONLINE -

wwn-0x500a0751e4d3ba00-part1 1.82T 751G 1.08T - - 0% 40.5% - ONLINE

rpool 3.62T 1.76T 1.87T - - 37% 48% 1.00x ONLINE -

mirror-0 3.62T 1.76T 1.87T - - 37% 48.5% - ONLINE

nvme-CT4000P3SSD8_2336E8745DC2-part3 3.64T - - - - - - - ONLINE

nvme-CT4000P3SSD8_2331E86828CB-part3 3.64T - - - - - - - ONLINE

-------------------------

Bitte mal den Namen des ZFS Pools Cricial.. anpassen

Sorry, sitze auf der LEitung - was meinst du damit?

bzw: Wo hab ich ihn falsch geschrieben?

-------------------------

-------------------------

pvesm status

Name Type Status Total Used Available %

Cruical_2TB zfspool active 1885863936 1765771248 120092688 93.63%

local dir active 1869713024 28611584 1841101440 1.53%

local-lvm lvmthin active 365760512 0 365760512 0.00%

local-zfs zfspool active 3733374020 1892272476 1841101544 50.69%

gruss & Dank vorab

Ferengie

PS: ich hoffe, ich konnte es verständlich erklären ...