Hallo zusammen,

habe 2 Server im Cluster beide mit ZFS:

4 x SATA im RAID10

2 x SSD ZFS Log

64GB RAM (ca. 25GB durch VMs belegt)

Proxmox ist auf einer extra Platte installiert und aktuell (5.1)

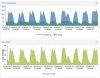

Beim z.B.: starten einer VM oder wenn auf den Servern gearbeitet wird (Terminalserver, wenn Programme gestartet werden) geht der IO delay ziemlich nach oben (manchmal 70%) und Load average geht auch in den 2 stelligen Bereich. Das geht dann auch recht schnell wieder runter.

Die VMs(Windows Server) laufen recht schnell und ohne Probleme.

Sind diese Ausschläge normal bei ZFS?

Vielen Dank.

Gruß

Tobias

habe 2 Server im Cluster beide mit ZFS:

4 x SATA im RAID10

2 x SSD ZFS Log

64GB RAM (ca. 25GB durch VMs belegt)

Proxmox ist auf einer extra Platte installiert und aktuell (5.1)

Beim z.B.: starten einer VM oder wenn auf den Servern gearbeitet wird (Terminalserver, wenn Programme gestartet werden) geht der IO delay ziemlich nach oben (manchmal 70%) und Load average geht auch in den 2 stelligen Bereich. Das geht dann auch recht schnell wieder runter.

Die VMs(Windows Server) laufen recht schnell und ohne Probleme.

Sind diese Ausschläge normal bei ZFS?

Vielen Dank.

Gruß

Tobias