Hallo zusammen,

Ich lese immer man solle doch lieber gebrauchte Enterprise SSDs verwenden.

Habt ihr ein paar Empfehlungen für gebrauchte 2TB M.2 NVMe SSD? Es reicht mir eine PCIe Gen3.

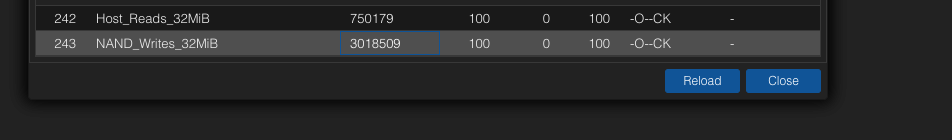

Könnt ihr z.b. die Intel P3600 Add In Karten empfehlen? (ca. 15% verbraucht)

Ich würde sie gerne im ZFS Mirror Betrieb für diverse VMs verwenden.

Vielen Dank im voraus.

Ich lese immer man solle doch lieber gebrauchte Enterprise SSDs verwenden.

Habt ihr ein paar Empfehlungen für gebrauchte 2TB M.2 NVMe SSD? Es reicht mir eine PCIe Gen3.

Könnt ihr z.b. die Intel P3600 Add In Karten empfehlen? (ca. 15% verbraucht)

Ich würde sie gerne im ZFS Mirror Betrieb für diverse VMs verwenden.

Vielen Dank im voraus.