Hallo, ich schaffe es nicht mein Storage Performant hinzubekommen.

Host ist ein HPE DL 380 Gen9 mit 2x E5-2690v4 und 16x32GB RDIMMs

Proxmox VE ist auf ein Hardware Raid 1 mit SATA SSDs installiert (default optionen vom installer)

Als Storage nutzte ich anfänglich mit 8xSata SSD (mit Raidcontroller und jeder Disk als Raid0), zwischendurch 16xSata SSD (mit LSI HBA) und nun endlich das NVMe 6x U.2 SFF 2,5" Bay Enablement Kit 774741-B21 in welchem 4 Stk 3,84TB Micron 7300 Pro NVMe SSDs stecken. Leider fühlen sich VMs darauf immer noch nicht "snappy" an und die Bedienung via RDP ist ein Geduldsspiel...

Auf dem Hardware Raid hab ich laut https://pve.proxmox.com/wiki/Windows_2022_guest_best_practices eine windows vm installiert und eine NVMe Disk in unterschiedlichen Szenarien eingebunden und mit 4k NTFS formatiert:

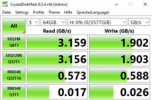

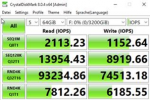

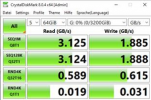

passthrough:

root@ipve1:~# qm set 100 -scsi3 /dev/disk/by-id/nvme-Micron_7300_XXgekürztXX

update VM 100: -scsi3 /dev/disk/by-id/nvme-Micron_7300_XXgekürztXX

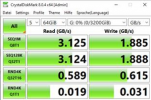

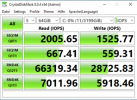

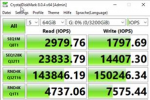

lvm:

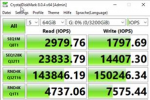

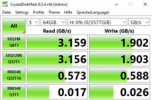

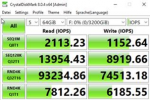

zfs mit ashift=12 und volblocksize 4k:

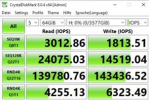

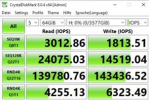

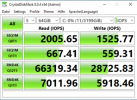

Zum Vergleich habe ich auch mal windows bare metal statt proxmox installiert und dort folgende Ergebnisse erhalten

interessant hierbei ist, dass es kaum einen Unterschied macht ob 512 oder 4096 mit nvme-cli formatiert wird (habe unten auf den Screenshots die formatierung vermerkt)

Am Ende möchte ich für meine VMs (Windows IIS und SQL) die schnellste Lösung mit Redundanz - ich denke ZFS Raid10 wäre passend?

Nur leider ist das dann noch langsamer:

Habt Ihr bitte einen Rat für mich wo insbesondere die RND4K Performance verloren geht und wa sich dagegen tun kann?

lg tekknus

Host ist ein HPE DL 380 Gen9 mit 2x E5-2690v4 und 16x32GB RDIMMs

Proxmox VE ist auf ein Hardware Raid 1 mit SATA SSDs installiert (default optionen vom installer)

Als Storage nutzte ich anfänglich mit 8xSata SSD (mit Raidcontroller und jeder Disk als Raid0), zwischendurch 16xSata SSD (mit LSI HBA) und nun endlich das NVMe 6x U.2 SFF 2,5" Bay Enablement Kit 774741-B21 in welchem 4 Stk 3,84TB Micron 7300 Pro NVMe SSDs stecken. Leider fühlen sich VMs darauf immer noch nicht "snappy" an und die Bedienung via RDP ist ein Geduldsspiel...

Auf dem Hardware Raid hab ich laut https://pve.proxmox.com/wiki/Windows_2022_guest_best_practices eine windows vm installiert und eine NVMe Disk in unterschiedlichen Szenarien eingebunden und mit 4k NTFS formatiert:

passthrough:

root@ipve1:~# qm set 100 -scsi3 /dev/disk/by-id/nvme-Micron_7300_XXgekürztXX

update VM 100: -scsi3 /dev/disk/by-id/nvme-Micron_7300_XXgekürztXX

lvm:

zfs mit ashift=12 und volblocksize 4k:

Zum Vergleich habe ich auch mal windows bare metal statt proxmox installiert und dort folgende Ergebnisse erhalten

interessant hierbei ist, dass es kaum einen Unterschied macht ob 512 oder 4096 mit nvme-cli formatiert wird (habe unten auf den Screenshots die formatierung vermerkt)

Am Ende möchte ich für meine VMs (Windows IIS und SQL) die schnellste Lösung mit Redundanz - ich denke ZFS Raid10 wäre passend?

Nur leider ist das dann noch langsamer:

Habt Ihr bitte einen Rat für mich wo insbesondere die RND4K Performance verloren geht und wa sich dagegen tun kann?

lg tekknus