Hallo liebe Experten,

schon lange trage ich mich mit dem Gedanken, meinen privaten Windows 10 Pro Homeserver mit HyperV und 2 VMs in Richtung Proxmox umzustellen. Dazu habe ich viel mitgelesen und bin nun an dem Punkt, dass ich nicht mehr weiterkomme im sinnvollen Aufbau auf Basis der bestehenden Komponenten und (angedachten) Nutzung, ich hoffe, ich bin hier richtig.

Verfügbare Hardware:

Ich hoffe, meine Ausführungen zeigen grundsätzlich in die richtige Richtung, für Eure Hilfe schon jetzt vielen Dank,

Thorsten

schon lange trage ich mich mit dem Gedanken, meinen privaten Windows 10 Pro Homeserver mit HyperV und 2 VMs in Richtung Proxmox umzustellen. Dazu habe ich viel mitgelesen und bin nun an dem Punkt, dass ich nicht mehr weiterkomme im sinnvollen Aufbau auf Basis der bestehenden Komponenten und (angedachten) Nutzung, ich hoffe, ich bin hier richtig.

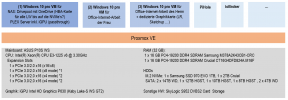

Verfügbare Hardware:

- Mainboard: ASUS P10S WS

- Expansion Slots

- 1 x PCIe 3.0/2.0 x16 (x16/x8)

- 1 x PCIe 3.0/2.0 x16 (x8 mode) *1

- 1 x PCIe 3.0/2.0 x16 (x4 mode) *2

- 1 x PCIe 3.0/2.0 x16 (x4 mode) *2

- Storage

- 8 x SATA 6Gb/s port(s),

- 2 x M.2 Socket 3*3, with M Key, type 2242/2260/2280/22110 storage devices support (both SATA & PCIE mode)

- Support Raid 0, 1, 5, 10

- Intel® Rapid Storage Technology Enterprise supports

- CPU: Intel(R) Xeon(R) CPU E3-1225 v6 @ 3.30GHz

- RAM (32 GB):

- 1 x 16 GB PC4-19200 DDR4 SDRAM Samsung M378A2K43CB1-CRC

- 1 x 16 GB PC4-19200 DDR4 SDRAM Crucial Technology CT16G4DFD824A.M16F

- HDDs

- Samsung SSD 970 EVO 1TB

- 12 TB | HGST HUH721212ALE604

- 10 TB|HGST HDN721010ALE604

- 8 TB|HGST HDN728080ALE604

- 4 TB|WDC WD40EFRX-68WT0N0

- 4 TB|WDC WD40EFRX-68WT0N0

- Sonstige HW

- SkyLogic S952 DVBS2 Card

- Host-System: Windows 10 Pro mit aktiviertem HpyerV

- Host-System-Nutzung:

- Plex Server

- Virtuelle Maschine für leistungsintensive Anwendungen wie Lightroom, Photoshop, aber auch MySQL Datenbanken

- Storage:

- die Platten 2-6 sind mittels Stablebit DrivePool zu einem Pool zusammengefügt, aktuell zu ca. 80% genutzt und selektiv sind einige Verzeichnisse dupliziert

- Die NVmE Platte ist aktuell für das OS und auch für den LR-Katalog und die VMs genutzt, Sicherung hier mittels robocopy

- VMs

- Virtueller Win 10 Pro PC für meine Frau

- PiHole

- ioBroker

- Betrieb folgender VMs

- Windows 10 Pro PC der Frau (Office-Anwendungen, Internet Surfen)

- Windows 10 Pro PC für mich (Graphikanwendungen)

- PiHole

- ioBroker

- Plex

- ggf. noch Openmediavault / Nextcloud, pfSense

- Konfiguration:

- Proxmox und VMs auf der 1 TB NVMe, da mein Board Raid 1, 5, 10 anbietet, würde ich noch eine identische Samsung 1 TB NVMe dazukaufen

- Openmediavault als Ersatz für den bisherigen Pool für die Platten 2-6

- Macht die Nutzung der NVMe(s) für Proxmox und die VMs Sinn?

- Wenn ja, auch im RAID 1 Betrieb?

- Wie baue ich am besten den Medienpool auf (Filme, Serien, Bilder, Musik), vor allem vor dem Hintergrund, dass ich nicht genug Kapazität für ein Zwischenparken habe?

- Ist Drivepool eine gute Lösung?

- Wenn ja, eigene VM dafür nutzen oder ggf. auf der PLEX VM oder einer der anderen VMs?

- Wenn nein, was wäre die optimale Lösung, so etwas wie Openmediavault oder hat Proxmox Bordmittel?

Ich hoffe, meine Ausführungen zeigen grundsätzlich in die richtige Richtung, für Eure Hilfe schon jetzt vielen Dank,

Thorsten