Liebe Community,

leider sind auch wir bekannter weise von der Kündigungswelle unter VMware betroffen. Es ist schon erschreckend was dort aktuell abgeht, aber das ist ein anderes Thema.

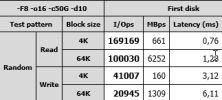

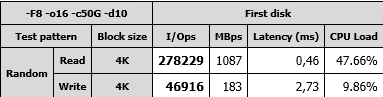

Ursprünglich wollten wir unsere Hosting Farm bestehend aus 6x nagelneue DELL R760 Servern (HCI) sowie 12x DELL R740 Servern (Computing) auf Basis von vSphere 8 aufbauen. Als Storage Virtualisierungsprodukt sollte StarWind VSAN zum Einsatz kommen. Wir haben sehr viel Erfahrung mit beiden Produkten und konnten in Vergangenen Projekten mühelos 300.000 IOPS (4k) und einen Streaming Speed von 8 GB/s (lesend) innerhalb von VM's erzielen.

Da aber das Zeitalter VMware aufgrund verschiedener Dinge für uns zu kippen droht, sind wir bei der Suche nach Alternativen auf Proxmox gestoßen. Proxmox ist uns nicht ganz unbekannt, da schon kleinere Projekte umgesetzt wurden.

Wir überlegen nun, ein reines Proxmox Datacenter mit Ceph aufzubauen. Da die 6x R760 Server noch nicht in Betrieb sind, können wir das gefahrlos machen. Müssen aber dann im Nachgang ca. 95 TB an VM von VMware zu Proxmox migrieren . Danach die Computing nodes.

Die Server haben folgende Specs:

DELL R760

2x Intel Xeon Gold 3,6 GHz

1TB Memory DDR5

1x DELL Boss Card mit 2x m.2 SATA SSD (raid-1)

14x 3,84 TB SAS SSD

1x Perc H755 RAID Controller

4x Mellanox Connectx-6 25 Gbit Dual Port cards

Gibt es hier Community Member die in ähnlicher Größe bereits Proxmox mit ceph betreiben ? Könnt ihr ein paar Empfehlungen hinsichtlich der Einstellungen geben ?

Die Umgebung soll an mehrere Redundante Cisco Nexus Leaf Switche angebunden werden. Alles mit 25 GBit/s.

leider sind auch wir bekannter weise von der Kündigungswelle unter VMware betroffen. Es ist schon erschreckend was dort aktuell abgeht, aber das ist ein anderes Thema.

Ursprünglich wollten wir unsere Hosting Farm bestehend aus 6x nagelneue DELL R760 Servern (HCI) sowie 12x DELL R740 Servern (Computing) auf Basis von vSphere 8 aufbauen. Als Storage Virtualisierungsprodukt sollte StarWind VSAN zum Einsatz kommen. Wir haben sehr viel Erfahrung mit beiden Produkten und konnten in Vergangenen Projekten mühelos 300.000 IOPS (4k) und einen Streaming Speed von 8 GB/s (lesend) innerhalb von VM's erzielen.

Da aber das Zeitalter VMware aufgrund verschiedener Dinge für uns zu kippen droht, sind wir bei der Suche nach Alternativen auf Proxmox gestoßen. Proxmox ist uns nicht ganz unbekannt, da schon kleinere Projekte umgesetzt wurden.

Wir überlegen nun, ein reines Proxmox Datacenter mit Ceph aufzubauen. Da die 6x R760 Server noch nicht in Betrieb sind, können wir das gefahrlos machen. Müssen aber dann im Nachgang ca. 95 TB an VM von VMware zu Proxmox migrieren . Danach die Computing nodes.

Die Server haben folgende Specs:

DELL R760

2x Intel Xeon Gold 3,6 GHz

1TB Memory DDR5

1x DELL Boss Card mit 2x m.2 SATA SSD (raid-1)

14x 3,84 TB SAS SSD

1x Perc H755 RAID Controller

4x Mellanox Connectx-6 25 Gbit Dual Port cards

Gibt es hier Community Member die in ähnlicher Größe bereits Proxmox mit ceph betreiben ? Könnt ihr ein paar Empfehlungen hinsichtlich der Einstellungen geben ?

Die Umgebung soll an mehrere Redundante Cisco Nexus Leaf Switche angebunden werden. Alles mit 25 GBit/s.