Hallo zusammen

Die Situation ist die dass ich den alten Server mit einem neuen ersetzt habe. Der PBS blieb bestehen. Ich weiss aber nicht ob das überhaupt etwas damit zu tun hat.

alter Server: Proxmox 7.xx

1 LXC auf Datastore mit ZFS (ca. 3TB)

täglich gesichert auf separatem PBS

neuer Server: Proxmox 8.2.7

Datastore mit Raid 1 ZFS (ca. 4TB)

den LXC Container aus dem PBS zurückgespielt (problemlos)

Sicherungsjob auf PBS erstellt.

Nachdem der Server ein paar Tage problemlos gelaufen ist, wollte ich versuchen das letzte Backup einzuspielen. Leider zeigt sich bei mir der folgende Fehler:

ecovering backed-up configuration from 'EXT-PBS-Backup-Alpha-SJ2V-SVAD:backup/ct/105/2024-11-10T04:30:01Z'

restoring 'EXT-PBS-Backup-Alpha-SJ2V-SVAD:backup/ct/105/2024-11-10T04:30:01Z' now..

Error: error extracting archive - encountered unexpected error during extraction: error at entry "66aca3ef64b7cd61e": failed to extract file: failed to copy file contents: No space left on device (os error 28)

TASK ERROR: unable to restore CT 188 - command 'lxc-usernsexec -m u:0:100000:65536 -m g:0:100000:65536 -- /usr/bin/proxmox-backup-client restore '--crypt-mode=none' ct/105/2024-11-10T04:30:01Z root.pxar /var/lib/lxc/188/rootfs --allow-existing-dirs --repository root@pam@192.168.2.78:EXT-PBS-Backup-Alpha-SJ2V-SVAD' failed: exit code 255

Nun, Space hat es genug auf dem neuen Server. Darum hat mich die Fehlermeldung "No space left on device (os error 28)" auch verwirrt.

Ach ja, der PBS zeigt eine Grösse von etwa 9.7GB des zurückzuspielenden LXC's an. Die Platte des LXC's auf dem PVE ist jedoch ca. 62GB gross.

Aus diesem Thread hier weiss ich, dass es irgendetwas mit dem ZFS und Komprimierung zu tun haben muss. Check das aber nicht warum und wieso.

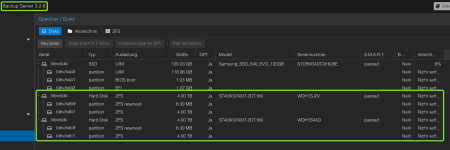

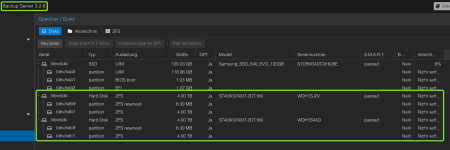

Hier mal die Plattenkonfiguration des PBS:

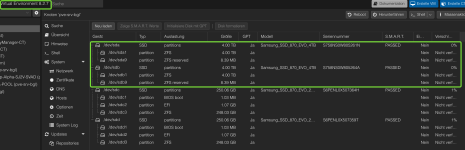

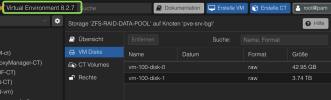

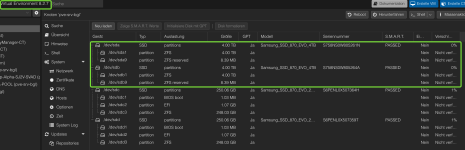

und hier von der Auszug vom PVE:

ist doch beides mal ZFS im RAID 1... müsste doch funktionieren.

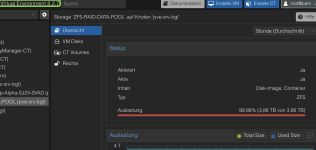

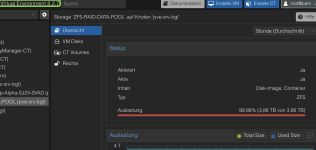

Interessant ist, das der PVE unter den Disks über 3.7 TB anzeigt:

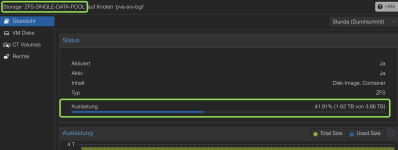

unter ZFS jedoch nur1.63

Unter der Übersicht überläuft der Pool schon fast ;-) das zeigte bereits der alte Server schon seit 2 Jahren an.

Wie kann das alles sein? Habe ich bei der Erstelllung des DataPools einen Fehler gemacht? Wie komme ich da wieder raus?

Ich hoffe es kann mir Jemand einen Input geben. Vielen herzlichen Dank schon mal.

Grüsse Gregor

PS: ich hätte die Möglichkeit, 2 andere 3 oder 4TB SSD's in den Server zu schieben und etwas daraus zu machen. Falls das zur Lösung beitragen könnte.

Die Situation ist die dass ich den alten Server mit einem neuen ersetzt habe. Der PBS blieb bestehen. Ich weiss aber nicht ob das überhaupt etwas damit zu tun hat.

alter Server: Proxmox 7.xx

1 LXC auf Datastore mit ZFS (ca. 3TB)

täglich gesichert auf separatem PBS

neuer Server: Proxmox 8.2.7

Datastore mit Raid 1 ZFS (ca. 4TB)

den LXC Container aus dem PBS zurückgespielt (problemlos)

Sicherungsjob auf PBS erstellt.

Nachdem der Server ein paar Tage problemlos gelaufen ist, wollte ich versuchen das letzte Backup einzuspielen. Leider zeigt sich bei mir der folgende Fehler:

ecovering backed-up configuration from 'EXT-PBS-Backup-Alpha-SJ2V-SVAD:backup/ct/105/2024-11-10T04:30:01Z'

restoring 'EXT-PBS-Backup-Alpha-SJ2V-SVAD:backup/ct/105/2024-11-10T04:30:01Z' now..

Error: error extracting archive - encountered unexpected error during extraction: error at entry "66aca3ef64b7cd61e": failed to extract file: failed to copy file contents: No space left on device (os error 28)

TASK ERROR: unable to restore CT 188 - command 'lxc-usernsexec -m u:0:100000:65536 -m g:0:100000:65536 -- /usr/bin/proxmox-backup-client restore '--crypt-mode=none' ct/105/2024-11-10T04:30:01Z root.pxar /var/lib/lxc/188/rootfs --allow-existing-dirs --repository root@pam@192.168.2.78:EXT-PBS-Backup-Alpha-SJ2V-SVAD' failed: exit code 255

Nun, Space hat es genug auf dem neuen Server. Darum hat mich die Fehlermeldung "No space left on device (os error 28)" auch verwirrt.

Ach ja, der PBS zeigt eine Grösse von etwa 9.7GB des zurückzuspielenden LXC's an. Die Platte des LXC's auf dem PVE ist jedoch ca. 62GB gross.

Aus diesem Thread hier weiss ich, dass es irgendetwas mit dem ZFS und Komprimierung zu tun haben muss. Check das aber nicht warum und wieso.

Hier mal die Plattenkonfiguration des PBS:

und hier von der Auszug vom PVE:

ist doch beides mal ZFS im RAID 1... müsste doch funktionieren.

Interessant ist, das der PVE unter den Disks über 3.7 TB anzeigt:

unter ZFS jedoch nur1.63

Unter der Übersicht überläuft der Pool schon fast ;-) das zeigte bereits der alte Server schon seit 2 Jahren an.

Wie kann das alles sein? Habe ich bei der Erstelllung des DataPools einen Fehler gemacht? Wie komme ich da wieder raus?

Ich hoffe es kann mir Jemand einen Input geben. Vielen herzlichen Dank schon mal.

Grüsse Gregor

PS: ich hätte die Möglichkeit, 2 andere 3 oder 4TB SSD's in den Server zu schieben und etwas daraus zu machen. Falls das zur Lösung beitragen könnte.