Ist es überhaupt sinnvoll/ratsam eine Firewall virtuell unter Proxmox zu betreiben und wenn ja gibt es Konfiguationsbeispiele?

Was ist mit der Proxmox eigenen Firewall, wie soll die konfiguriert werden wenn eine vm als Firewall laufen soll?

Hallo fpausp

Ob der Einsatz einer virtuellen Firewall ratsam oder sinnvoll ist, hängt von Deinen Anforderungen an. Allerdings musst Du einiges bei Deiner Wahl berücksichtigen:

Performance

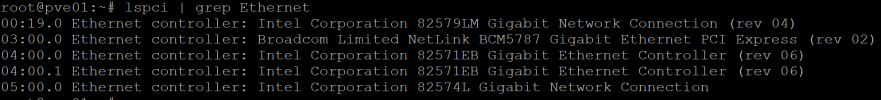

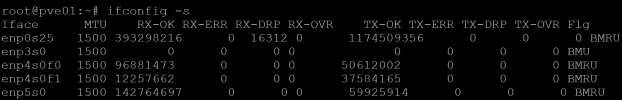

HW-Firewalls sind in der Regel performanter, da ihnen die Systemressourcen (CPU, RAM, Netzwerkinterfaces usw.) exklusiv zur Verfügung stehen. VMs müssen sich diese Ressourcen mit dem Host und anderen VMs teilen. D. h., Du musst mehr Ressourcen für Deine Virtualisierungsumgebung als für eine HW-Firewall einplanen.

Backups/Snapshots

Ein wichtiger Vorteil von VMs gegenüber HW-Firewalls ist die Möglichkeit, Snapshots zu erstellen. Wenn ein Upgrade in die Hose geht, bedeutet das Rollbackverfahren bei einer HW-Firewall in vielen Fällen nichts anders als plattmachen, neu installieren und Config-Backup einspielen. Dies kann unter Umständen recht zeitintensiv werden und Deine Systeme sind während dieser Zeit vom Internet getrennt. Bei VMs ist das ganze um einiges einfacher. Das Verfahren wäre in diesem Fall: Snapshot der VM erstellen und upgraden. Ist der Upgrade erfolgreich, dann kannst Du den Snapshot löschen. Geht der Upgrade in die Hose, dann kannst Du den Snapshot zurückladen und gut ist es. Der vorteil dabei ist, dass dies relativ schnell geht.

Redundanz

Kritische Systeme, darunter auch Firewalls, haben die Eigenschaft, dass sie immer verfügbar sein sollten. Wie Dunuin bereits erwähnt hat, kann ein Hardwaredefekt (egal ob es sich um eine HW-Firewall oder den Virtualisierungshost handelt) dazu führen, dass Du plötzlich offline bist. Und dann ist eine entsprechende Ersatzhardware nicht gerade verfügbar, was die Offline-Zeit weiter verlängert. Ein weiteres Szenario, der Dir eine Offline-Zeit bescheren kann, ist, wenn Du Updates auf den Proxmox-Node installierst und dieser neu gestartet werden muss. Daher solltest Du dich Gedanken darüber machen, wie diese kritische Systeme redundant aufgebaut werden sollten.

Generell kann man einen Cluster bilden, egal ob es sich um eine HW- oder VM-Firewall handelt. Dabei ist zu berücksichtigen, dass die Hardware der Cluster-Mitglieder möglichst identisch sein sollte, um unerwünschte "Side Effects" zu vermeiden. Bei Proxmox ist diese Anforderung an die Hardware nicht so wichtig, da die VM-Hardware virtualisiert wird. Allerdings sollten die Proxmox-Hosts etwa gleichwertig sein, d. h, ähnliche CPUs, RAM usw. haben.

In einer Virtualisierungsumgebung hat man mehrere Möglichkeiten, die Redundanz aufzubauen. Eine Variante wäre zwei Standalone Proxmox Hosts zu installieren und die HA-Funktionen der VM für die Clusterbildung zu benutzen. Auf diese Weise gibt es keine Unterbrüche bei einem Hardwareausfall.

Eine weitere Variante wäre einen Proxmox-Cluster zu bilden. Dies hätte den Vorteil, dass Du Snapshots der VMs im zweiten Proxmox-Node erstellen kannst und die VMs bei Wartungen an den Proxmox-Servern hin und her verschieben kannst, und dies ebenfalls ohne grosse Unterbrüche (Live-Migration).

Die "ultimative" Variante wäre jedoch ein Proxmox-HA-Cluster. Hier werden die VMs bei einem Ausfall automatisch von einem Node zum anderen migriert. Allerdings ist der Aufbau des Clusters in diesem Fall aufwendiger, da mehr Komponenten ins Spiel kommen (mind. drei nodes oder zwei nodes + Q-Device und Shared Storage).

Gruss