Hallo

ich habe folgendes Phänomen.

Ich habe 2 Proxmox Server, einen neueren ("pve0") der ca. 2 Wochen alt ist, und einen älteren ("pve1") der ca. 5 Jahre alt ist. Ich habe sie in einem Cluster, damit ich über eine einzelne Web GUI beide Server betrachten kann. Soweit so gut. HA und Replication etc habe ich im Moment nicht in Benutzung.

Der ältere Server hat nur 1GBit on-board Netzwerk, da habe ich letzte Woche eine 25 GBit HPE Netzwerkkarte eingebaut.

Der neuere Server hat bereits ab Werk die 25 GBit Karte drin, eine Broadcom.

Jetzt habe ich folgendes Phänomen beobachtet, was mich sehr beunruhigt, und wo ich nicht erkennen kann, was der Grund ist:

wenn ich den pve0 neu boote, über die Command Line "reboot now" oder übers Web GUI, dann crasht der pve1 mehr oder weniger instantan, während der andere neu bootet. Und ich kann mir absolut nicht erklären, wieso das so ist.

Jetzt ist es natürlich so, dass ich 2 Änderungen gemacht habe, einerseits die 25 GBit Netzwerkkarte eingebaut, und andererseits die Beiden zu einem Cluster zusammengefügt.

Ich kann den Effekt reproduzieren, es scheint wirklich ein harter reset zu sein, deshalb steht auch in den Logs nicht viel nützliches. Aber ich kann über IPMI beobachten, wie der eine Server crasht. Man kann z.B. eine Shell offen haben, den pve0 rebooten, und dann kommt auf pve1 ZACK plötzlich das BIOS Logo und man sieht wie er neu bootet. Das ist sehr unschön. Und ich kann mir nicht erklären, woran es liegen kann, zumal in den Logs ja nicht viel nützliches steht.

Wie kann ich das Problem eruieren? kann es sein, dass das System ein Problem mit der 25 GBit Karte hat? wie finde ich das heraus?

Hier ein Auszug aus dem Syslog, bevor und nach dem Reset. Um 9:02:41 habe ich den Node pve0 neu gebootet. Um 9:03:09 fand der Crash statt; die "@" habe nicht ich in den Syslog eingefügt, die stehen da wirklich so drin. Im dmesg steht nichts nützliches, das wird ja beim Booten leider überschrieben.

In der Beilage habe ich mal noch die Outputs von LSHW und Syslog angehängt. Kann jemand etwas damit anfangen?

Der pve1 ist bis jetzt durchgehend sehr zuverlässig gelaufen.

Wir hatten einmal einen defekten Power Distributor, der wurde ersetzt, sonst gab es nie Probleme. Und jetzt diese Crashs....... Hardwareproblem? warum?

Edit: grade nochmal im IPMI geschaut.

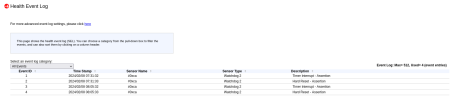

Da sehe ich unter "Health Event Log" folgende Einträge: (siehe Bild im Anhang)

da wird ein Hardware Reset asserted. Warum?

ich habe folgendes Phänomen.

Ich habe 2 Proxmox Server, einen neueren ("pve0") der ca. 2 Wochen alt ist, und einen älteren ("pve1") der ca. 5 Jahre alt ist. Ich habe sie in einem Cluster, damit ich über eine einzelne Web GUI beide Server betrachten kann. Soweit so gut. HA und Replication etc habe ich im Moment nicht in Benutzung.

Der ältere Server hat nur 1GBit on-board Netzwerk, da habe ich letzte Woche eine 25 GBit HPE Netzwerkkarte eingebaut.

Der neuere Server hat bereits ab Werk die 25 GBit Karte drin, eine Broadcom.

Jetzt habe ich folgendes Phänomen beobachtet, was mich sehr beunruhigt, und wo ich nicht erkennen kann, was der Grund ist:

wenn ich den pve0 neu boote, über die Command Line "reboot now" oder übers Web GUI, dann crasht der pve1 mehr oder weniger instantan, während der andere neu bootet. Und ich kann mir absolut nicht erklären, wieso das so ist.

Jetzt ist es natürlich so, dass ich 2 Änderungen gemacht habe, einerseits die 25 GBit Netzwerkkarte eingebaut, und andererseits die Beiden zu einem Cluster zusammengefügt.

Ich kann den Effekt reproduzieren, es scheint wirklich ein harter reset zu sein, deshalb steht auch in den Logs nicht viel nützliches. Aber ich kann über IPMI beobachten, wie der eine Server crasht. Man kann z.B. eine Shell offen haben, den pve0 rebooten, und dann kommt auf pve1 ZACK plötzlich das BIOS Logo und man sieht wie er neu bootet. Das ist sehr unschön. Und ich kann mir nicht erklären, woran es liegen kann, zumal in den Logs ja nicht viel nützliches steht.

Wie kann ich das Problem eruieren? kann es sein, dass das System ein Problem mit der 25 GBit Karte hat? wie finde ich das heraus?

Hier ein Auszug aus dem Syslog, bevor und nach dem Reset. Um 9:02:41 habe ich den Node pve0 neu gebootet. Um 9:03:09 fand der Crash statt; die "@" habe nicht ich in den Syslog eingefügt, die stehen da wirklich so drin. Im dmesg steht nichts nützliches, das wird ja beim Booten leider überschrieben.

Code:

2024-02-08T09:01:01.401372+01:00 pve1 CRON[34547]: (root) CMD ( /usr/bin/ipmiutil wdt -r >/dev/null 2>&1)

2024-02-08T09:02:01.451098+01:00 pve1 CRON[35195]: (root) CMD ( /usr/bin/ipmiutil wdt -r >/dev/null 2>&1)

2024-02-08T09:02:23.941966+01:00 pve1 pmxcfs[8202]: [status] notice: received log

2024-02-08T09:02:23.947547+01:00 pve1 pmxcfs[8202]: [status] notice: received log

2024-02-08T09:02:30.955166+01:00 pve1 pmxcfs[8202]: [status] notice: received log

2024-02-08T09:02:41.962498+01:00 pve1 corosync[8303]: [CFG ] Node 2 was shut down by sysadmin

2024-02-08T09:02:41.963970+01:00 pve1 pmxcfs[8202]: [dcdb] notice: members: 1/8202

2024-02-08T09:02:41.964052+01:00 pve1 pmxcfs[8202]: [status] notice: members: 1/8202

2024-02-08T09:02:41.964816+01:00 pve1 corosync[8303]: [QUORUM] Sync members[1]: 1

2024-02-08T09:02:41.964868+01:00 pve1 corosync[8303]: [QUORUM] Sync left[1]: 2

2024-02-08T09:02:41.964925+01:00 pve1 corosync[8303]: [TOTEM ] A new membership (1.332e) was formed. Members left: 2

2024-02-08T09:02:41.965200+01:00 pve1 corosync[8303]: [QUORUM] This node is within the non-primary component and will NOT provide any services.

2024-02-08T09:02:41.965244+01:00 pve1 corosync[8303]: [QUORUM] Members[1]: 1

2024-02-08T09:02:41.965276+01:00 pve1 corosync[8303]: [MAIN ] Completed service synchronization, ready to provide service.

2024-02-08T09:02:41.965310+01:00 pve1 pmxcfs[8202]: [status] notice: node lost quorum

2024-02-08T09:02:42.827363+01:00 pve1 corosync[8303]: [KNET ] link: host: 2 link: 0 is down

2024-02-08T09:02:42.827463+01:00 pve1 corosync[8303]: [KNET ] host: host: 2 (passive) best link: 0 (pri: 1)

2024-02-08T09:02:42.827499+01:00 pve1 corosync[8303]: [KNET ] host: host: 2 has no active links

2024-02-08T09:02:49.132017+01:00 pve1 pve-ha-lrm[8371]: lost lock 'ha_agent_pve1_lock - cfs lock update failed - Permission denied

2024-02-08T09:02:54.133965+01:00 pve1 pve-ha-lrm[8371]: status change active => lost_agent_lock

2024-02-08T09:03:01.498754+01:00 pve1 CRON[35841]: (root) CMD ( /usr/bin/ipmiutil wdt -r >/dev/null 2>&1)

2024-02-08T09:03:09.054676+01:00 pve1 pvescheduler[35774]: jobs: cfs-lock 'file-jobs_cfg' error: no quorum!

2024-02-08T09:03:09.057231+01:00 pve1 pvescheduler[35772]: replication: cfs-lock 'file-replication_cfg' error: no quorum!

^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^@^2024-02-08T09:07:32.741178+01:00 pve1 systemd-modules-load[2021]: Inserted module 'vhost_net'

2024-02-08T09:07:32.741243+01:00 pve1 kernel: [ 0.000000] Linux version 6.5.11-8-pve (build@proxmox) (gcc (Debian 12.2.0-14) 12.2.0, GNU ld (GNU Binutils for >

2024-02-08T09:07:32.741261+01:00 pve1 kernel: [ 0.000000] Command line: BOOT_IMAGE=/boot/vmlinuz-6.5.11-8-pve root=UUID=a5834fe4-61bb-479f-9648-9c7b501ed27a r>

2024-02-08T09:07:32.741262+01:00 pve1 kernel: [ 0.000000] KERNEL supported cpus:In der Beilage habe ich mal noch die Outputs von LSHW und Syslog angehängt. Kann jemand etwas damit anfangen?

Der pve1 ist bis jetzt durchgehend sehr zuverlässig gelaufen.

Wir hatten einmal einen defekten Power Distributor, der wurde ersetzt, sonst gab es nie Probleme. Und jetzt diese Crashs....... Hardwareproblem? warum?

Edit: grade nochmal im IPMI geschaut.

Da sehe ich unter "Health Event Log" folgende Einträge: (siehe Bild im Anhang)

da wird ein Hardware Reset asserted. Warum?

Attachments

Last edited: