Hallo,

wir migrieren mehrere VM's heute von Host01 weg zu unseren neuen Host02, nun haben wir das Problem das paar VM's sich nicht migrieren lassen wollen, allerdings konnten wir paar erledigen nur 10 VM's bekommen alle den unten genannten selben Fehler.

Es kommt folgende Fehler beim migrieren:

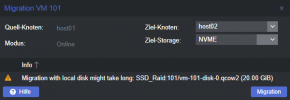

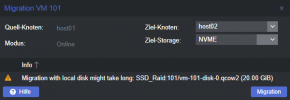

Bei der Migration der VM 101 gebe ich ebenfalls den neuen Storage NVME an siehe Bild

Hätte jemand eventuelle Lösungsvorschläge?

qmconfig 101:

pveversion Host01:

pveversion Host02:

wir migrieren mehrere VM's heute von Host01 weg zu unseren neuen Host02, nun haben wir das Problem das paar VM's sich nicht migrieren lassen wollen, allerdings konnten wir paar erledigen nur 10 VM's bekommen alle den unten genannten selben Fehler.

Es kommt folgende Fehler beim migrieren:

Code:

2022-04-30 21:30:59 use dedicated network address for sending migration traffic (10.0.0.2)

2022-04-30 21:31:00 starting migration of VM 101 to node 'host02' (10.0.0.2)

2022-04-30 21:31:00 found generated disk 'SSD_Raid:101/vm-101-cloudinit.qcow2' (in current VM config)

2022-04-30 21:31:00 found local disk 'SSD_Raid:101/vm-101-disk-0.qcow2' (in current VM config)

2022-04-30 21:31:00 copying local disk images

2022-04-30 21:31:02 Formatting '/media/nvme/images/101/vm-101-cloudinit.qcow2', fmt=qcow2 cluster_size=65536 extended_l2=off preallocation=metadata compression_type=zlib size=4194304 lazy_refcounts=off refcount_bits=16

2022-04-30 21:31:02 1104+0 records in

2022-04-30 21:31:02 1104+0 records out

2022-04-30 21:31:02 4521984 bytes (4.5 MB, 4.3 MiB) copied, 0.290656 s, 15.6 MB/s

2022-04-30 21:31:02 42+107 records in

2022-04-30 21:31:02 42+107 records out

2022-04-30 21:31:02 4521984 bytes (4.5 MB, 4.3 MiB) copied, 0.0456777 s, 99.0 MB/s

2022-04-30 21:31:02 successfully imported 'NVME:101/vm-101-cloudinit.qcow2'

2022-04-30 21:31:02 volume 'SSD_Raid:101/vm-101-cloudinit.qcow2' is 'NVME:101/vm-101-cloudinit.qcow2' on the target

2022-04-30 21:31:02 starting VM 101 on remote node 'host02'

2022-04-30 21:31:03 [host02] storage 'SSD_Raid' is not available on node 'host02'

2022-04-30 21:31:03 ERROR: online migrate failure - remote command failed with exit code 255

2022-04-30 21:31:03 aborting phase 2 - cleanup resources

2022-04-30 21:31:03 migrate_cancel

2022-04-30 21:31:06 ERROR: migration finished with problems (duration 00:00:07)

TASK ERROR: migration problemsBei der Migration der VM 101 gebe ich ebenfalls den neuen Storage NVME an siehe Bild

Hätte jemand eventuelle Lösungsvorschläge?

qmconfig 101:

Code:

agent: 1

boot: order=scsi0;ide0

cores: 2

ide0: SSD_Raid:101/vm-101-cloudinit.qcow2,media=cdrom,size=4M

ide2: none,media=cdrom

memory: 2048

meta: creation-qemu=6.1.1,ctime=1644083623

name: r01

net0: virtio=A6:B5:81:7D:10:3F,bridge=vmbr0,firewall=1

net1: virtio=5E:59:0F:4F:49:D9,bridge=vmbr100

numa: 0

onboot: 1

ostype: l26

scsi0: SSD_Raid:101/vm-101-disk-0.qcow2,size=20G,ssd=1

scsihw: virtio-scsi-pci

smbios1: uuid=6dd36dfd-77d6-4330-a376-f3056ffb349f

sockets: 1

startup: order=1

vmgenid: 06e2784b-1016-4bed-b849-949e4c3f7016pveversion Host01:

Code:

proxmox-ve: 7.1-2 (running kernel: 5.11.22-7-pve)

pve-manager: 7.1-12 (running version: 7.1-12/b3c09de3)

pve-kernel-helper: 7.2-2

pve-kernel-5.13: 7.1-9

pve-kernel-5.11: 7.0-10

pve-kernel-5.13.19-6-pve: 5.13.19-15

pve-kernel-5.13.19-5-pve: 5.13.19-13

pve-kernel-5.13.19-2-pve: 5.13.19-4

pve-kernel-5.11.22-7-pve: 5.11.22-12

ceph: 16.2.7

ceph-fuse: 16.2.7

corosync: 3.1.5-pve2

criu: 3.15-1+pve-1

glusterfs-client: 9.2-1

ifupdown2: 3.1.0-1+pmx3

ksm-control-daemon: 1.4-1

libjs-extjs: 7.0.0-1

libknet1: 1.22-pve2

libproxmox-acme-perl: 1.4.2

libproxmox-backup-qemu0: 1.2.0-1

libpve-access-control: 7.1-7

libpve-apiclient-perl: 3.2-1

libpve-common-perl: 7.1-5

libpve-guest-common-perl: 4.1-2

libpve-http-server-perl: 4.1-1

libpve-network-perl: 0.7.0

libpve-storage-perl: 7.1-2

libspice-server1: 0.14.3-2.1

lvm2: 2.03.11-2.1

lxc-pve: 4.0.12-1

lxcfs: 4.0.12-pve1

novnc-pve: 1.3.0-3

proxmox-backup-client: 2.1.6-1

proxmox-backup-file-restore: 2.1.6-1

proxmox-mini-journalreader: 1.3-1

proxmox-widget-toolkit: 3.4-10

pve-cluster: 7.1-3

pve-container: 4.1-5

pve-docs: 7.1-2

pve-edk2-firmware: 3.20210831-2

pve-firewall: 4.2-5

pve-firmware: 3.4-1

pve-ha-manager: 3.3-4

pve-i18n: 2.6-3

pve-qemu-kvm: 6.2.0-5

pve-xtermjs: 4.16.0-1

qemu-server: 7.1-5

smartmontools: 7.2-pve3

spiceterm: 3.2-2

swtpm: 0.7.1~bpo11+1

vncterm: 1.7-1

zfsutils-linux: 2.1.4-pve1pveversion Host02:

Code:

proxmox-ve: 7.1-2 (running kernel: 5.13.19-6-pve)

pve-manager: 7.1-12 (running version: 7.1-12/b3c09de3)

pve-kernel-helper: 7.2-2

pve-kernel-5.13: 7.1-9

pve-kernel-5.11: 7.0-10

pve-kernel-5.13.19-6-pve: 5.13.19-15

pve-kernel-5.13.19-4-pve: 5.13.19-9

pve-kernel-5.13.19-2-pve: 5.13.19-4

pve-kernel-5.11.22-7-pve: 5.11.22-12

ceph: 16.2.7

ceph-fuse: 16.2.7

corosync: 3.1.5-pve2

criu: 3.15-1+pve-1

glusterfs-client: 9.2-1

ifupdown: not correctly installed

ifupdown2: 3.1.0-1+pmx3

ksm-control-daemon: 1.4-1

libjs-extjs: 7.0.0-1

libknet1: 1.22-pve2

libproxmox-acme-perl: 1.4.2

libproxmox-backup-qemu0: 1.2.0-1

libpve-access-control: 7.1-7

libpve-apiclient-perl: 3.2-1

libpve-common-perl: 7.1-5

libpve-guest-common-perl: 4.1-2

libpve-http-server-perl: 4.1-1

libpve-network-perl: 0.7.0

libpve-storage-perl: 7.1-2

libqb0: 1.0.5-1

libspice-server1: 0.14.3-2.1

lvm2: 2.03.11-2.1

lxc-pve: 4.0.12-1

lxcfs: 4.0.12-pve1

novnc-pve: 1.3.0-3

proxmox-backup-client: 2.1.6-1

proxmox-backup-file-restore: 2.1.6-1

proxmox-mini-journalreader: 1.3-1

proxmox-widget-toolkit: 3.4-10

pve-cluster: 7.1-3

pve-container: 4.1-5

pve-docs: 7.1-2

pve-edk2-firmware: 3.20210831-2

pve-firewall: 4.2-5

pve-firmware: 3.4-1

pve-ha-manager: 3.3-4

pve-i18n: 2.6-3

pve-qemu-kvm: 6.2.0-5

pve-xtermjs: 4.16.0-1

qemu-server: 7.1-5

smartmontools: 7.2-pve3

spiceterm: 3.2-2

swtpm: 0.7.1~bpo11+1

vncterm: 1.7-1

zfsutils-linux: 2.1.4-pve1

Last edited: