Hallo,

ich experimentiere mit dem PBS (und bin im Test-Zweig auf 4.0.21, also ein Experimentiergerät). Versuchsweise habe ich den PBS neu aufgesetzt und den vorhandenen Datastore (Wasabi S3) neu eingebunden. Unter "Content" im Datastore werden mir die alten Backups auch angezeigt.

Allerdings funktionieren neue Backups nicht mehr, immer mit solchen Fehlern, und gleich am Anfang des Jobs (eine VM mit 20GB-HD):

ERROR: VM 115 qmp command 'backup' failed - backup connect failed: command error: mkstemp "/run/proxmox-backup/active-operations/Wasabi-Datastore.tmp_XXXXXX" failed: ENOSPC: No space left on device

Liegt das eher an der aktuellen Testversion, oder habe ich etwas falsch gemacht im Zusammenspiel? Ich habe den Backup-Job im PVE schon neu angelegt, jedoch ist die Anzeige im Storage auf dem PVE recht hakelig, ich muss immer mal den PBS neu starten, habe ich das gefühl.

Kein Speicher? Auf dem S3 oder auf dem PVE oder auf dem PBS?

PBS:

df -h

Filesystem Size Used Avail Use% Mounted on

udev 1.9G 0 1.9G 0% /dev

tmpfs 390M 928K 389M 1% /run

/dev/mapper/pbs-root 39G 9.5G 28G 26% /

tmpfs 2.0G 0 2.0G 0% /dev/shm

efivarfs 256K 92K 160K 37% /sys/firmware/efi/efivars

tmpfs 5.0M 0 5.0M 0% /run/lock

tmpfs 1.0M 0 1.0M 0% /run/credentials/systemd-journald.service

tmpfs 2.0G 0 2.0G 0% /tmp

/dev/sda2 511M 8.8M 503M 2% /boot/efi

tmpfs 1.0M 0 1.0M 0% /run/credentials/getty@tty1.service

tmpfs 390M 4.0K 390M 1% /run/user/0

Ich weiß gerade nicht, aus welcher Ecke der Fehler kommt... der PBS ist genauso dimensioniert wie vorher, und da liefen die Backups durch.

PBS

cat datastore.cfg

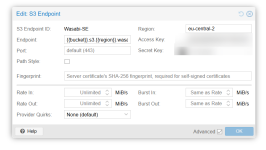

datastore: Wasabi-Datastore

backend bucket=proxmox-backup-server,client=Wasabi-SE,type=s3

comment

gc-schedule 15:30

notification-mode notification-system

path /var/lib/proxmox-backup/local-cache/mein-wasabi/

PVE

cat storage.cfg

pbs: Ollis_PBS

datastore Wasabi-Datastore

server 192.168.10.50

content backup

fingerprint b3:...

prune-backups keep-all=1

username root@pam

Viele Grüße

Oliver

ich experimentiere mit dem PBS (und bin im Test-Zweig auf 4.0.21, also ein Experimentiergerät). Versuchsweise habe ich den PBS neu aufgesetzt und den vorhandenen Datastore (Wasabi S3) neu eingebunden. Unter "Content" im Datastore werden mir die alten Backups auch angezeigt.

Allerdings funktionieren neue Backups nicht mehr, immer mit solchen Fehlern, und gleich am Anfang des Jobs (eine VM mit 20GB-HD):

ERROR: VM 115 qmp command 'backup' failed - backup connect failed: command error: mkstemp "/run/proxmox-backup/active-operations/Wasabi-Datastore.tmp_XXXXXX" failed: ENOSPC: No space left on device

Liegt das eher an der aktuellen Testversion, oder habe ich etwas falsch gemacht im Zusammenspiel? Ich habe den Backup-Job im PVE schon neu angelegt, jedoch ist die Anzeige im Storage auf dem PVE recht hakelig, ich muss immer mal den PBS neu starten, habe ich das gefühl.

Kein Speicher? Auf dem S3 oder auf dem PVE oder auf dem PBS?

PBS:

df -h

Filesystem Size Used Avail Use% Mounted on

udev 1.9G 0 1.9G 0% /dev

tmpfs 390M 928K 389M 1% /run

/dev/mapper/pbs-root 39G 9.5G 28G 26% /

tmpfs 2.0G 0 2.0G 0% /dev/shm

efivarfs 256K 92K 160K 37% /sys/firmware/efi/efivars

tmpfs 5.0M 0 5.0M 0% /run/lock

tmpfs 1.0M 0 1.0M 0% /run/credentials/systemd-journald.service

tmpfs 2.0G 0 2.0G 0% /tmp

/dev/sda2 511M 8.8M 503M 2% /boot/efi

tmpfs 1.0M 0 1.0M 0% /run/credentials/getty@tty1.service

tmpfs 390M 4.0K 390M 1% /run/user/0

Ich weiß gerade nicht, aus welcher Ecke der Fehler kommt... der PBS ist genauso dimensioniert wie vorher, und da liefen die Backups durch.

PBS

cat datastore.cfg

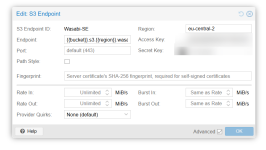

datastore: Wasabi-Datastore

backend bucket=proxmox-backup-server,client=Wasabi-SE,type=s3

comment

gc-schedule 15:30

notification-mode notification-system

path /var/lib/proxmox-backup/local-cache/mein-wasabi/

PVE

cat storage.cfg

pbs: Ollis_PBS

datastore Wasabi-Datastore

server 192.168.10.50

content backup

fingerprint b3:...

prune-backups keep-all=1

username root@pam

Viele Grüße

Oliver