Hallo,

ich habe bei Hetzner 2 Root Server.

Server PVE Host (Falkenstein): 2x3,84 TB NVMe SSD Datacenter Edition, konfiguriert als ZFS Pool

Server PBS Host (Helsinki): 2x6 TB Enterprise HDD, konfiguriert als ZFS Pool

Fio Tests:

fio --rw=readwrite --name=test --size=100M --direct=1 --bs=1024k

ZFS / NVME SSD

READ: bw=5750MiB/s (6029MB/s), 5750MiB/s-5750MiB/s (6029MB/s-6029MB/s), io=46.0MiB (48.2MB), run=8-8msec

WRITE: bw=6750MiB/s (7078MB/s), 6750MiB/s-6750MiB/s (7078MB/s-7078MB/s), io=54.0MiB (56.6MB), run=8-8msec

PBS / SATA HDD

READ: bw=4600MiB/s (4823MB/s), 4600MiB/s-4600MiB/s (4823MB/s-4823MB/s), io=46.0MiB (48.2MB), run=10-10msec

WRITE: bw=5400MiB/s (5662MB/s), 5400MiB/s-5400MiB/s (5662MB/s-5662MB/s), io=54.0MiB (56.6MB), run=10-10msec

Ich habe am PVE nun eine größere VM mit ca. 1 TB die ich regelmäßig auf den PBS sichere. Die erste initale Sicherung dieser VM hat ca. 2h 39m gedauert, was für mich absolut akzeptabel ist.

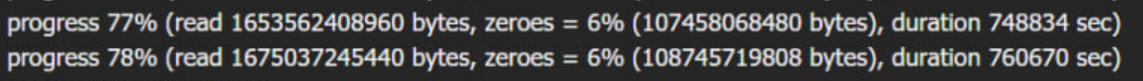

Nun habe ich aber gestern den Restore vom PBS auf den PVE zurück ausprobiert. Schaut dann in etwa wie folgt aus:

new volume ID is 'local-zfs:vm-100-disk-0'

download and verify backup index

progress 1% (read 10737418240 bytes, zeroes = 1% (130023424 bytes), duration 363 sec)

progress 2% (read 21474836480 bytes, zeroes = 1% (276824064 bytes), duration 780 sec)

Wenn ich den Fortschritt hochrechne (habe es dann abgebrochen) komme ich auf eine Restore Zeit von über 11 Stunden. Das ist natürlich im Bedarfsfall vollkommen unakzeptabel. Auch das Risiko, daß während dieser langen Zeit irgendein Abbruch stattfinden kann, ist natürlich sehr hoch.

Mich würde daher interessieren was die Profis hier in der Community dazu sagen. Mache ich da was falsch? Habe ich da irgendwo was falsch konfiguriert.

Bin für jeden Tipp dankbar.

ich habe bei Hetzner 2 Root Server.

Server PVE Host (Falkenstein): 2x3,84 TB NVMe SSD Datacenter Edition, konfiguriert als ZFS Pool

Server PBS Host (Helsinki): 2x6 TB Enterprise HDD, konfiguriert als ZFS Pool

Fio Tests:

fio --rw=readwrite --name=test --size=100M --direct=1 --bs=1024k

ZFS / NVME SSD

READ: bw=5750MiB/s (6029MB/s), 5750MiB/s-5750MiB/s (6029MB/s-6029MB/s), io=46.0MiB (48.2MB), run=8-8msec

WRITE: bw=6750MiB/s (7078MB/s), 6750MiB/s-6750MiB/s (7078MB/s-7078MB/s), io=54.0MiB (56.6MB), run=8-8msec

PBS / SATA HDD

READ: bw=4600MiB/s (4823MB/s), 4600MiB/s-4600MiB/s (4823MB/s-4823MB/s), io=46.0MiB (48.2MB), run=10-10msec

WRITE: bw=5400MiB/s (5662MB/s), 5400MiB/s-5400MiB/s (5662MB/s-5662MB/s), io=54.0MiB (56.6MB), run=10-10msec

Ich habe am PVE nun eine größere VM mit ca. 1 TB die ich regelmäßig auf den PBS sichere. Die erste initale Sicherung dieser VM hat ca. 2h 39m gedauert, was für mich absolut akzeptabel ist.

Nun habe ich aber gestern den Restore vom PBS auf den PVE zurück ausprobiert. Schaut dann in etwa wie folgt aus:

new volume ID is 'local-zfs:vm-100-disk-0'

download and verify backup index

progress 1% (read 10737418240 bytes, zeroes = 1% (130023424 bytes), duration 363 sec)

progress 2% (read 21474836480 bytes, zeroes = 1% (276824064 bytes), duration 780 sec)

Wenn ich den Fortschritt hochrechne (habe es dann abgebrochen) komme ich auf eine Restore Zeit von über 11 Stunden. Das ist natürlich im Bedarfsfall vollkommen unakzeptabel. Auch das Risiko, daß während dieser langen Zeit irgendein Abbruch stattfinden kann, ist natürlich sehr hoch.

Mich würde daher interessieren was die Profis hier in der Community dazu sagen. Mache ich da was falsch? Habe ich da irgendwo was falsch konfiguriert.

Bin für jeden Tipp dankbar.