Hallo zusammen,

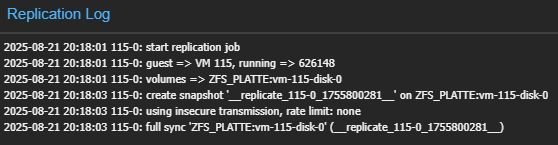

bei der Replizierung einer VM gibt es den Fehler "end replication job with error: zfs error: cannot create snapshot 'ZFS_PLATTE/vm-115-disk-0@__replicate_115-0_1755715980__': out of space". Das Zielstorage hat mehr als genügend Speicherplatz frei. Und beide Storages haben den identischen Namen.

zfs get all zeigt, dass keine reservation aktiv ist.

Übersehe ich etwas?

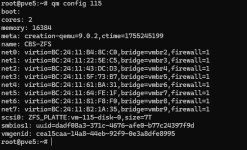

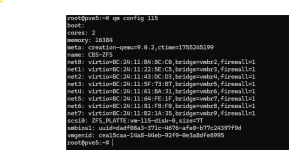

PVE Version auf dem Zielhost:

PVE Version auf Quellhost

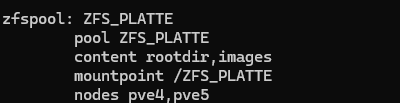

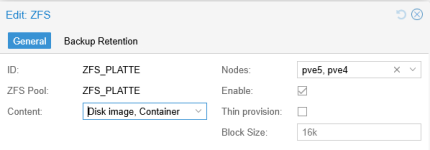

ZFS List auf dem Zielhost:

ZFS List auf dem Quellhost:

bei der Replizierung einer VM gibt es den Fehler "end replication job with error: zfs error: cannot create snapshot 'ZFS_PLATTE/vm-115-disk-0@__replicate_115-0_1755715980__': out of space". Das Zielstorage hat mehr als genügend Speicherplatz frei. Und beide Storages haben den identischen Namen.

zfs get all zeigt, dass keine reservation aktiv ist.

Übersehe ich etwas?

Code:

()

2025-08-20 20:53:00 115-0: start replication job

2025-08-20 20:53:00 115-0: guest => VM 115, running => 626148

2025-08-20 20:53:00 115-0: volumes => ZFS_PLATTE:vm-115-disk-0

2025-08-20 20:53:02 115-0: create snapshot '__replicate_115-0_1755715980__' on ZFS_PLATTE:vm-115-disk-0

2025-08-20 20:53:02 115-0: end replication job with error: zfs error: cannot create snapshot 'ZFS_PLATTE/vm-115-disk-0@__replicate_115-0_1755715980__': out of spacePVE Version auf dem Zielhost:

Code:

proxmox-ve: 8.4.0 (running kernel: 6.8.12-11-pve)

pve-manager: 8.4.1 (running version: 8.4.1/2a5fa54a8503f96d)

proxmox-kernel-helper: 8.1.1

proxmox-kernel-6.8.12-11-pve-signed: 6.8.12-11

proxmox-kernel-6.8: 6.8.12-11

proxmox-kernel-6.8.12-9-pve-signed: 6.8.12-9

proxmox-kernel-6.8.12-4-pve-signed: 6.8.12-4

ceph-fuse: 17.2.7-pve3

corosync: 3.1.9-pve1

criu: 3.17.1-2+deb12u1

glusterfs-client: 10.3-5

ifupdown2: 3.2.0-1+pmx11

ksm-control-daemon: 1.5-1

libjs-extjs: 7.0.0-5

libknet1: 1.30-pve2

libproxmox-acme-perl: 1.6.0

libproxmox-backup-qemu0: 1.5.1

libproxmox-rs-perl: 0.3.5

libpve-access-control: 8.2.2

libpve-apiclient-perl: 3.3.2

libpve-cluster-api-perl: 8.1.1

libpve-cluster-perl: 8.1.1

libpve-common-perl: 8.3.1

libpve-guest-common-perl: 5.2.2

libpve-http-server-perl: 5.2.2

libpve-network-perl: 0.11.2

libpve-rs-perl: 0.9.4

libpve-storage-perl: 8.3.6

libspice-server1: 0.15.1-1

lvm2: 2.03.16-2

lxc-pve: 6.0.0-1

lxcfs: 6.0.0-pve2

novnc-pve: 1.6.0-2

proxmox-backup-client: 3.4.2-1

proxmox-backup-file-restore: 3.4.2-1

proxmox-firewall: 0.7.1

proxmox-kernel-helper: 8.1.1

proxmox-mail-forward: 0.3.3

proxmox-mini-journalreader: 1.5

proxmox-offline-mirror-helper: 0.6.7

proxmox-widget-toolkit: 4.3.11

pve-cluster: 8.1.1

pve-container: 5.2.7

pve-docs: 8.4.0

pve-edk2-firmware: 4.2025.02-3

pve-esxi-import-tools: 0.7.4

pve-firewall: 5.1.2

pve-firmware: 3.15-4

pve-ha-manager: 4.0.7

pve-i18n: 3.4.5

pve-qemu-kvm: 9.2.0-6

pve-xtermjs: 5.5.0-2

qemu-server: 8.3.14

smartmontools: 7.3-pve1

spiceterm: 3.3.0

swtpm: 0.8.0+pve1

vncterm: 1.8.0

zfsutils-linux: 2.2.7-pve2PVE Version auf Quellhost

Code:

proxmox-ve: 8.3.0 (running kernel: 6.8.12-4-pve)

pve-manager: 8.3.0 (running version: 8.3.0/c1689ccb1065a83b)

proxmox-kernel-helper: 8.1.0

proxmox-kernel-6.8: 6.8.12-4

proxmox-kernel-6.8.12-4-pve-signed: 6.8.12-4

ceph-fuse: 17.2.7-pve3

corosync: 3.1.7-pve3

criu: 3.17.1-2

glusterfs-client: 10.3-5

ifupdown2: 3.2.0-1+pmx11

ksm-control-daemon: 1.5-1

libjs-extjs: 7.0.0-5

libknet1: 1.28-pve1

libproxmox-acme-perl: 1.5.1

libproxmox-backup-qemu0: 1.4.1

libproxmox-rs-perl: 0.3.4

libpve-access-control: 8.2.0

libpve-apiclient-perl: 3.3.2

libpve-cluster-api-perl: 8.0.10

libpve-cluster-perl: 8.0.10

libpve-common-perl: 8.2.9

libpve-guest-common-perl: 5.1.6

libpve-http-server-perl: 5.1.2

libpve-network-perl: 0.10.0

libpve-rs-perl: 0.9.0

libpve-storage-perl: 8.2.9

libspice-server1: 0.15.1-1

lvm2: 2.03.16-2

lxc-pve: 6.0.0-1

lxcfs: 6.0.0-pve2

novnc-pve: 1.5.0-1

proxmox-backup-client: 3.2.9-1

proxmox-backup-file-restore: 3.2.9-1

proxmox-firewall: 0.6.0

proxmox-kernel-helper: 8.1.0

proxmox-mail-forward: 0.3.1

proxmox-mini-journalreader: 1.4.0

proxmox-offline-mirror-helper: 0.6.7

proxmox-widget-toolkit: 4.3.1

pve-cluster: 8.0.10

pve-container: 5.2.2

pve-docs: 8.3.1

pve-edk2-firmware: 4.2023.08-4

pve-esxi-import-tools: 0.7.2

pve-firewall: 5.1.0

pve-firmware: 3.14-1

pve-ha-manager: 4.0.6

pve-i18n: 3.3.1

pve-qemu-kvm: 9.0.2-4

pve-xtermjs: 5.3.0-3

qemu-server: 8.3.0

smartmontools: 7.3-pve1

spiceterm: 3.3.0

swtpm: 0.8.0+pve1

vncterm: 1.8.0

zfsutils-linux: 2.2.6-pve1ZFS List auf dem Zielhost:

Code:

NAME USED AVAIL REFER MOUNTPOINT

ZFS_PLATTE 1.49M 31.6T 198K /ZFS_PLATTE

ZFS_PLATTE/tmp 140K 31.6T 140K legacy

ZFS_PLATTE/var 279K 31.6T 140K none

ZFS_PLATTE/var/tmp 140K 31.6T 140K legacy

rpool 4.92G 425G 104K /rpool

rpool/ROOT 4.86G 425G 96K /rpool/ROOT

rpool/ROOT/pve-1 4.86G 425G 4.86G /

rpool/data 96K 425G 96K /rpool/data

rpool/var-lib-vz 96K 425G 96K /var/lib/vzZFS List auf dem Quellhost:

Code:

NAME USED AVAIL REFER MOUNTPOINT

ZFS_PLATTE 7.11T 5.48T 96K /ZFS_PLATTE

ZFS_PLATTE/vm-115-disk-0 7.11T 6.76T 5.84T -