Hallo,

der in Proxmox angezeigte RAM-Verbrauch einer VM spiegelt leider nicht den "tatsächlichen" RAM-Verbrauch wider (zumindest nicht bei mir). Das Ganze wurde schon in diversen anderen Threads diskutiert. So wie ich das verstanden habe, müsste Proxmox allerdings den realen Verbrauch anzeigen, sofern das Ballooning-Device aktiviert ist.

Ich verwende keine dynamische Speicherallokation, minimaler und maximaler Speicherwert bei mir sind also identisch.

Balloning ist ebenfalls aktiviert.

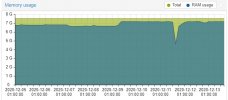

Bei meinen Linux-VMs wird aber nicht der tatsächliche RAM-Verbrauch angezeigt, sondern stets nur ein langsam immer bis zu 100% anwachsender Wert.

Ist es irgendwie möglich, hier den realen Verbrauch anzuzeigen? Bzw. mache ich etwas falsch? Muss vielleicht auf der Linux-VM noch etwas getan werden? Auch mit installiertem Guest-Agent wird der "falsche" (nicht-reale) Wert angezeigt.

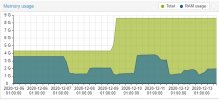

Bei meinen Windows-VMs hingegen wird der tatsächliche Verbrauch zurückgeliefert, hier habe ich das Balloning-Device und sämtliche anderen VirtIO-Treiber inklusive Guest-Agent installiert.

Viele Grüße und danke für eure Hilfe!

der in Proxmox angezeigte RAM-Verbrauch einer VM spiegelt leider nicht den "tatsächlichen" RAM-Verbrauch wider (zumindest nicht bei mir). Das Ganze wurde schon in diversen anderen Threads diskutiert. So wie ich das verstanden habe, müsste Proxmox allerdings den realen Verbrauch anzeigen, sofern das Ballooning-Device aktiviert ist.

Ich verwende keine dynamische Speicherallokation, minimaler und maximaler Speicherwert bei mir sind also identisch.

Balloning ist ebenfalls aktiviert.

Bei meinen Linux-VMs wird aber nicht der tatsächliche RAM-Verbrauch angezeigt, sondern stets nur ein langsam immer bis zu 100% anwachsender Wert.

Ist es irgendwie möglich, hier den realen Verbrauch anzuzeigen? Bzw. mache ich etwas falsch? Muss vielleicht auf der Linux-VM noch etwas getan werden? Auch mit installiertem Guest-Agent wird der "falsche" (nicht-reale) Wert angezeigt.

Bei meinen Windows-VMs hingegen wird der tatsächliche Verbrauch zurückgeliefert, hier habe ich das Balloning-Device und sämtliche anderen VirtIO-Treiber inklusive Guest-Agent installiert.

Viele Grüße und danke für eure Hilfe!