Weder noch, in diesem Beitrag der letzte Befehl (hatte ich vorhin noch hinzugefügt, vielleicht haste Du du das übersehen).Welche Log genau aus /var/log/ brauchst du? syslog?

[SOLVED] PVE 9.1.4 RAM läuft voll und OOM-Killer schießt VMs ab

- Thread starter Deviss

- Start date

You are using an out of date browser. It may not display this or other websites correctly.

You should upgrade or use an alternative browser.

You should upgrade or use an alternative browser.

Weder noch, in diesem Beitrag der letzte Befehl (hatte ich vorhin noch hinzugefügt, vielleicht haste Du du das übersehen).

Ja, den hatte ich übersehen. Jetzt läuft er. Lade ich dann hier hoch.

Den Host starte ich später durch ohne VMs zu starten und lass ihn bis morgen früh vor der Arbeit ca. 05:30 laufen. Das sollte reichen oder? Dann post ich morgen nochmal die Ausgabe.

Ausgabe wegen Zeichenlimitierung gekürzt. Volle Ausgabe als File angehangen.

Ausgabe von

Ausgabe von

slabtop -o nach ca 7,5h idle:

Bash:

Active / Total Objects (% used) : 996221 / 1002640 (99.4%)

Active / Total Slabs (% used) : 18285 / 18285 (100.0%)

Active / Total Caches (% used) : 376 / 461 (81.6%)

Active / Total Size (% used) : 203426.48K / 205430.73K (99.0%)

Minimum / Average / Maximum Object : 0.01K / 0.20K / 16.00K

OBJS ACTIVE USE OBJ SIZE SLABS OBJ/SLAB CACHE SIZE NAME

71940 71890 99% 0.13K 2398 30 9592K kernfs_node_cache

44031 44031 100% 0.10K 1129 39 4516K buffer_head

35028 34944 99% 0.19K 834 42 6672K dentry

32480 31986 98% 0.07K 580 56 2320K vmap_area

32246 32246 100% 0.09K 701 46 2804K lsm_inode_cache

18944 17408 91% 0.01K 37 512 148K kmalloc-rnd-09-8

16384 16384 100% 0.01K 32 512 128K kmalloc-rnd-14-8

16170 15869 98% 0.19K 385 42 3080K vm_area_struct

14080 13114 93% 0.06K 220 64 880K anon_vma_chain

13312 13312 100% 0.01K 26 512 104K kmalloc-rnd-10-8

12800 12800 100% 0.01K 25 512 100K kmalloc-rnd-15-8

12288 12288 100% 0.01K 24 512 96K memdup_user-8

12288 12288 100% 0.01K 24 512 96K kmalloc-cg-8

12288 12288 100% 0.02K 48 256 192K kmalloc-rnd-14-16

12288 12288 100% 0.01K 24 512 96K kmalloc-rnd-12-8

12288 12288 100% 0.01K 24 512 96K kmalloc-rnd-08-8

12288 12288 100% 0.01K 24 512 96K kmalloc-rnd-07-8

12288 12288 100% 0.01K 24 512 96K kmalloc-rnd-06-8

12288 12288 100% 0.01K 24 512 96K kmalloc-8

12032 12032 100% 0.06K 188 64 752K kmalloc-rnd-12-64

11934 11934 100% 0.04K 117 102 468K extent_status

11776 11776 100% 0.01K 23 512 92K kmalloc-rnd-05-8

11776 11776 100% 0.01K 23 512 92K kmalloc-rnd-02-8

11625 11586 99% 0.62K 465 25 7440K inode_cache

11264 11264 100% 0.01K 22 512 88K kmalloc-rnd-11-8

11264 11264 100% 0.01K 22 512 88K kmalloc-rnd-01-8

9728 9728 100% 0.01K 19 512 76K kmalloc-rnd-13-8

8658 8627 99% 0.10K 222 39 888K anon_vma

8352 8352 100% 1.10K 288 29 9216K ext4_inode_cache

8103 8103 100% 0.05K 111 73 444K ftrace_event_field

7644 7617 99% 0.57K 273 28 4368K radix_tree_node

6592 6592 100% 0.50K 206 32 3296K kmalloc-rnd-10-512

6400 6400 100% 0.02K 25 256 100K kmalloc-rnd-15-16

6400 6400 100% 0.02K 25 256 100K kmalloc-rnd-11-16

6144 6144 100% 0.02K 24 256 96K ep_head

6144 6144 100% 0.02K 24 256 96K memdup_user-16

6144 6144 100% 0.02K 24 256 96K kmalloc-cg-16

6144 6144 100% 0.02K 24 256 96K kmalloc-rnd-13-16

6144 6144 100% 0.02K 24 256 96K kmalloc-rnd-12-16

6144 6144 100% 0.02K 24 256 96K kmalloc-rnd-09-16

6144 6144 100% 0.02K 24 256 96K kmalloc-rnd-08-16

6144 6144 100% 0.02K 24 256 96K kmalloc-rnd-07-16

6144 6144 100% 0.02K 24 256 96K kmalloc-rnd-06-16

6144 6144 100% 0.02K 24 256 96K kmalloc-rnd-05-16

6144 6144 100% 0.02K 24 256 96K kmalloc-rnd-04-16

6144 6144 100% 0.02K 24 256 96K kmalloc-rnd-02-16

6144 6144 100% 0.02K 24 256 96K kmalloc-16

6132 6132 100% 0.09K 146 42 584K kmalloc-rnd-12-96

5950 5950 100% 0.02K 35 170 140K lsm_file_cache

5760 5760 100% 0.03K 45 128 180K kmalloc-rnd-14-32

5632 5632 100% 0.02K 22 256 88K kmalloc-rnd-10-16

5376 5376 100% 0.02K 21 256 84K kmalloc-rnd-01-16

5312 3895 73% 0.25K 166 32 1328K maple_node

5015 5015 100% 0.05K 59 85 236K shared_policy_node

4746 4746 100% 0.19K 113 42 904K filp

4736 4736 100% 0.03K 37 128 148K kmalloc-rnd-10-32

4692 4588 97% 0.69K 102 46 3264K proc_inode_cache

4512 4487 99% 0.50K 141 32 2256K kmalloc-rnd-09-512

4416 4416 100% 0.06K 69 64 276K kmalloc-rnd-10-64

4250 4173 98% 0.63K 170 25 2720K debugfs_inode_cache

4224 4224 100% 0.03K 33 128 132K kmalloc-rnd-11-32

4200 4008 95% 0.09K 100 42 400K kmalloc-rnd-03-96

4096 4096 100% 0.03K 32 128 128K kmalloc-rnd-15-32

3990 3990 100% 0.19K 95 42 760K pid

3864 3864 100% 0.09K 92 42 368K kmalloc-rnd-10-96

3712 3712 100% 0.03K 29 128 116K kmalloc-cg-32

3612 3612 100% 0.09K 86 42 344K trace_event_file

3584 3584 100% 0.03K 28 128 112K kmalloc-rnd-04-32

3584 3584 100% 0.01K 7 512 28K kmalloc-rnd-04-8

3567 3545 99% 0.77K 87 41 2784K shmem_inode_cache

3328 3328 100% 0.03K 26 128 104K kmalloc-32

3315 3315 100% 0.05K 39 85 156K zio_link_cache

3200 3200 100% 0.03K 25 128 100K kmalloc-rcl-32

3200 3200 100% 0.03K 25 128 100K kmalloc-rnd-09-32

3200 3200 100% 0.03K 25 128 100K kmalloc-rnd-08-32

3072 3072 100% 0.03K 24 128 96K arc_buf_t

3072 3072 100% 0.03K 24 128 96K xsk_generic_xmit_cache

3072 3072 100% 0.03K 24 128 96K pidfs_attr_cache

3072 3072 100% 0.03K 24 128 96K kmalloc-rnd-13-32

3072 3072 100% 0.03K 24 128 96K kmalloc-rnd-12-32

3072 3072 100% 0.03K 24 128 96K kmalloc-rnd-06-32

3072 3072 100% 0.03K 24 128 96K kmalloc-rnd-05-32

3072 3072 100% 0.03K 24 128 96K kmalloc-rnd-02-32

3072 3072 100% 0.03K 24 128 96K kmalloc-rnd-01-32

2944 2944 100% 0.03K 23 128 92K memdup_user-32

2944 2944 100% 0.03K 23 128 92K kmalloc-rnd-03-32

2816 2697 95% 0.50K 88 32 1408K kmalloc-rnd-12-512

2656 2656 100% 0.50K 83 32 1328K pool_workqueue

2646 2646 100% 0.09K 63 42 252K abd_t

2560 2518 98% 0.06K 40 64 160K kmalloc-cg-64

2528 2528 100% 1.00K 79 32 2528K kmalloc-rnd-12-1k

2478 2478 100% 0.19K 59 42 472K kmalloc-rnd-12-192

2448 2448 100% 0.04K 24 102 96K pde_opener

2368 2368 100% 0.06K 37 64 148K kmalloc-rnd-14-64

2352 2352 100% 0.19K 56 42 448K proc_dir_entry

2310 2310 100% 0.09K 55 42 220K kmalloc-rcl-96

2304 2304 100% 0.03K 18 128 72K kmalloc-rnd-07-32

2240 2240 100% 0.06K 35 64 140K kmalloc-rnd-09-64

2240 2240 100% 0.06K 35 64 140K kmalloc-rnd-02-64

2223 2223 100% 0.81K 57 39 1824K sock_inode_cache

2142 2142 100% 0.23K 63 34 504K arc_buf_hdr_t_full

2100 2100 100% 0.09K 50 42 200K kmalloc-rnd-11-96

2070 1978 95% 0.69K 45 46 1440K skbuff_small_head

2048 2048 100% 0.06K 32 64 128K kmalloc-rnd-11-64

2048 2048 100% 0.01K 4 512 16K kmalloc-rnd-03-8

1952 1952 100% 0.12K 61 32 244K eventpoll_epi

1920 1920 100% 0.03K 15 128 60K pending_reservation

1920 1920 100% 0.25K 60 32 480K bio-200

1920 1920 100% 0.06K 30 64 120K kmalloc-rnd-04-64

1856 1856 100% 0.25K 58 32 464K skbuff_head_cache

1856 1856 100% 0.06K 29 64 116K kmalloc-rnd-05-64

1856 1856 100% 0.06K 29 64 116K kmalloc-64

1806 1669 92% 0.19K 43 42 344K kmalloc-cg-192

1792 1792 100% 0.06K 28 64 112K kmalloc-rnd-15-64

1792 1792 100% 0.06K 28 64 112K kmalloc-rnd-13-64

1792 1792 100% 0.25K 56 32 448K kmalloc-rnd-09-256

1760 1760 100% 0.12K 55 32 220K kmalloc-rnd-02-128

1752 1752 100% 0.05K 24 73 96K mb_cache_entry

1750 1725 98% 0.31K 70 25 560K bio-256

1728 1728 100% 0.06K 27 64 108K kmalloc-rnd-07-64

1680 1680 100% 0.09K 40 42 160K kmalloc-cg-96

1664 1560 93% 0.12K 52 32 208K kmalloc-cg-128

1652 1596 96% 1.12K 59 28 1888K signal_cache

1600 1600 100% 0.06K 25 64 100K kmalloc-rnd-06-64

1600 1600 100% 0.06K 25 64 100K kmalloc-rnd-03-64

1554 1554 100% 0.19K 37 42 296K kmalloc-rnd-05-192

1536 1536 100% 0.06K 24 64 96K ext4_io_end

1536 1536 100% 0.06K 24 64 96K dmaengine-unmap-2

1536 1536 100% 0.06K 24 64 96K kmalloc-rcl-64

1536 1536 100% 0.06K 24 64 96K kmalloc-rnd-01-64

1470 1470 100% 0.38K 35 42 560K mnt_cache

1456 1352 92% 1.19K 56 26 1792K zio_cache

1408 1408 100% 0.36K 32 44 512K dmu_buf_impl_t

1386 1386 100% 0.09K 33 42 132K kmalloc-rnd-07-96

1312 1312 100% 0.25K 41 32 328K kmalloc-rnd-06-256

1280 1280 100% 0.12K 40 32 160K kmalloc-rnd-12-128

1275 1275 100% 0.08K 25 51 100K sigqueue

1275 1275 100% 0.08K 25 51 100K Acpi-State

1218 1218 100% 0.09K 29 42 116K kmalloc-96

1176 1176 100% 0.19K 28 42 224K kmalloc-rnd-13-192

1156 1156 100% 0.12K 34 34 136K jbd2_journal_head

1152 1152 100% 0.06K 18 64 72K memdup_user-64

1152 1152 100% 0.12K 36 32 144K kmalloc-rnd-10-128

1134 1134 100% 0.19K 27 42 216K kmalloc-rnd-14-192

1134 1134 100% 0.09K 27 42 108K kmalloc-rnd-13-96

1134 1134 100% 0.09K 27 42 108K kmalloc-rnd-09-96

1134 1134 100% 0.19K 27 42 216K kmalloc-rnd-02-192

1120 1120 100% 0.50K 35 32 560K kmalloc-rnd-03-512

1104 1104 100% 0.17K 24 46 192K fuse_request

1104 1104 100% 0.69K 24 46 768K files_cache

1095 1026 93% 2.06K 73 15 2336K sighand_cache

1092 1092 100% 0.19K 26 42 208K kmalloc-rnd-07-192

1092 1092 100% 0.09K 26 42 104K kmalloc-rnd-02-96

1050 1050 100% 0.19K 25 42 200K file_lock_cache

1050 1050 100% 0.19K 25 42 200K kmalloc-rnd-11-192

1050 1050 100% 0.09K 25 42 100K kmalloc-rnd-06-96

1050 1050 100% 0.19K 25 42 200K kmalloc-rnd-03-192

1050 1050 100% 0.19K 25 42 200K kmalloc-192

1024 1024 100% 0.12K 32 32 128K kmalloc-rnd-09-128

1024 1024 100% 0.06K 16 64 64K kmalloc-rnd-08-64

1024 1024 100% 0.02K 4 256 16K kmalloc-rnd-03-16

1008 1008 100% 0.19K 24 42 192K jbd2_transaction_s

1008 1008 100% 0.19K 24 42 192K kmalloc-rnd-15-192

1008 1008 100% 0.19K 24 42 192K kmalloc-rnd-09-192

1008 1008 100% 0.09K 24 42 96K kmalloc-rnd-05-96

1008 1008 100% 0.19K 24 42 192K kmalloc-rnd-01-192

1008 1008 100% 0.09K 24 42 96K kmalloc-rnd-01-96

966 966 100% 0.09K 23 42 92K kmalloc-rnd-15-96

966 966 100% 0.19K 23 42 184K kmalloc-rnd-04-192

966 966 100% 0.09K 23 42 92K kmalloc-rnd-04-96

960 800 83% 0.12K 30 32 120K kmalloc-rnd-11-128

936 869 92% 4.00K 117 8 3744K zfs_btree_leaf_cache

896 896 100% 0.07K 16 56 64K nsproxy

896 896 100% 1.00K 28 32 896K kmalloc-rnd-14-1k

896 896 100% 0.50K 28 32 448K kmalloc-rnd-14-512

896 896 100% 0.06K 14 64 56K kmem_cache_node

884 884 100% 0.93K 26 34 832K dnode_tAttachments

Mich würde mal interessieren ob dein System aktuell ist.Guten Abend,

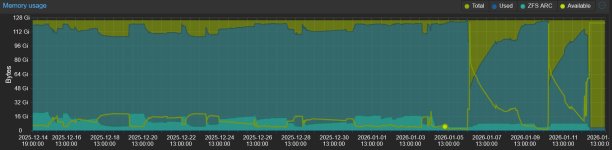

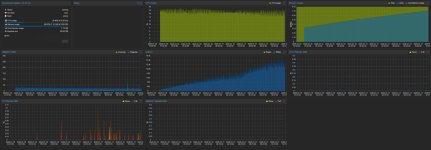

ich betreibe meinen Server auf AM5 Basis mit 128GB RAM nun schon seit weiter über einem Jahr. Damals mit PVE 8.x angefangen.

Ich hatte bisher noch nie Probleme, seit ich jedoch Mitte Dezember auf PVE 9.x geupgraded habe, fing mein RAM Problem an.

Ich habe die Tage festgestellt, dass ein Server nicht erreichbar war und überprüfte dies mit der WebGUI von PVE. Dort stellt ich fest, dass die VM aus ist und diese lies sich nicht starten. Im Log wurde angezeigt, dass die VM vom OOM Killer beendet wurde, weil RAM + SWAP vollgelaufen sind. Zu diesem Zeitpunkt lief der Server ca. 30 Tage, es half nur ein Neustart vom Node, dieser hat nun knapp 4 Tage durchgehalten und lief wieder voll.

Die VMs sind seit ich sie erstellt habe auf Ballooning konfiguriert. Immer mit einer gewissen Menge Basis RAM und einer maximalen Menge. Sollte jede VM ihren kompletten RAM ausschöpfen, würden aktuell 64 GB genutzt werden. ZFS-ARC ist auf 8GB limitiert.

Ich habe nachdem zweiten Mal die VMs auf fixe RAM einstellungen umkonfiguriert, auch hier, maximal 64GB über alle VMs. Trotzdem frisst der Host schon wieder kontinuierlich RAM und ist bald wieder dabei den SWAP zu füllen.

Weiß jemand wie ich hier eine Lösung finde? Alle paar Tage neustarten ist nicht in meinem Sinne.

Edit:

RAM Wert von 54 auf 64 korrigiert.

Mit dem 6.14er Kernel gab es einen Bug wo mit bestimmter Hardware der RAM Verbrauch permanent gestiegen ist und nur per Reboot geleert werden konnte.

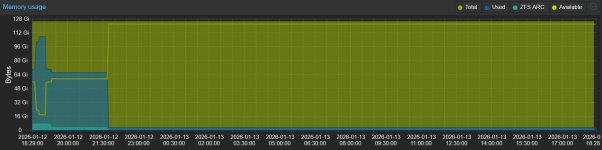

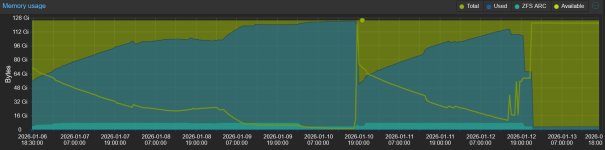

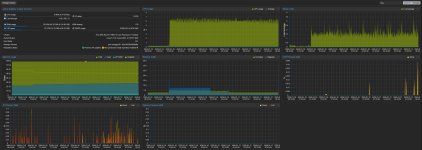

Also können wir sagen, dass nach 7.5h das System keine Anzeichen von Speicherleaks hat, korrekt (solange keine VMs gestartet worden sind)? Haste mal die Grafik für den RAM-Verbrauch des Systems? Also gerne auch einmal Stunde, Woche, Monatsdarstellung?Ausgabe wegen Zeichenlimitierung gekürzt. Volle Ausgabe als File angehangen.

Deine Snoop-Datei habe ich mir angeschaut aber auf die schnelle nichts gefunden womit ich das erklären kann. Bin hier noch am überlegen.

Mich würde mal interessieren ob dein System aktuell ist.

Mit dem 6.14er Kernel gab es einen Bug wo mit bestimmter Hardware der RAM Verbrauch permanent gestiegen ist und nur per Reboot geleert werden konnte.

Ja ist es, hab erst vor 3 Tagen die vorhandenen Updates eingespielt.

Bin bei Version 9.1.4 mit Kernel 6.17.4-2-pve

Genau, stand jetzt hat sich seit dem Reboot gestern Abend nichts geändert. Das System hat relativ konstant 3Gib in Beschlag.Also können wir sagen, dass nach 7.5h das System keine Anzeichen von Speicherleaks hat, korrekt (solange keine VMs gestartet worden sind)? Haste mal die Grafik für den RAM-Verbrauch des Systems? Also gerne auch einmal Stunde, Woche, Monatsdarstellung?

Deine Snoop-Datei habe ich mir angeschaut aber auf die schnelle nichts gefunden womit ich das erklären kann. Bin hier noch am überlegen.

Klar, gib mir einen Moment, dann lade ich die hoch.

Die Fehlersuche dauert mit Dir ein wenig länger  Meine Vorschlag:

Meine Vorschlag:

Fahr mal nach und nach VMs hoch und lasse die so laufen. Also fang mit z.B. Jellyfish an, lass die mit dem System für ein paar Stunden laufen, schau was passiert und habe slabtop im Auge (Wenn sich da ein Wert immer weiter nach oben entwickelt). Usw Usw.

Das wird ein paar Tage dauert (ich würde z.B. jeden Tag eine VM hinzunehmen), aber anders kommen wir nicht an den Miesepeter hier.

Fahr mal nach und nach VMs hoch und lasse die so laufen. Also fang mit z.B. Jellyfish an, lass die mit dem System für ein paar Stunden laufen, schau was passiert und habe slabtop im Auge (Wenn sich da ein Wert immer weiter nach oben entwickelt). Usw Usw.

Das wird ein paar Tage dauert (ich würde z.B. jeden Tag eine VM hinzunehmen), aber anders kommen wir nicht an den Miesepeter hier.

Die Fehlersuche dauert mit Dir ein wenig längerMeine Vorschlag:

Fahr mal nach und nach VMs hoch und lasse die so laufen. Also fang mit z.B. Jellyfish an, lass die mit dem System für ein paar Stunden laufen, schau was passiert und habe slabtop im Auge (Wenn sich da ein Wert immer weiter nach oben entwickelt). Usw Usw.

Das wird ein paar Tage dauert (ich würde z.B. jeden Tag eine VM hinzunehmen), aber anders kommen wir nicht an den Miesepeter hier.

Ja das mach ich so. Habe jetzt mit Jellyfin begonnen.

Btw. heute Vormittag ist der Server "gecrashed" er war zwar an aber via SSH nicht erreichbar, da mir Postfix die Logs gespammt hat. Der "Mail" versand an root kommt ja via Cron, könnte das eine Ursache für mein RAM Problem sein? Mir sind zwar bisher keine solchen Meldungen in den älteren Syslogs aufgefallen.

Hier der Auszug:

Bash:

2026-01-14T00:42:26.202089+01:00 prxmx postfix/local[753128]: warning: hash:/etc/aliases is unavailable. open database /etc/aliases.db: No such file or directory

2026-01-14T00:42:26.202118+01:00 prxmx postfix/local[753128]: warning: hash:/etc/aliases: lookup of 'root' failed

2026-01-14T00:42:26.202528+01:00 prxmx postfix/local[753129]: D98FF601E6: to=<root@prxmx.home>, relay=local, delay=382565, delays=382565/0.01/0/0, dsn=4.3.0, status=deferred (alias database unavailable)

2026-01-14T00:42:26.203075+01:00 prxmx postfix/local[753128]: BDD7F601DF: to=<root@prxmx.home>, relay=local, delay=382592, delays=382592/0.01/0/0, dsn=4.3.0, status=deferred (alias database unavailable)Habe das auch vermutlich behoben, muss das mal beobachten.

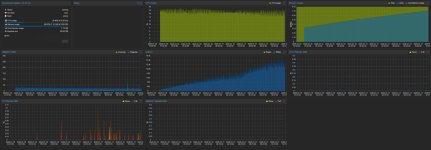

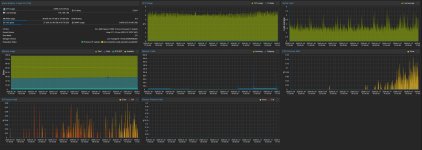

@fstrankowski: Ich habe jetzt einzeln die Jellyfin VM sowie die Opnsense gestartet und zu letzte die DockerHost VM. Letztere erzeugt in meinen Augen komische Werte bzw. Auffälligkeiten. Seit die DockerHost VM an ist, habe ich I/O Pressure Stall, deutlich mehr Disk IO und steigenden RAM. Soweit ich das gesehen habe, hat die VM zwar die 8GB RAM welche ich ihr zugeteilt habe vom Host beansprucht, jedoch noch nicht komplett in der VM gefüllt. Diese nutzt den RAM scheinbar vorallem fürs Caching.

Es ist halt auf der VM keine Last, daher weiß ich eigentlich auch nicht was diese mit dem RAM aktuell will.

Ausgabe von

Ausgabe von

VM Summary:

Node Summary:

Edit:

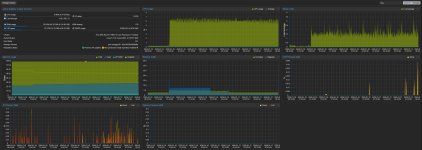

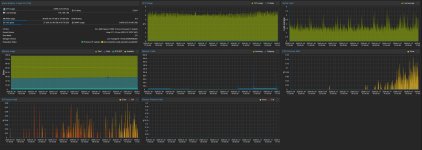

Es ist sogar noch merkwürdiger geworden, ich habe nun auch einen deutlichen CPU Pressure Stall. Hier ein Screenshot der aktuellen Node Summary:

Es ist halt auf der VM keine Last, daher weiß ich eigentlich auch nicht was diese mit dem RAM aktuell will.

Ausgabe von

free -h DockerHost VM von heute morgen:

Bash:

gesamt benutzt frei gemns. Puffer/Cache verfügbar

Speicher: 7,8Gi 1,5Gi 2,3Gi 4,0Mi 4,4Gi 6,3Gi

Swap: 974Mi 0B 974MiAusgabe von

free -h zum Zeitpunkt des Posts:

Bash:

Sa 17. Jan 16:54:28 CET 2026

salty@DockerHost:~$ free -h

gesamt benutzt frei gemns. Puffer/Cache verfügbar

Speicher: 7,8Gi 1,9Gi 908Mi 4,0Mi 5,4Gi 5,9Gi

Swap: 974Mi 0B 974MiVM Summary:

Node Summary:

Edit:

Es ist sogar noch merkwürdiger geworden, ich habe nun auch einen deutlichen CPU Pressure Stall. Hier ein Screenshot der aktuellen Node Summary:

Attachments

Last edited:

Das sind doch winzige Zahlen in den Bild.... ich habe nun auch einen deutlichen CPU Pressure Stall.

Das sind doch winzige Zahlen in den Bild.

Dafür dass dort nur ein paar VMs im idle laufen, finde ich das eigentlich zuviel.

Nichts desto trotz, werde ich den Thread mal auf SOLVED stellen, da nachdem sich Proxmox aufgehangen hatte und ich den Server hart neustarten musste und diesen mal ein paar Minuten ausgelassen hatte, läuft dieser jetzt wieder wie gewohnt.

Ballooning ist weiterhin aus, bisher werden trotz Nutzern nur der RAM verbaucht, den ich erwartet bzw eingestellt habe. Dank an alle für die Hilfe.

Das sieht ganz klar nach zu überbuchter CPU aus. Wie viele VMs hast du und wie sieht das CPU Sizing der VMs aus?Es ist sogar noch merkwürdiger geworden, ich habe nun auch einen deutlichen CPU Pressure Stall. Hier ein Screenshot der aktuellen Node Summary:

View attachment 95007