Hallo zusammen,

nach längerer Recherche im Netz habe ich zu meinem Problem leider keine wirklich zufriedenstellende Erklärung gefunden – daher hoffe ich, dass mir hier im Forum vielleicht jemand weiterhelfen kann.

Wir betreiben einen 3-Node PVE-Cluster, auf dem sowohl interne VMs als auch Kundensysteme laufen.

Da wir produktive Workloads hosten, kann ich leider nicht „einfach mal testen“ oder Nodes spontan neu starten, ohne einen geplanten Wartungstermin.

Mit der Zeit scheint auf allen drei Hosts der Arbeitsspeicher vollzulaufen – zumindest laut Anzeige in der Proxmox-GUI.

Zuerst dachte ich an ein Memory Leak in einem Dienst oder Prozess, aber das konnte ich ausschließen.

Nach weiteren Analysen sieht es so aus, als würde nicht Proxmox selbst, sondern das darunterliegende Debian-System (bzw. der Linux-Kernel) den RAM zunehmend für Caches und Buffers belegen, ohne diesen als „verfügbar“ anzuzeigen.

Ich wollte daher einfach einmal nachfragen:

Hier ein aktuelles Beispiel von einem unserer Hosts:

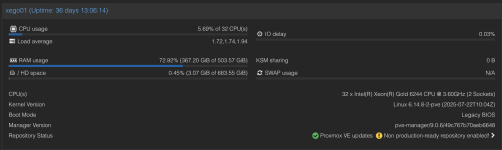

Und hier nun meine Summary Seite der Node:

Die tatsächliche Auslastung durch VMs und Ceph liegt also bei rund 93 GiB, während Proxmox in der GUI über 360 GiB genutzt anzeigt.

Wäre der Unterschied nur ein paar Prozent, wäre das kein Thema – aber fast 400 GiB „belegter RAM“, obwohl effektiv nur rund 100 GiB genutzt werden, wirkt auf mich etwas merkwürdig.

Hat jemand ähnliche Beobachtungen gemacht oder eine Idee, wie man die Anzeige im Proxmox-GUI realitätsnäher gestalten kann?

Vielen Dank schon einmal für jede Rückmeldung!

Beste Grüße

Yannik

nach längerer Recherche im Netz habe ich zu meinem Problem leider keine wirklich zufriedenstellende Erklärung gefunden – daher hoffe ich, dass mir hier im Forum vielleicht jemand weiterhelfen kann.

Unsere Umgebung

Wir betreiben einen 3-Node PVE-Cluster, auf dem sowohl interne VMs als auch Kundensysteme laufen.

Da wir produktive Workloads hosten, kann ich leider nicht „einfach mal testen“ oder Nodes spontan neu starten, ohne einen geplanten Wartungstermin.

Das Problem

Mit der Zeit scheint auf allen drei Hosts der Arbeitsspeicher vollzulaufen – zumindest laut Anzeige in der Proxmox-GUI.

Zuerst dachte ich an ein Memory Leak in einem Dienst oder Prozess, aber das konnte ich ausschließen.

Nach weiteren Analysen sieht es so aus, als würde nicht Proxmox selbst, sondern das darunterliegende Debian-System (bzw. der Linux-Kernel) den RAM zunehmend für Caches und Buffers belegen, ohne diesen als „verfügbar“ anzuzeigen.

Ich wollte daher einfach einmal nachfragen:

- Ist das Verhalten normal und anderen auch aufgefallen?

- Oder habe ich irgendwo einen Konfigurationsfehler, der dazu führt, dass die GUI den RAM-Verbrauch falsch interpretiert?

Beispielausgabe

Hier ein aktuelles Beispiel von einem unserer Hosts:

Bash:

goeltz.yannik@xego01:~# echo "VMs:"; ps -eo comm,rss | awk '/qemu|kvm/ {sum+=$2} END {printf " %.1f GiB\n", sum/1024/1024}'

echo "Ceph:"; ps -eo comm,rss | awk '/ceph/ {sum+=$2} END {printf " %.1f GiB\n", sum/1024/1024}'

echo "Total host used:"; free -h

VMs:

83.9 GiB

Ceph:

9.4 GiB

Total host used:

total used free shared buff/cache available

Mem: 503Gi 366Gi 43Gi 181Mi 98Gi 136Gi

Swap: 0B 0B 0B

goeltz.yannik@xego01:~#Und hier nun meine Summary Seite der Node:

Die tatsächliche Auslastung durch VMs und Ceph liegt also bei rund 93 GiB, während Proxmox in der GUI über 360 GiB genutzt anzeigt.

Wäre der Unterschied nur ein paar Prozent, wäre das kein Thema – aber fast 400 GiB „belegter RAM“, obwohl effektiv nur rund 100 GiB genutzt werden, wirkt auf mich etwas merkwürdig.

Hat jemand ähnliche Beobachtungen gemacht oder eine Idee, wie man die Anzeige im Proxmox-GUI realitätsnäher gestalten kann?

Vielen Dank schon einmal für jede Rückmeldung!

Beste Grüße

Yannik