Guten Tag zusammen,

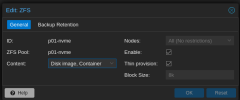

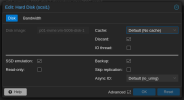

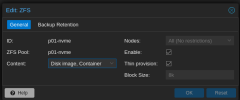

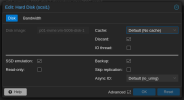

ich habe aktuell das Problem, dass das Thin Provisioning auf meinem ZFS Pool nicht zu funktionieren scheint. Eventuell habe ich irgendwo einen Konfigurationsfehler, das möchte ich nicht ausschließen, eventuell kann mir aber ein findiger User hier kurz aushelfen.

Ich danke vielmals für die Hilfe, bitte bei weiteren benötigten Infos gerne auf mich zukommen!

Gruß Atomique

ich habe aktuell das Problem, dass das Thin Provisioning auf meinem ZFS Pool nicht zu funktionieren scheint. Eventuell habe ich irgendwo einen Konfigurationsfehler, das möchte ich nicht ausschließen, eventuell kann mir aber ein findiger User hier kurz aushelfen.

- Versucht hatte ich bereits die Tipps aus diesem Thread hier: https://forum.proxmox.com/threads/zfs-enable-thin-provisioning.41549/

- Ebenso habe ich in alter VMware Manier die Disk von einem Storage auf den anderen und wieder zurück zu migrieren, leider ohne Erfolg.

Ich danke vielmals für die Hilfe, bitte bei weiteren benötigten Infos gerne auf mich zukommen!

Gruß Atomique

Last edited: