[SOLVED] Proxmox und VM auf einem Laufwerk?

- Thread starter Rheinold

- Start date

You are using an out of date browser. It may not display this or other websites correctly.

You should upgrade or use an alternative browser.

You should upgrade or use an alternative browser.

Das Frage ich mich auch ;-)hm, wofür ist dann die teure Karte da drin?

Spätestens seit der Erfindung von ZFS kann man darüber streiten - mit durchaus offenem Ausgang.Hardware Raids sind doch immer besser als Softwareraids.

Ein Hardware-Raid liefert NICHT: herstellerunabhängigkeit; transparente Kompression; garantierte Integrität; (technisch) billige Snapshots; Replikation; einfache Erweiterbarkeit und wohl einige mehr.

Einige dieser fehlenden Fähigkeiten werden durch die an Hardware-Raid angeflanschte Software wettgemacht (LVM, .qcow2). Aber mit ZFS bekommt man den ganzen Stack aus einem Guss, ohne komplexe Stapelung mehrerer formal unabhängiger Softwareprodukte - und somit ohne "Reibungsverluste".

Ja, ich bin ZFS-Fan ;-) https://forum.proxmox.com/threads/f...y-a-few-disks-should-i-use-zfs-at-all.160037/

Naja..., wie du willst ;-)ok, aber löst das jetzt mein Problem, oder war das nur ein gut gemeinter Rat?

Ich installiere PVE immer auf ZFS. (Und ich habe ein paar klassische, recht alte, Raid-Controller ausgemustert im Schrank liegen...)

Sind denn alle Disks gleichwertig, oder sind das SSDs + HDDs? Das wurde anscheinend nirgends erwähnt.

Ich unterstelle also mal zwei SSD + zwei (oder mehrere) HDD und dass dies ein kompakter Universal-PVE werden soll. In dem Fall installierst du PVE auf ZFS auf den HDD(!), als ZFS-Mirror. Später, wenn alles läuft, fügst du die beiden SSDs als "Special Device"-Mirror dem existierendem "rpool" hinzu.

Alle Metadaten und "small blocks" (nach expliziter Konfiguration) landen dann auf den SSD und alle "eigentlichen" Daten auf den HDDs. So habe ich mehrere PBS' realisiert; PBS braucht nominell viele IOPS. Meine PVE sind allerdings alle "SSD/NVMe-only", ohne Blech.

Disclaimer: es gibt viele, viele Möglichkeiten - mein Vorschlag muss nicht zwingend der Beste sein!

Edit: nochmal zur Frage: der entstehende, einzige "rpool" taugt für alles! Dort ist das Betriebssystem installiert, es gibt Directories (ZFS Datasets) und es gibt ZVOLs für Blockdevices für virtuelle Festplatten. Das funktioniert gut!

Last edited:

Ich stimme euch grundsätzlich zu - glaube aber, dass das zu nichts führen wird, denn wir drehen uns schon jetzt irgendwie im Kreis.

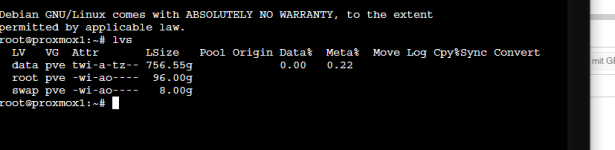

das scheint für mich interessant zu werden. Jetzt komme ich einen großen Schritt weiter. Ich habe die Max Kapazität genommen für die SSD und für maxroot. und jetzt bekomme ich auch diese Disk angezeigt, wenn ich eine VM installieren will. Schauen wir mal weiter, ob es das war.Das einzige was getan werden "muss" istmaxrootbei der Installation auf 50G zu setzen. Wie siehtlvsaktuell aus?

Wieso? Teile bitte was du beim Versuch siehst.

Last edited:

Das sieht eigentlich in Ordnung aus. Der Platz für die PVE Seite ist hier halt 96G anstatt 50G. Standargemäß hast du bei LVM/Ext4 zwei Speicher.

local welches auf dem mit EXT4 formatiertem root liegt (für Dateien wie Isos, Templates, OS, etc) und local-lvm welches auf data liegt (Thin provisionierter Blockspeicher/Rohspeicher) für die Virtuellen Festplatten der Gäste.Bei ZFS teilen sich beide PVE Speicher den Platz, du musst also gar nichts fest zuweisen und das finde ich einfacher/flexibler. ZFS ist aber auf einem HW RAID controller (ohne IT mode) nicht unterstützt und daher momenetan keine Option. Siehe auch hier was proxmox zum Thema SW RAID zu sagen hat.

Der PVE installer macht eigentlich ganz gute Standardeinstellungen.

maxroot auf 50G zu limitieren sollte an dem Verhalten, bis auf die Größe, nichts geändert haben.

Last edited:

Ich kann dem nur zu 80% zustimmen. Wo genau steht denn, dass man kein Hardware Raid mit ZFS nutzen darf. Es wird empfohlen es nicht zu tun, weil Leute die unbedarft danach Fragen keine Ahnung von ZFS haben und oft auch nicht von ihrem Raid controller.Das sieht eigentlich in Ordnung aus. Der Platz für die PVE Seite ist hier halt 96G anstatt 50G. Standargemäß hast du bei LVM/Ext4 zwei Speicher.localwelches auf dem mit EXT4 formatiertemrootliegt (für Dateien wie Isos, Templates, OS, etc) undlocal-lvmwelches aufdataliegt (Thin provisionierter Blockspeicher/Rohspeicher) für die Virtuellen Festplatten der Gäste.

Bei ZFS teilen sich beide PVE Speicher den Platz, du musst also gar nichts fest zuweisen und das finde ich einfacher/flexibler. ZFS ist aber auf einem HW RAID controller (ohne IT mode) nicht unterstützt und daher momenetan keine Option. Siehe auch hier was proxmox zum Thema SW RAID zu sagen hat.

Der PVE installer macht eigentlich ganz gute Standardeinstellungen.maxrootauf 50G zu limitieren sollte an dem Verhalten, bis auf die Größe, nichts geändert haben.

Klar kann man ZFS Single Pools jederzeit mit Hardware Raid benutzen.

Man muss sich nur im klaren sein, dass man den Pool niemals erweitern sollte, immer nur ein vDev benutzen und dass einige ZFS Features wie Selfhealing nicht gehen da ZFS Single.

Mich stört diese Aussage das man ZFS nicht mit Hardware Raid nutzen darf. Sagt den Leuten man sollte es nicht und wenn man keine Ahnung hat und seine Daten schrottet, sollen die nicht angeheult kommen. Ich nutze seit Jahren zuverlässig HWRaid mit ZFS, da die Controller mit dem Batteriecache aus alten HDDs und SATA SSDs deutlich mehr Performance rausholen können.

Der Optimalfall, alles NVMe ist eh immer ohne Raid Controller und ZFS nativ am besten, aber nicht immer vorhanden.

Hier in der PVE Dokumentation. Hier in der OpenZFS Dokumentation. Hier im FrontendWo genau steht denn, dass man kein Hardware Raid mit ZFS nutzen darf

Ich habe keine eigene Erfahrung mit ZFS auf HW RAID, Ich leite nur die Offiziellen Empfehlungen weiter.

Meine Nachricht ist direkt über deiner. Ein Vollzitat ist redundant/unnötig.

Last edited:

Richtig, Empfehlung und nicht Verbot. Auch diese Anzeige ist schon grenzwertig, aber man möchte damit die Unwissenden davon abhalten groben Unfug zu machen.Hier in der PVE Dokumentation. Hier in der OpenZFS Dokumentation. Hier im Frontend

View attachment 95704

Ich habe keine eigene Erfahrung mit ZFS auf HW RAID, Ich leite nur die Offiziellen Empfehlungen weiter.

Meine Nachricht ist direkt über deiner. Ein Vollzitat ist redundant/unnötig.

Unsere PB recyclen die alten FC Storages mit ZFS problemlos. Immer ein 30TB ZFS Single Pool mit einem 1TB NVMe Spezial Device. Rennt problemlos.

Da hätte ich schon wieder meine Probleme mit. Ein Special Device musst du immer mindestens als Mirror machen und wenn du einen Mirror im Pool hast, auch wenn es nur das Special Device ist, macht mir Bauchschmerzen.Unsere PB recyclen die alten FC Storages mit ZFS problemlos. Immer ein 30TB ZFS Single Pool mit einem 1TB NVMe Spezial Device. Rennt problemlos.

Gerade wenn es ein vernünftiges FC Storage ist, wo natürlich auch Cache genutzt wird, braucht man doch gar kein Special Device.

Da mache ich lieber einen reinrassigen Single Pool mit nur einem vDev.

Ja aber warum sollte man es dann tun? Weil man irgendeinen HPE Emterprise Server mit SmartStorage Array hat, und dieser noch einen Wartungsvertrag haben, und man deshalb den Controller nicht flashen oder austauschen kann. Oder weil die die Fans permanent auf 100% laufen, wenn man den Controller gegen etwas ohne HPE-Logo austauscht.Ich kann dem nur zu 80% zustimmen.

Auch sehe ich nicht was diese Diskussion mit der Frage des OPs zu tun hat. Um da aber auch noch meinen Senf dazuzugeben...

Ich würde einfach eine Default Installation mit LVM machen. Die Proxmox Devs werden sich mit den 96GB schon etwas überlegt haben, und wenn die 46GB Unterschied zwischen den gewünschten 50GB und 96GB wirklich ein Problem sind, sollte OP wohl grössere SSDs kaufen, denn bis an den Rand auffüllen sollte man diese Dinger eigentlich nie. Und btw, wenn man das will, kommt ZFS sowieso nicht in Frage.

Last edited:

LVM-Thin mit default root Partition Größe ist die erste Wahl, aber wenn jetzt oder später Replikation genutzt werden soll, braucht man halt ZFS und das geht natürlich auch.Ja aber warum sollte man es dann tun? Weil man irgendeinen HPE Emterprise Server mit SmartStorage Array hat, und diese noch einen Wartungsvertrag haben, und man deshalb den Controller nicht flashen oder austauschen kann. Oder weil die die Fans dann permanent auf 100% laufen, wenn man ihn gegen etwas ohne HPE-Logo austauscht.

Auch sehe ich nicht was diese Diskussion mit der Frage des OPs zu tun hat. Um da aber auch noch meinen Senf dazuzugeben...

Ich würde einfach eine Default Installation mit LVM machen. Die Proxmox Devs werden sich mit den 96GB schon etwas überlegt haben, und wenn die 46GB Unterschied zwischen den gewünschten 50GB und 96GB wirklich ein Problem sind, sollte OP wohl grössere SSDs kaufen, denn bis an den Rand auffüllen sollte man diese Dinger eigentlich nie. Und btw, wenn man das will, kommt ZFS sowieso nicht in Frage.

Ja Repikation in Proxmox und/oder auch snapshot and replication im Allgemeinen ist natürlich neben den Daten-Integritäts-Features ein Killer-Feature von ZFS. Ob man das aber im Homelab oder kleinen KMU wirklich braucht, steht nochmal auf einem anderen Blatt. Da würde ich vorher in einen Proxmox Backup Server investieren bevor ich noch eine oder gar zwei weitere Server nur für "Uptime" kaufen würde. Anyway. Ich denke in diesem konkreten Fall wäre LVM die beste Wahl, und wenn man eine Custom-Partitionierung möchte, könnte man ja noch den Weg via Debian und dann Proxmox Repos hinzufügen gehen.LVM-Thin mit default root Partition Größe ist die erste Wahl, aber wenn jetzt oder später Replikation genutzt werden soll, braucht man halt ZFS und das geht natürlich auch.

Last edited:

Das war mal in den 90ern soDas ist jetzt nicht Dein Ernst? Hardware Raids sind doch immer besser als Softwareraids.

Ernsthaft, Ein MegaRaid ist ja am Ende auch nur ein Software Raid, mit dem Unterschied, dass es von der Firmware einer properitären Broadcom Karte kontrolliert wird, und wenn dir die abraucht, kann es dir das Raid komplett zerschiessen. Das, und Gier, ist der Grund warum Firmen wie HPE, Dell etc auf die eh schon phantastischen Preise von off-brand Karten mit den selben Chips, nochmals 50-100% draufschlagen, weil dann dort, zumindest in der Theorie, garantiert ist, dass vorheriges nicht passiert. Haften, wenn es doch passieret, werden sie deshalb natürlich nicht.

Mein Tipp: Falls du das MegaRaid nutzen/behalten möchtest, nutze einfach die Default LVM Installation. Falls du ZFS willst, frage das Internet, ob die Karte einen IT-Mode hat, falls ja aktiviere den, und nur dann solltest du ZFS nutzen.

Last edited:

Da ist aber viel Meinung mit gar nicht so viel Fakten gemischt.Das war mal in den 90ern so

Ernsthaft, Ein MegaRaid ist ja am Ende auch nur ein Software Raid, mit dem Unterschied, dass es von der Firmware einer properitären Broadcom Karte kontrolliert wird, und wenn dir die abraucht, kann es dir das Raid komplett zerschiessen. Das, und Gier, ist der Grund warum Firmen wie HPE, Dell etc auf die eh schon phantastischen Preise von off-brand Karten mit den selben Chips, nochmals 50-100% draufschlagen, weil dann dort, zumindest in der Theorie, garantiert ist, dass vorheriges nicht passiert. Haften, wenn es doch passieret, werden sie deshalb natürlich nicht.

Mein Tipp: Falls du das MegaRaid nutzen/behalten möchtest, nutze einfach die Default LVM Installation. Falls du ZFS willst, frage das Internet, ob die Karte einen IT-Mode hat, falls ja aktiviere den, und nur dann solltest du ZFS nutzen.

Ein Hardware RAID kann einiges was ein Software RAID niemals kann. Vor allem bei HDDs macht das immer noch extrem viel aus.

Da man für produktiven Workload eh nur noch SSDs nimmt und NVMe günstiger als SAS und SATA sind, haben die Controller eh ausgedient. Bei Archiv und Backupservern mit großen HDDs haben die immer noch ihre Daseinsberechtigung.

Ich habe noch nie ein kaputtes RAID gesehen was ein Controller verursacht hätte. Die haben gute Mechanismen eingebaut das nix passiert.

Wenn mal ein RAID Kaputt gegangen war, dann in der Regel während eines Rebuilds, wenn eine weitere HDD stirbt und der Rebuild noch nicht fertig war. Da hilft auch kein ZFS.

Da kann ich Dir Storys erzählen, da wird die schwarz vor den Augen. Wir haben vor circa 8 Jahren bereits damit begonnen, alle Raid-Controller zu entsorgen. Wenn überhaupt erlauben wir noch JBOD, alles andere fliegt raus. Grund sind nunmal die maximale Abhängigkeit von der Karte, inkompabilität zu anderen Karten, kein offener Standard etc. pp. Das negiert einfach die wenigen Pluspunkte der Karten.Ich habe noch nie ein kaputtes RAID gesehen was ein Controller verursacht hätte. Die haben gute Mechanismen eingebaut das nix passiert.