Hallo Foren Gemeinde,

ich bin über das iobroker Forum zu Proxmox gekommen und nutze es seit ca. 4 Wochen.

Jetzt ist meine SSD mit 120GB etwas zu klein und ich möchte meine Installation gerne auf eine neu 1TB SSD umziehen.

Dazu habe ich mit der aktuellen Clonezilla Version ein Image meiner 120GB SSD Erstellt und versucht dieses Image auf der neuen SSD wieder herzustellen.

Leider schlägt das am Ende mit dieser Meldung fehl:

Wenn ich trotzdem versuche zu booten kommt das:

bei der Abfrage der gefundenen partitionen mit ls bekomme ich immer die Ausgabe: unkown filesystem

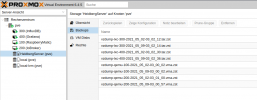

Mein Aktuelle Installation sieht so aus:

Proxmox 6.1.8

motioneye (pve), nextcloud (pve) sind einzelne ZFS HDD's

omv (pve) ein ZFS pool aus zwei HDD's

Alle VM's und Container habe ich gesichert.

Wenn ich auf der neuen 1TB SSD Proxmox neu installiere kann ich die HDD's nicht hinzufügen da Sie mir nicht als Verfügbar angezeigt werden.

Geht das erst nachdem ich die VM's/Container wieder hergestellt habe?

Wie sieht die einfachste oder beste Vorgehensweise aus um den Umzug zu bewerkstelligen?

Danke für eure Hilfe

ich bin über das iobroker Forum zu Proxmox gekommen und nutze es seit ca. 4 Wochen.

Jetzt ist meine SSD mit 120GB etwas zu klein und ich möchte meine Installation gerne auf eine neu 1TB SSD umziehen.

Dazu habe ich mit der aktuellen Clonezilla Version ein Image meiner 120GB SSD Erstellt und versucht dieses Image auf der neuen SSD wieder herzustellen.

Leider schlägt das am Ende mit dieser Meldung fehl:

Code:

Restoring the VG config...

Consider using the option --force to restore Volume Group pve with thin volumes.

Restore failed.Wenn ich trotzdem versuche zu booten kommt das:

Code:

error: disk 'lvmid/xxxxxxxxxxxxxxxxxxxxxxxxxxxx' not found

Entering rescue mode...

grub rescue>bei der Abfrage der gefundenen partitionen mit ls bekomme ich immer die Ausgabe: unkown filesystem

Mein Aktuelle Installation sieht so aus:

Proxmox 6.1.8

motioneye (pve), nextcloud (pve) sind einzelne ZFS HDD's

omv (pve) ein ZFS pool aus zwei HDD's

Code:

lsblk -f

NAME FSTYPE LABEL UUID FSAVAIL FSUSE% MOUNTPOI NT

sda

├─sda1

│

├─sda2

│ vfat BD8B-913C

└─sda3

LVM2_m AlzIN1-zwCK-qlQc-e1JA-SXjQ-SBXP-zaBi32

├─pve-swap

│ swap 4ef548a3-e334-460c-ac1c-5aae53f2bdf4 [SWAP]

├─pve-root

│ ext4 d9e280af-6fa1-4422-9776-1c2750538a1f 3G 84% /

├─pve-data_tmeta

│

│ └─pve-data-tpool

│

│ ├─pve-data

│ │

│ ├─pve-vm--101--disk--0

│ │ ext4 94c605d9-52d9-4bee-919c-e0154a00f6ad

│ ├─pve-vm--103--disk--0

│ │ ext4 05a2bda1-b725-4036-ab0c-05857e62d21a

│ ├─pve-vm--105--disk--0

│ │

│ ├─pve-vm--100--disk--0

│ │ ext4 e09ce78b-c2c7-4f2b-aece-e885fa3adb30

│ ├─pve-vm--104--disk--0

│ │ ext4 6fac9ae7-efbe-4018-a5e8-4960d1de68b2

│ └─pve-vm--102--disk--0

│

└─pve-data_tdata

└─pve-data-tpool

├─pve-data

│

├─pve-vm--101--disk--0

│ ext4 94c605d9-52d9-4bee-919c-e0154a00f6ad

├─pve-vm--103--disk--0

│ ext4 05a2bda1-b725-4036-ab0c-05857e62d21a

├─pve-vm--105--disk--0

│

├─pve-vm--100--disk--0

│ ext4 e09ce78b-c2c7-4f2b-aece-e885fa3adb30

├─pve-vm--104--disk--0

│ ext4 6fac9ae7-efbe-4018-a5e8-4960d1de68b2

└─pve-vm--102--disk--0

sdb

├─sdb1

│ zfs_me omv 17276545645704761212

└─sdb9

sdc

├─sdc1

│ zfs_me omv 17276545645704761212

└─sdc9

sdd

├─sdd1

│ zfs_me motioneye

│ 10652509401441743766

└─sdd9

sde

├─sde1

│ zfs_me nextcloud

│ 4144683045819838609

└─sde9

sdf

└─sdf1

vfat 2736-60C3

zd0

└─zd0p1

ext4 data 55daa547-2c9e-416e-b961-afceb10b9b5b

root@pve:~#Alle VM's und Container habe ich gesichert.

Wenn ich auf der neuen 1TB SSD Proxmox neu installiere kann ich die HDD's nicht hinzufügen da Sie mir nicht als Verfügbar angezeigt werden.

Geht das erst nachdem ich die VM's/Container wieder hergestellt habe?

Wie sieht die einfachste oder beste Vorgehensweise aus um den Umzug zu bewerkstelligen?

Danke für eure Hilfe

Last edited: