Hi,

Ich habe bei einer VM direkt ein EXT4-FS auf einem Blockdevice. Dieses sichere ich per PBS.

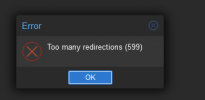

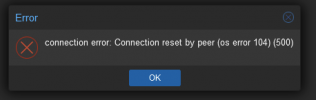

Filerestore scheint nicht zu funktionieren, lädt ewig und wirft dann manchmal einen Timeout.

Kann es sein, dass der proxmox-restore-daemon der mini-VM nicht mit der Konstellation klarkommt? (keine Partitiontable)

Oder mag das am großen Blockdevice liegen? (~40TB)

Gruß

Stephan

Ich habe bei einer VM direkt ein EXT4-FS auf einem Blockdevice. Dieses sichere ich per PBS.

Filerestore scheint nicht zu funktionieren, lädt ewig und wirft dann manchmal einen Timeout.

Kann es sein, dass der proxmox-restore-daemon der mini-VM nicht mit der Konstellation klarkommt? (keine Partitiontable)

Oder mag das am großen Blockdevice liegen? (~40TB)

Gruß

Stephan