Hallo,

Ich hätte Fragen wegen der richtigen Hardware für meine Anwendung.

Vielleicht können wir hier erfahrene User weiterhelfen.

Vorhaben.

3-4 Ubuntu Desktop VM,s auf Proxmox.

2 davon sollen dauerhaft im Betrieb sein die anderen sind zum testen.

Es geht Hauptsächlich um Homeautomation.

Ich hätte jetzt einen Intel NUC Pro 11 oder 12 ins Auge gefasst.

Die Frage ist nur, reicht hier ein i3 mit 4 Kernen oder muss ein i5 mit 8 Kernen her? Preislich ist da schon ein enormer unterschied.

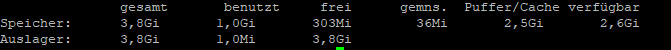

RAM hätte ich dem Nuc 32 GB gegönnt.

Und natürlich eine schnelle M.2.

Was meint ihr dazu?

Danke schon mal....

Ich hätte Fragen wegen der richtigen Hardware für meine Anwendung.

Vielleicht können wir hier erfahrene User weiterhelfen.

Vorhaben.

3-4 Ubuntu Desktop VM,s auf Proxmox.

2 davon sollen dauerhaft im Betrieb sein die anderen sind zum testen.

Es geht Hauptsächlich um Homeautomation.

Ich hätte jetzt einen Intel NUC Pro 11 oder 12 ins Auge gefasst.

Die Frage ist nur, reicht hier ein i3 mit 4 Kernen oder muss ein i5 mit 8 Kernen her? Preislich ist da schon ein enormer unterschied.

RAM hätte ich dem Nuc 32 GB gegönnt.

Und natürlich eine schnelle M.2.

Was meint ihr dazu?

Danke schon mal....