Klar.

Den Pfad zu dm-1 musst Du selber rausfinden, sollte in /etc/fstab stehen.

fsck.ext4 /dev/mapper/dm-1Den Pfad zu dm-1 musst Du selber rausfinden, sollte in /etc/fstab stehen.

fsck.ext4 /dev/mapper/dm-1

smartctl -x -q noserial /dev/nvmeX <- gerne als .txt im AnhangAlso wenn die Server und NVMes brandneu sind, dann ist das tatsächlich unwahrscheinlich (aber nicht unmöglich!), dass hardwaretechnisch was kaputt ist.

Interessant wäre daher ein Blick auf die SMART-Werte, die sind nicht immer eindeutig interpretierbar in kaputt/nicht kaputt.

smartctl -x -q noserial /dev/nvmeX<- gerne als .txt im Anhang

Falls das keinen Aufschluss bringt, wäre ich geneigt zu sagen, dass du den zickigen Server runterfährst und alle Netzwerkkabel trennst (damit auch bei versehentlichem reboot kein traffic mehr davon zum Cluster kommt, das ist wichtig!). Dann seinen Eintrag aus dem Cluster raus (von den anderen Nodes aus wird das gemacht).

In Ruhe lesen, auf Details achten, die Prozedur in Gänze verstehen und nicht in Panik einfach drauf loslegen:

https://pve.proxmox.com/wiki/Cluster_Manager#_remove_a_cluster_nodeI have 2 PVE nodes that I would like to setup as a cluster, however both have configured clusters and I can't figure out how to remove the cluster from one to join the other.

- taurolyon

- Replies: 24

- Forum: Proxmox VE: Installation and configuration

https://www.thomas-krenn.com/de/wiki/Proxmox_Node_aus_Cluster_entfernen_und_erneut_hinzufügen

Den betroffenen Server dann erst wieder ans Netzwerk anschließen, wenn er frisch installiert ist. Den gleichen Namen und die IPs geht dann auch klar.

Nicht schlimm. Hab nur explizit bei der SSD nen fw-bug vermutet, aber ich war in der Zeile verrutscht für dein Modell.wo zwei Firmeware Updates dabei waren. Leider weiss ich aktuell nicht wovon.

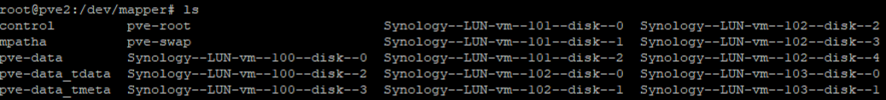

Mag sein, aber in dem screenshot von #15 sagts ja, dass nur noch read only gemountet ist. Das heißt auf jeden Fall, dass zum einen die Daten auf der Platte nicht (mehr?) konsistent sind (das ext4 ist auf jeden Fall als hinüber zu betrachten) und zum anderen corosync auf jeden Fall auch nicht mehr konsistent ist, weil ja nicht geschrieben werden konnte.Bisher ist der Rechner auch immer noch drinnen.

Mit irgendeiner live linux bootcd geht's schon !!Wenn das live nicht fixbar ist und mit ner bootcd auch nicht...tzja

Kann nächsten Montag wieder hin. Das wäre sowieso erst einmal der erste WegOk, dann würde ich raten, es doch nochmal penibel mit der live cd zu versuchen.

We use essential cookies to make this site work, and optional cookies to enhance your experience.