Hi zusammen,

ich habe meine pve7 heute neu aufgesetzt (Debian 10.10 installiert, auf 11 geupgraded und danach pve7 installiert.

Dann lud ich meine Backups hoch und stellte sie local wieder her.

Im Anschluss habe ich sie dann die Laufwerke auf einen SibgleDisk ZFS "verschoben".

Mich haben schon Fehler in den VMs und Containern (wenn ich auf die Console Switch gewundert:

Dann ging nichts mehr, als ich die herunterfahren wollte und habe den Server hard Rosetten müssen.

Seitdem kommt die Kiste nicht mehr hoch und das ist der letzte Eintrag im Syslog:

Habt Ihr eine Idee, was da los ist?

Per rescue System kann ich noch zugreifen, das wars dann allerdings.

Danke Euch und viele Grüße

Tardar

ich habe meine pve7 heute neu aufgesetzt (Debian 10.10 installiert, auf 11 geupgraded und danach pve7 installiert.

Dann lud ich meine Backups hoch und stellte sie local wieder her.

Im Anschluss habe ich sie dann die Laufwerke auf einen SibgleDisk ZFS "verschoben".

Mich haben schon Fehler in den VMs und Containern (wenn ich auf die Console Switch gewundert:

Dann ging nichts mehr, als ich die herunterfahren wollte und habe den Server hard Rosetten müssen.

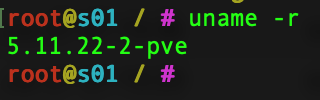

Seitdem kommt die Kiste nicht mehr hoch und das ist der letzte Eintrag im Syslog:

Code:

Jul 25 23:33:28 s01 kernel: [ 7251.471974] INFO: task systemd-udevd:418 blocked for more than 120 seconds.

Jul 25 23:33:28 s01 kernel: [ 7251.472071] Tainted: P IO 5.11.22-2-pve #1

Jul 25 23:33:28 s01 kernel: [ 7251.472149] "echo 0 > /proc/sys/kernel/hung_task_timeout_secs" disables this message.

Jul 25 23:33:28 s01 kernel: [ 7251.472243] task:systemd-udevd state:D stack: 0 pid: 418 ppid: 1 flags:0x00000224

Jul 25 23:33:28 s01 kernel: [ 7251.472340] Call Trace:

Jul 25 23:33:28 s01 kernel: [ 7251.472425] ? usleep_range+0x90/0x90

Jul 25 23:33:28 s01 kernel: [ 7251.472503] __schedule+0x2ca/0x880

Jul 25 23:33:28 s01 kernel: [ 7251.472578] ? usleep_range+0x90/0x90

Jul 25 23:33:28 s01 kernel: [ 7251.472665] schedule+0x4f/0xc0

Jul 25 23:33:28 s01 kernel: [ 7251.472750] schedule_timeout+0xfe/0x140

Jul 25 23:33:28 s01 kernel: [ 7251.472836] ? try_to_wake_up+0x257/0x5c0

Jul 25 23:33:28 s01 kernel: [ 7251.472923] __wait_for_common+0xb2/0x150

Jul 25 23:33:28 s01 kernel: [ 7251.473021] wait_for_completion+0x24/0x30

Jul 25 23:33:28 s01 kernel: [ 7251.473119] __flush_work.isra.0+0x58/0x70

Jul 25 23:33:28 s01 kernel: [ 7251.473220] ? worker_detach_from_pool+0xc0/0xc0

Jul 25 23:33:28 s01 kernel: [ 7251.473309] __cancel_work_timer+0x109/0x190

Jul 25 23:33:28 s01 kernel: [ 7251.473420] ? find_inode_fast+0x59/0xc0

Jul 25 23:33:28 s01 kernel: [ 7251.473495] cancel_delayed_work_sync+0x13/0x20

Jul 25 23:33:28 s01 kernel: [ 7251.473571] disk_block_events+0x78/0x80

Jul 25 23:33:28 s01 kernel: [ 7251.473661] blkdev_get_by_dev+0x10e/0x230

Jul 25 23:33:28 s01 kernel: [ 7251.473752] ? blkdev_get_by_dev+0x230/0x230

Jul 25 23:33:28 s01 kernel: [ 7251.473833] blkdev_open+0x50/0x90

Jul 25 23:33:28 s01 kernel: [ 7251.473908] do_dentry_open+0x156/0x370

Jul 25 23:33:28 s01 kernel: [ 7251.473985] vfs_open+0x2d/0x30

Jul 25 23:33:28 s01 kernel: [ 7251.474060] path_openat+0xa79/0x10d0

Jul 25 23:33:28 s01 kernel: [ 7251.474137] ? putname+0x4c/0x60

Jul 25 23:33:28 s01 kernel: [ 7251.474225] ? putname+0x4c/0x60

Jul 25 23:33:28 s01 kernel: [ 7251.474299] do_filp_open+0x8c/0x130

Jul 25 23:33:28 s01 kernel: [ 7251.474378] ? __check_object_size+0x13f/0x150

Jul 25 23:33:28 s01 kernel: [ 7251.474471] do_sys_openat2+0x9b/0x150

Jul 25 23:33:28 s01 kernel: [ 7251.474548] __x64_sys_openat+0x56/0x90

Jul 25 23:33:28 s01 kernel: [ 7251.474636] do_syscall_64+0x38/0x90

Jul 25 23:33:28 s01 kernel: [ 7251.476627] entry_SYSCALL_64_after_hwframe+0x44/0xa9

Jul 25 23:33:28 s01 kernel: [ 7251.476730] RIP: 0033:0x7f3b23422767

Jul 25 23:33:28 s01 kernel: [ 7251.476817] RSP: 002b:00007ffca4bfef70 EFLAGS: 00000246 ORIG_RAX: 0000000000000101

Jul 25 23:33:28 s01 kernel: [ 7251.476912] RAX: ffffffffffffffda RBX: 00007ffca4bff070 RCX: 00007f3b23422767

Jul 25 23:33:28 s01 kernel: [ 7251.476993] RDX: 00000000000a0800 RSI: 0000560ad7844970 RDI: 00000000ffffff9c

Jul 25 23:33:28 s01 kernel: [ 7251.477073] RBP: 0000560ad7844970 R08: 0000560ad6079540 R09: 0000560ad784fc09

Jul 25 23:33:28 s01 kernel: [ 7251.477154] R10: 0000000000000000 R11: 0000000000000246 R12: 00000000000a0800

Jul 25 23:33:28 s01 kernel: [ 7251.477234] R13: 0000560ad607989f R14: 00007ffca4bff040 R15: 0000560ad7865630

Jul 25 23:33:28 s01 kernel: [ 7251.477346] INFO: task kworker/u16:7:327556 blocked for more than 120 seconds.

Jul 25 23:33:28 s01 kernel: [ 7251.477440] Tainted: P IO 5.11.22-2-pve #1

Jul 25 23:33:28 s01 kernel: [ 7251.477529] "echo 0 > /proc/sys/kernel/hung_task_timeout_secs" disables this message.

Jul 25 23:33:28 s01 kernel: [ 7251.477623] task:kworker/u16:7 state:D stack: 0 pid:327556 ppid: 2 flags:0x00004000

Jul 25 23:33:28 s01 kernel: [ 7251.477719] Workqueue: events_freezable_power_ disk_events_workfn

Jul 25 23:33:28 s01 kernel: [ 7251.477800] Call Trace:

Jul 25 23:33:28 s01 kernel: [ 7251.477872] __schedule+0x2ca/0x880

Jul 25 23:33:28 s01 kernel: [ 7251.477947] schedule+0x4f/0xc0

Jul 25 23:33:28 s01 kernel: [ 7251.478021] schedule_preempt_disabled+0xe/0x10

Jul 25 23:33:28 s01 kernel: [ 7251.478097] __mutex_lock.constprop.0+0x309/0x4d0

Jul 25 23:33:28 s01 kernel: [ 7251.478174] __mutex_lock_slowpath+0x13/0x20

Jul 25 23:33:28 s01 kernel: [ 7251.478251] mutex_lock+0x34/0x40

Jul 25 23:33:28 s01 kernel: [ 7251.478326] zvol_check_events+0x3e/0xe0 [zfs]

Jul 25 23:33:28 s01 kernel: [ 7251.478523] disk_check_events+0x63/0x180

Jul 25 23:33:28 s01 kernel: [ 7251.478599] disk_events_workfn+0x19/0x20

Jul 25 23:33:28 s01 kernel: [ 7251.478686] process_one_work+0x220/0x3c0

Jul 25 23:33:28 s01 kernel: [ 7251.478762] worker_thread+0x53/0x420

Jul 25 23:33:28 s01 kernel: [ 7251.478851] kthread+0x12f/0x150

Jul 25 23:33:28 s01 kernel: [ 7251.478926] ? process_one_work+0x3c0/0x3c0

Jul 25 23:33:28 s01 kernel: [ 7251.479004] ? __kthread_bind_mask+0x70/0x70

Jul 25 23:33:28 s01 kernel: [ 7251.479080] ret_from_fork+0x22/0x30

Jul 25 23:33:28 s01 kernel: [ 7251.479179] INFO: task kvm:261318 blocked for more than 120 seconds.

Jul 25 23:33:28 s01 kernel: [ 7251.479258] Tainted: P IO 5.11.22-2-pve #1

Jul 25 23:33:28 s01 kernel: [ 7251.479336] "echo 0 > /proc/sys/kernel/hung_task_timeout_secs" disables this message.

Jul 25 23:33:28 s01 kernel: [ 7251.479430] task:kvm state:D stack: 0 pid:261318 ppid: 1 flags:0x00000000

Jul 25 23:33:28 s01 kernel: [ 7251.479540] Call Trace:

Jul 25 23:33:28 s01 kernel: [ 7251.479612] __schedule+0x2ca/0x880

Jul 25 23:33:28 s01 kernel: [ 7251.479687] schedule+0x4f/0xc0

Jul 25 23:33:28 s01 kernel: [ 7251.479761] schedule_preempt_disabled+0xe/0x10

Jul 25 23:33:28 s01 kernel: [ 7251.479838] __mutex_lock.constprop.0+0x309/0x4d0

Jul 25 23:33:28 s01 kernel: [ 7251.479915] __mutex_lock_slowpath+0x13/0x20

Jul 25 23:33:28 s01 kernel: [ 7251.479996] mutex_lock+0x34/0x40

Jul 25 23:33:28 s01 kernel: [ 7251.480073] disk_block_events+0x31/0x80

Jul 25 23:33:28 s01 kernel: [ 7251.480148] blkdev_get_by_dev+0x10e/0x230

Jul 25 23:33:28 s01 kernel: [ 7251.480225] ? blkdev_get_by_dev+0x230/0x230

Jul 25 23:33:28 s01 kernel: [ 7251.480301] blkdev_open+0x50/0x90

Jul 25 23:33:28 s01 kernel: [ 7251.480375] do_dentry_open+0x156/0x370

Jul 25 23:33:28 s01 kernel: [ 7251.480451] vfs_open+0x2d/0x30

Jul 25 23:33:28 s01 kernel: [ 7251.480525] path_openat+0xa79/0x10d0

Jul 25 23:33:28 s01 kernel: [ 7251.480600] ? unlock_page_memcg+0x38/0x70

Jul 25 23:33:28 s01 kernel: [ 7251.480676] ? page_add_file_rmap+0xd3/0x140

Jul 25 23:33:28 s01 kernel: [ 7251.480754] do_filp_open+0x8c/0x130

Jul 25 23:33:28 s01 kernel: [ 7251.480829] do_sys_openat2+0x9b/0x150

Jul 25 23:33:28 s01 kernel: [ 7251.480903] __x64_sys_openat+0x56/0x90

Jul 25 23:33:28 s01 kernel: [ 7251.480979] do_syscall_64+0x38/0x90

Jul 25 23:33:28 s01 kernel: [ 7251.481053] entry_SYSCALL_64_after_hwframe+0x44/0xa9

Jul 25 23:33:28 s01 kernel: [ 7251.481132] RIP: 0033:0x7f6bb05ab7e4

Jul 25 23:33:28 s01 kernel: [ 7251.481206] RSP: 002b:00007fffc9a59b60 EFLAGS: 00000293 ORIG_RAX: 0000000000000101

Jul 25 23:33:28 s01 kernel: [ 7251.481300] RAX: ffffffffffffffda RBX: 00005577c62c6610 RCX: 00007f6bb05ab7e4

Jul 25 23:33:28 s01 kernel: [ 7251.481381] RDX: 0000000000080800 RSI: 00005577c62c6610 RDI: 00000000ffffff9c

Jul 25 23:33:28 s01 kernel: [ 7251.481461] RBP: 00005577c62c6610 R08: 0000000000000000 R09: 00007f6bb0591be0

Jul 25 23:33:28 s01 kernel: [ 7251.481542] R10: 0000000000000000 R11: 0000000000000293 R12: 0000000000080800

Jul 25 23:33:28 s01 kernel: [ 7251.481622] R13: 0000000000000000 R14: 0000000000000000 R15: 00005577c62c6610Habt Ihr eine Idee, was da los ist?

Per rescue System kann ich noch zugreifen, das wars dann allerdings.

Danke Euch und viele Grüße

Tardar