Ich hoffe das ich hier jemanden finde der vielleicht ähnliche Probleme hatte damit.

Ich betreibe ein 2 Node Cluster mit einem Q-Device (als vollwertigen Server aber ohne Storage-Anbindung, also nur als Entscheidungsgeber). Nun habe ich auf einem Knoten eine Linux VM laufen die für die Arbeit in unserer IT-Abteilung wichtig ist. Das Problem hierbei ist, dass die Browserseiten manchmal extrem schnell laden und im nächsten Moment ca. 1-2 Minuten brauchen um sich aufzubauen.

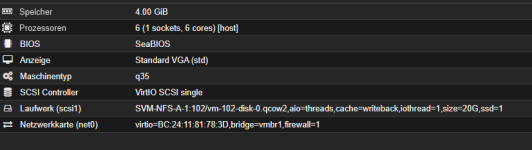

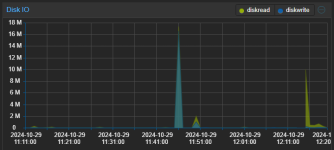

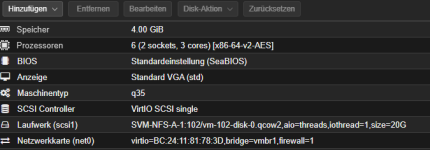

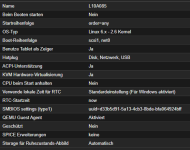

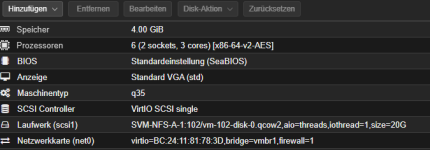

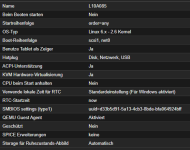

Ich weiß nicht ob ich in der Konfiguration irgendwas falsch gemacht habe oder was da die gängige Praxis ist (siehe Bilder), aber die Performance ist halt eben nicht so geil.

Hab bevor ich die VM migriert habe alles an Anforderungen bei VMware abgecheckt, die VM funktioniert auch ohne Schwierigkeiten. Auch die Qemu Gasttreiber habe ich installiert.

Die beiden Nodes sind mit dem NFS-Storage angebunden.

Für jede Hilfe bin ich sehr dankbar!

Ich betreibe ein 2 Node Cluster mit einem Q-Device (als vollwertigen Server aber ohne Storage-Anbindung, also nur als Entscheidungsgeber). Nun habe ich auf einem Knoten eine Linux VM laufen die für die Arbeit in unserer IT-Abteilung wichtig ist. Das Problem hierbei ist, dass die Browserseiten manchmal extrem schnell laden und im nächsten Moment ca. 1-2 Minuten brauchen um sich aufzubauen.

Ich weiß nicht ob ich in der Konfiguration irgendwas falsch gemacht habe oder was da die gängige Praxis ist (siehe Bilder), aber die Performance ist halt eben nicht so geil.

Hab bevor ich die VM migriert habe alles an Anforderungen bei VMware abgecheckt, die VM funktioniert auch ohne Schwierigkeiten. Auch die Qemu Gasttreiber habe ich installiert.

Die beiden Nodes sind mit dem NFS-Storage angebunden.

Für jede Hilfe bin ich sehr dankbar!