Hallo zusammen und einen schönen Sonntag Abend,

gleich mal eine Vorwarnung: Viel Text und ich glaube nicht gut strukturiert, ich versuche am Ende des Textes die Fragen noch mal kurz und bündig zusammen zu fassen.

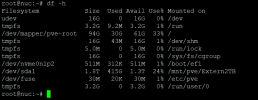

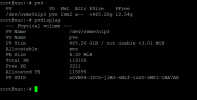

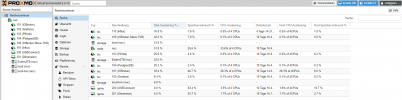

Ich packe mal eine ganze Menge Screenshots mit dazu, in der Hoffnung ihr könnt euch ein Gesamtbild über mein Problem machen.

Ich habe seit ein paar Wochen bereits Probleme mit meinem Proxmox bzw. dem LVM „Verzeichnis“.

Leider sind meine Linux Kenntnisse Grundsätzlich eher schlecht und als klassischer Windows Admin verstehe ich das Konstrukt „LVM“ glaube ich immer noch nicht ganz.

Ich habe 2 Festplatten in einem Intel NUC welcher via Proxmox 6.4-13 in Betrieb. Eine interne 500GB SSD und eine 2 TB HDD extern angeschlossen.

Auf die Interne SSD habe ich damals das vorgefertigte Proxmox Image aufgebracht, leider ohne mich weiter mit den Grundlagen zu beschäftigen. Die 2 TB HDD ist ext4 formatiert. Auf dieser laufen mittlerweile VMs, CTs und es werden Backups dort abgelegt.

Die lokale SSD sollte primär für VMs und CTs verwendet werden, dies war auch so, bis es zu meinem „Problem“ kam.

Nun ist es so, dass der LVM „Ordner“ zu 97% gefüllt ist, und ich dort nicht freigeben kann, egal wo ich VMs / CTs hin verschiebe oder wie ich diese einbinde. Als ich das „Problem“ bekommen habe warn im LVM 11x LV abgelegt und angezeigt.

Diese habe ich mittlerweile aufgeräumt, bereinigt und unnötiges weggelöscht. Mittlerweile bin ich bei 7x LV im LVM „Verzeichnis“ jedoch wurde keine bisschen Kapazität frei gegeben.

Dies führt dazu das die Backups meiner größeren Datenbankmaschinen (Influx & Prostgre) leider fehlschlagen.

Die würde ich gerne schnellstmöglich beheben. Und auch das Datenablagekonstrukt aufräumen und richtig gestalten.

Hierbei bekomme ich folgende Meldung beim automatischen Job:

INFO: starting new backup job: vzdump 100 --node nuc --compress gzip --remove 0 --mode snapshot --storage Extern2TB

INFO: Starting Backup of VM 100 (lxc)

INFO: Backup started at 2021-12-31 11:42:19

INFO: status = running

INFO: CT Name: Influxdb

INFO: including mount point rootfs ('/') in backup

INFO: backup mode: snapshot

INFO: ionice priority: 7

INFO: create storage snapshot 'vzdump'

WARNING: You have not turned on protection against thin pools running out of space.

WARNING: Set activation/thin_pool_autoextend_threshold below 100 to trigger automatic extension of thin pools before they get full.

Logical volume "snap_vm-100-disk-0_vzdump" created.

WARNING: Sum of all thin volume sizes (394.00 GiB) exceeds the size of thin pool pve/data and the amount of free space in volume group (12.54 GiB).

INFO: creating vzdump archive '/mnt/pve/Extern2TB/dump/vzdump-lxc-100-2021_12_31-11_42_19.tar.gz'

INFO: tar: ./var/cache/man/ru/cat8/: Cannot savedir: Bad message

INFO: Total bytes written: 65421742080 (61GiB, 33MiB/s)

INFO: tar: Exiting with failure status due to previous errors

INFO: cleanup temporary 'vzdump' snapshot

Logical volume "snap_vm-100-disk-0_vzdump" successfully removed

ERROR: Backup of VM 100 failed - command 'set -o pipefail && tar cpf - --totals --one-file-system -p --sparse --numeric-owner --acls --xattrs '--xattrs-include=user.*' '--xattrs-include=security.capability' '--warning=no-file-ignored' '--warning=no-xattr-write' --one-file-system '--warning=no-file-ignored' '--directory=/mnt/pve/Extern2TB/dump/vzdump-lxc-100-2021_12_31-11_42_19.tmp' ./etc/vzdump/pct.conf ./etc/vzdump/pct.fw '--directory=/mnt/vzsnap0' --no-anchored '--exclude=lost+found' --anchored '--exclude=./tmp/?*' '--exclude=./var/tmp/?*' '--exclude=./var/run/?*.pid' ./ | gzip --rsyncable >/mnt/pve/Extern2TB/dump/vzdump-lxc-100-2021_12_31-11_42_19.tar.dat' failed: exit code 2

INFO: Failed at 2021-12-31 12:14:28

INFO: Backup job finished with errors

TASK ERROR: job errors

Oder diese Meldungen wenn ich manuell Starte:

INFO: starting new backup job: vzdump 100 --remove 0 --mode snapshot --storage Extern2TB --node nuc --compress gzip --mailto abc@edf.com

INFO: Starting Backup of VM 100 (lxc)

INFO: Backup started at 2022-01-16 18:27:47

INFO: status = running

INFO: CT Name: InfluxDB2022

INFO: including mount point rootfs ('/') in backup

INFO: backup mode: snapshot

INFO: ionice priority: 7

INFO: create storage snapshot 'vzdump'

Logical volume "snap_vm-100-disk-0_vzdump" created.

INFO: creating vzdump archive '/mnt/pve/Extern2TB/dump/vzdump-lxc-100-2022_01_16-18_27_47.tar.gz'

INFO: tar: ./var/cache/man/ru/cat8/: Cannot savedir: Bad message

INFO: Total bytes written: 80549959680 (76GiB, 36MiB/s)

INFO: tar: Exiting with failure status due to previous errors

INFO: cleanup temporary 'vzdump' snapshot

Logical volume "snap_vm-100-disk-0_vzdump" successfully removed

ERROR: Backup of VM 100 failed - command 'set -o pipefail && tar cpf - --totals --one-file-system -p --sparse --numeric-owner --acls --xattrs '--xattrs-include=user.*' '--xattrs-include=security.capability' '--warning=no-file-ignored' '--warning=no-xattr-write' --one-file-system '--warning=no-file-ignored' '--directory=/mnt/pve/Extern2TB/dump/vzdump-lxc-100-2022_01_16-18_27_47.tmp' ./etc/vzdump/pct.conf ./etc/vzdump/pct.fw '--directory=/mnt/vzsnap0' --no-anchored '--exclude=lost+found' --anchored '--exclude=./tmp/?*' '--exclude=./var/tmp/?*' '--exclude=./var/run/?*.pid' ./ | gzip --rsyncable >/mnt/pve/Extern2TB/dump/vzdump-lxc-100-2022_01_16-18_27_47.tar.dat' failed: exit code 2

INFO: Failed at 2022-01-16 19:04:05

INFO: Backup job finished with errors

TASK ERROR: job errors

Nachdem ich den CT dann auf die Externe Platte gelegt hatte, bekam ich folgende Fehlermeldungen welche vermutlich darauf hindeuten das Snapshots auf ext4 nicht klappen, hier habe ich noch nicht weiter gelesen da ich dies auch eigentlich wieder auf der lokalen SSD haben möchte.

Detailed backup logs:

vzdump 110 --compress gzip --remove 0 --storage Extern2TB --mode snapshot --node nuc --mailto …

110: 2022-01-16 14:55:51 INFO: Starting Backup of VM 110 (lxc)

110: 2022-01-16 14:55:51 INFO: status = running

110: 2022-01-16 14:55:51 INFO: CT Name: influx

110: 2022-01-16 14:55:51 INFO: including mount point rootfs ('/') in backup

110: 2022-01-16 14:55:51 INFO: mode failure - some volumes do not support snapshots

110: 2022-01-16 14:55:51 INFO: trying 'suspend' mode instead

110: 2022-01-16 14:55:51 INFO: backup mode: suspend

110: 2022-01-16 14:55:51 INFO: ionice priority: 7

110: 2022-01-16 14:55:51 INFO: CT Name: influx

110: 2022-01-16 14:55:51 INFO: including mount point rootfs ('/') in backup

110: 2022-01-16 14:55:51 INFO: starting first sync /proc/12295/root/ to /mnt/pve/Extern2TB/dump/vzdump-lxc-110-2022_01_16-14_55_51.tmp

110: 2022-01-16 15:31:05 ERROR: Backup of VM 110 failed - command 'rsync --stats -h -X -A --numeric-ids -aH --delete --no-whole-file --sparse --one-file-system --relative '--exclude=/tmp/?*' '--exclude=/var/tmp/?*' '--exclude=/var/run/?*.pid' /proc/12295/root//./ /mnt/pve/Extern2TB/dump/vzdump-lxc-110-2022_01_16-14_55_51.tmp' failed: exit code 23

Meinem Verständnis nach ist LVM also ein Virtuelles / Logisches Verzeichnis welches eine Größe von 500GB fassen kann. Diese sind aufgrund der LV welche mir unter „lvdisplay“ angezeigt werden offenbar voll obwohl keine der Festplatten voll ist (Zumindest meinem Verständnis nach). Daher scheitern aber meine Backups und ich kann das nicht ohne weiteres bereinigen.

Nach meinen Recherchen wäre es nun möglich das LVM zu vergrößern auf z.B. 1TB, und die Images der CTs/VMs einfach weiter manuell zu verteilen. Da es nur virtuell ist kann ich die Platten weiter „ausgewogen“ belasten und befüllen. Ist das so richtig? Ich lese überall, wenn ich das LVM nun über 2 Festplatten erstrecke und auf z.B. 1TB festlege würde Proxmox entscheiden wo es was ablegt. Verliert man da nicht völlig den überblick und die Kontrolle?

So nun noch mal der Versuch das ganze in kurz und knapp:

Ich hoffe jemand hat Zeit und Lust das zu lesen und mich zu unterstützen.

Wenn mehr Informationen benötigt werden, liefere ich diese natürliche gerne nach. Auch könnte man sich gern via Discord / Fernwartung austauschen.

Vielen Dank bis hier her & viele Grüße

Alexander

gleich mal eine Vorwarnung: Viel Text und ich glaube nicht gut strukturiert, ich versuche am Ende des Textes die Fragen noch mal kurz und bündig zusammen zu fassen.

Ich packe mal eine ganze Menge Screenshots mit dazu, in der Hoffnung ihr könnt euch ein Gesamtbild über mein Problem machen.

Ich habe seit ein paar Wochen bereits Probleme mit meinem Proxmox bzw. dem LVM „Verzeichnis“.

Leider sind meine Linux Kenntnisse Grundsätzlich eher schlecht und als klassischer Windows Admin verstehe ich das Konstrukt „LVM“ glaube ich immer noch nicht ganz.

Ich habe 2 Festplatten in einem Intel NUC welcher via Proxmox 6.4-13 in Betrieb. Eine interne 500GB SSD und eine 2 TB HDD extern angeschlossen.

Auf die Interne SSD habe ich damals das vorgefertigte Proxmox Image aufgebracht, leider ohne mich weiter mit den Grundlagen zu beschäftigen. Die 2 TB HDD ist ext4 formatiert. Auf dieser laufen mittlerweile VMs, CTs und es werden Backups dort abgelegt.

Die lokale SSD sollte primär für VMs und CTs verwendet werden, dies war auch so, bis es zu meinem „Problem“ kam.

Nun ist es so, dass der LVM „Ordner“ zu 97% gefüllt ist, und ich dort nicht freigeben kann, egal wo ich VMs / CTs hin verschiebe oder wie ich diese einbinde. Als ich das „Problem“ bekommen habe warn im LVM 11x LV abgelegt und angezeigt.

Diese habe ich mittlerweile aufgeräumt, bereinigt und unnötiges weggelöscht. Mittlerweile bin ich bei 7x LV im LVM „Verzeichnis“ jedoch wurde keine bisschen Kapazität frei gegeben.

Dies führt dazu das die Backups meiner größeren Datenbankmaschinen (Influx & Prostgre) leider fehlschlagen.

Die würde ich gerne schnellstmöglich beheben. Und auch das Datenablagekonstrukt aufräumen und richtig gestalten.

Hierbei bekomme ich folgende Meldung beim automatischen Job:

INFO: starting new backup job: vzdump 100 --node nuc --compress gzip --remove 0 --mode snapshot --storage Extern2TB

INFO: Starting Backup of VM 100 (lxc)

INFO: Backup started at 2021-12-31 11:42:19

INFO: status = running

INFO: CT Name: Influxdb

INFO: including mount point rootfs ('/') in backup

INFO: backup mode: snapshot

INFO: ionice priority: 7

INFO: create storage snapshot 'vzdump'

WARNING: You have not turned on protection against thin pools running out of space.

WARNING: Set activation/thin_pool_autoextend_threshold below 100 to trigger automatic extension of thin pools before they get full.

Logical volume "snap_vm-100-disk-0_vzdump" created.

WARNING: Sum of all thin volume sizes (394.00 GiB) exceeds the size of thin pool pve/data and the amount of free space in volume group (12.54 GiB).

INFO: creating vzdump archive '/mnt/pve/Extern2TB/dump/vzdump-lxc-100-2021_12_31-11_42_19.tar.gz'

INFO: tar: ./var/cache/man/ru/cat8/: Cannot savedir: Bad message

INFO: Total bytes written: 65421742080 (61GiB, 33MiB/s)

INFO: tar: Exiting with failure status due to previous errors

INFO: cleanup temporary 'vzdump' snapshot

Logical volume "snap_vm-100-disk-0_vzdump" successfully removed

ERROR: Backup of VM 100 failed - command 'set -o pipefail && tar cpf - --totals --one-file-system -p --sparse --numeric-owner --acls --xattrs '--xattrs-include=user.*' '--xattrs-include=security.capability' '--warning=no-file-ignored' '--warning=no-xattr-write' --one-file-system '--warning=no-file-ignored' '--directory=/mnt/pve/Extern2TB/dump/vzdump-lxc-100-2021_12_31-11_42_19.tmp' ./etc/vzdump/pct.conf ./etc/vzdump/pct.fw '--directory=/mnt/vzsnap0' --no-anchored '--exclude=lost+found' --anchored '--exclude=./tmp/?*' '--exclude=./var/tmp/?*' '--exclude=./var/run/?*.pid' ./ | gzip --rsyncable >/mnt/pve/Extern2TB/dump/vzdump-lxc-100-2021_12_31-11_42_19.tar.dat' failed: exit code 2

INFO: Failed at 2021-12-31 12:14:28

INFO: Backup job finished with errors

TASK ERROR: job errors

Oder diese Meldungen wenn ich manuell Starte:

INFO: starting new backup job: vzdump 100 --remove 0 --mode snapshot --storage Extern2TB --node nuc --compress gzip --mailto abc@edf.com

INFO: Starting Backup of VM 100 (lxc)

INFO: Backup started at 2022-01-16 18:27:47

INFO: status = running

INFO: CT Name: InfluxDB2022

INFO: including mount point rootfs ('/') in backup

INFO: backup mode: snapshot

INFO: ionice priority: 7

INFO: create storage snapshot 'vzdump'

Logical volume "snap_vm-100-disk-0_vzdump" created.

INFO: creating vzdump archive '/mnt/pve/Extern2TB/dump/vzdump-lxc-100-2022_01_16-18_27_47.tar.gz'

INFO: tar: ./var/cache/man/ru/cat8/: Cannot savedir: Bad message

INFO: Total bytes written: 80549959680 (76GiB, 36MiB/s)

INFO: tar: Exiting with failure status due to previous errors

INFO: cleanup temporary 'vzdump' snapshot

Logical volume "snap_vm-100-disk-0_vzdump" successfully removed

ERROR: Backup of VM 100 failed - command 'set -o pipefail && tar cpf - --totals --one-file-system -p --sparse --numeric-owner --acls --xattrs '--xattrs-include=user.*' '--xattrs-include=security.capability' '--warning=no-file-ignored' '--warning=no-xattr-write' --one-file-system '--warning=no-file-ignored' '--directory=/mnt/pve/Extern2TB/dump/vzdump-lxc-100-2022_01_16-18_27_47.tmp' ./etc/vzdump/pct.conf ./etc/vzdump/pct.fw '--directory=/mnt/vzsnap0' --no-anchored '--exclude=lost+found' --anchored '--exclude=./tmp/?*' '--exclude=./var/tmp/?*' '--exclude=./var/run/?*.pid' ./ | gzip --rsyncable >/mnt/pve/Extern2TB/dump/vzdump-lxc-100-2022_01_16-18_27_47.tar.dat' failed: exit code 2

INFO: Failed at 2022-01-16 19:04:05

INFO: Backup job finished with errors

TASK ERROR: job errors

Nachdem ich den CT dann auf die Externe Platte gelegt hatte, bekam ich folgende Fehlermeldungen welche vermutlich darauf hindeuten das Snapshots auf ext4 nicht klappen, hier habe ich noch nicht weiter gelesen da ich dies auch eigentlich wieder auf der lokalen SSD haben möchte.

Detailed backup logs:

vzdump 110 --compress gzip --remove 0 --storage Extern2TB --mode snapshot --node nuc --mailto …

110: 2022-01-16 14:55:51 INFO: Starting Backup of VM 110 (lxc)

110: 2022-01-16 14:55:51 INFO: status = running

110: 2022-01-16 14:55:51 INFO: CT Name: influx

110: 2022-01-16 14:55:51 INFO: including mount point rootfs ('/') in backup

110: 2022-01-16 14:55:51 INFO: mode failure - some volumes do not support snapshots

110: 2022-01-16 14:55:51 INFO: trying 'suspend' mode instead

110: 2022-01-16 14:55:51 INFO: backup mode: suspend

110: 2022-01-16 14:55:51 INFO: ionice priority: 7

110: 2022-01-16 14:55:51 INFO: CT Name: influx

110: 2022-01-16 14:55:51 INFO: including mount point rootfs ('/') in backup

110: 2022-01-16 14:55:51 INFO: starting first sync /proc/12295/root/ to /mnt/pve/Extern2TB/dump/vzdump-lxc-110-2022_01_16-14_55_51.tmp

110: 2022-01-16 15:31:05 ERROR: Backup of VM 110 failed - command 'rsync --stats -h -X -A --numeric-ids -aH --delete --no-whole-file --sparse --one-file-system --relative '--exclude=/tmp/?*' '--exclude=/var/tmp/?*' '--exclude=/var/run/?*.pid' /proc/12295/root//./ /mnt/pve/Extern2TB/dump/vzdump-lxc-110-2022_01_16-14_55_51.tmp' failed: exit code 23

Meinem Verständnis nach ist LVM also ein Virtuelles / Logisches Verzeichnis welches eine Größe von 500GB fassen kann. Diese sind aufgrund der LV welche mir unter „lvdisplay“ angezeigt werden offenbar voll obwohl keine der Festplatten voll ist (Zumindest meinem Verständnis nach). Daher scheitern aber meine Backups und ich kann das nicht ohne weiteres bereinigen.

Nach meinen Recherchen wäre es nun möglich das LVM zu vergrößern auf z.B. 1TB, und die Images der CTs/VMs einfach weiter manuell zu verteilen. Da es nur virtuell ist kann ich die Platten weiter „ausgewogen“ belasten und befüllen. Ist das so richtig? Ich lese überall, wenn ich das LVM nun über 2 Festplatten erstrecke und auf z.B. 1TB festlege würde Proxmox entscheiden wo es was ablegt. Verliert man da nicht völlig den überblick und die Kontrolle?

So nun noch mal der Versuch das ganze in kurz und knapp:

- Ist es möglich bei meinen Festplatten / Partitionssituation das LVM zu vergrößern, um Proxmox inkl. Backup Jobs wieder vollumfänglich nutzen zu können?

- Ist es Sinnvoll den LVM über mehrere (physikalische) Festplatten zu erweitern? Oder sollte ich das Problem anders angehen? Die Kapazitäten auf den Festplatten sind denke ich vorhanden und frei. -Hier bin ich mir nur auch gar nicht ganz sicher

- Sind die Fehler „Cannot savedir: Bad message“ im Backup tatsächlich aufs LVM zurückzuführen oder gibt’s hier noch andere Ansätze für die Fehlersuche?

Ich hoffe jemand hat Zeit und Lust das zu lesen und mich zu unterstützen.

Wenn mehr Informationen benötigt werden, liefere ich diese natürliche gerne nach. Auch könnte man sich gern via Discord / Fernwartung austauschen.

Vielen Dank bis hier her & viele Grüße

Alexander

Attachments

-

df-h.png19.2 KB · Views: 2

df-h.png19.2 KB · Views: 2 -

lsblk.png41.1 KB · Views: 2

lsblk.png41.1 KB · Views: 2 -

lvdisplay-1.png98 KB · Views: 2

lvdisplay-1.png98 KB · Views: 2 -

lvdisplay-2.png40.4 KB · Views: 2

lvdisplay-2.png40.4 KB · Views: 2 -

LVM97.png49.7 KB · Views: 2

LVM97.png49.7 KB · Views: 2 -

pvdisplay.png18.1 KB · Views: 2

pvdisplay.png18.1 KB · Views: 2 -

Storage Ext2TB.png119.6 KB · Views: 2

Storage Ext2TB.png119.6 KB · Views: 2 -

Storage Local.png115.9 KB · Views: 2

Storage Local.png115.9 KB · Views: 2 -

Storage Local-lvm.png119.5 KB · Views: 2

Storage Local-lvm.png119.5 KB · Views: 2 -

Übersicht.png79.8 KB · Views: 2

Übersicht.png79.8 KB · Views: 2

Last edited: