Moin,

ich habe seit ein paar Wochen immer sporadisch, jetzt dauerhaft, Probleme mit dem Backup eines einzigen Containers.

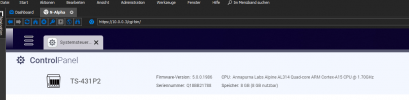

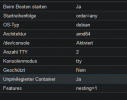

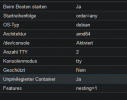

Eigenschaften des Containers:

Debian Container Template

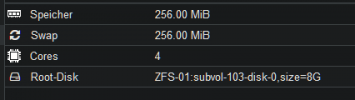

2 Cores

256MB Ram

1 Mount Point mit 8 GB Speicher

2 Netzwerkadapter

Aufgabe: Turn Server (Coturn)

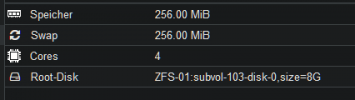

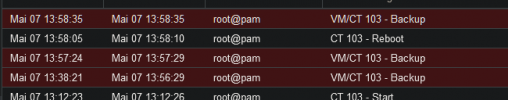

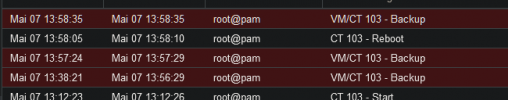

Das hier passiert, wenn ich das Backup ausführen will:

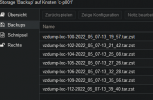

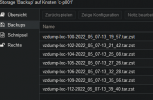

Backup Storage:

Auf dem nas:

Freue mich auf Hinweise.

LG Alex

ich habe seit ein paar Wochen immer sporadisch, jetzt dauerhaft, Probleme mit dem Backup eines einzigen Containers.

Eigenschaften des Containers:

Debian Container Template

2 Cores

256MB Ram

1 Mount Point mit 8 GB Speicher

2 Netzwerkadapter

Aufgabe: Turn Server (Coturn)

Das hier passiert, wenn ich das Backup ausführen will:

Code:

INFO: starting new backup job: vzdump 103 --node c-p001 --prune-backups 'keep-last=2' --notes-template '{{guestname}}' --mode snapshot --all 0 --mailnotification failure --storage Backup --compress zstd

INFO: Starting Backup of VM 103 (lxc)

INFO: Backup started at 2022-05-07 13:58:35

INFO: status = running

INFO: CT Name: turn

INFO: including mount point rootfs ('/') in backup

INFO: backup mode: snapshot

INFO: ionice priority: 7

INFO: create storage snapshot 'vzdump'

INFO: creating vzdump archive '/mnt/pve/Backup/dump/vzdump-lxc-103-2022_05_07-13_58_35.tar.zst'

INFO: tar: /mnt/pve/Backup/dump/vzdump-lxc-103-2022_05_07-13_58_35.tmp: Cannot open: Permission denied

INFO: tar: Error is not recoverable: exiting now

INFO: cleanup temporary 'vzdump' snapshot

ERROR: Backup of VM 103 failed - command 'set -o pipefail && lxc-usernsexec -m u:0:100000:65536 -m g:0:100000:65536 -- tar cpf - --totals --one-file-system -p --sparse --numeric-owner --acls --xattrs '--xattrs-include=user.*' '--xattrs-include=security.capability' '--warning=no-file-ignored' '--warning=no-xattr-write' --one-file-system '--warning=no-file-ignored' '--directory=/mnt/pve/Backup/dump/vzdump-lxc-103-2022_05_07-13_58_35.tmp' ./etc/vzdump/pct.conf ./etc/vzdump/pct.fw '--directory=/mnt/vzsnap0' --no-anchored '--exclude=lost+found' --anchored '--exclude=./tmp/?*' '--exclude=./var/tmp/?*' '--exclude=./var/run/?*.pid' ./ | zstd --rsyncable '--threads=1' >/mnt/pve/Backup/dump/vzdump-lxc-103-2022_05_07-13_58_35.tar.dat' failed: exit code 2

INFO: Failed at 2022-05-07 13:58:35

INFO: Backup job finished with errors

TASK ERROR: job errors

Backup Storage:

Auf dem nas:

Freue mich auf Hinweise.

LG Alex

Last edited: