Hallo Leute,

wir betreiben einen eigenständigen Proxmox-Server mit einer Windows Server 2019 VM, in der BackupExec 20.6 installiert ist.

Die Systemplatte (C: ) der VM liegt auf einem ZFS-Storage mit 2 SSD's (Mirror).

Der Backupspeicher (D: ) liegt ebenfalls auf einem (eigenen) ZFS-Storage mit 2 HDD's (Mirror), die in der Windows-VM eingebunden sind.

Die Tapelibrary (HP) mit 2 Tapedrives wird per PCI-Passthrough (SAS-HBA) ebenfalls in der Windows-VM eingebunden, was soweit auch fehlerfrei funktioniert.

Backup2Disk läuft problemlos (Sicherung von Windows-VM's auf einem Proxmox-Cluster).

Nun passiert beim Kopieren der Backups (2Tape) irgendwann irgendwas und der Backupspeicher ist anscheinend nicht mehr (so richtig) verfügbar. Das kann bei 4GB sein

oder bei 400GB. Das Backup (1,8TB) wird auf jeden Fall nicht abgeschlossen und irgendwann wird der Plattenspeicher wg. EA-Fehlern von BackupExec "offline" geschaltet.

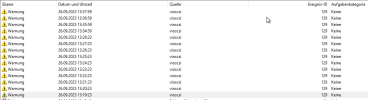

In der Ereignissanzeige sind dann unzählige Fehler zu finden.

Es fängt an mit (minütlich):

vioscsi 129 Ein Zurücksetzen auf Gerät "\Device\RaidPort2" wurde ausgegeben. (Obwohl das Backup an dieser Stelle trotzdem noch weiterzulaufen scheint).

gefolgt von:

Ntfs (Microsoft-Windows-Ntfs) 140 Die Daten konnten nicht in das Transaktionsprotokoll verschoben werden. Die Daten sind möglicherweise beschädigt:

Volume-ID: "D:", Gerätename: "\Device\HarddiskVolume4". (Das E/A-Gerät hat einen E/A-Fehler gemeldet.)

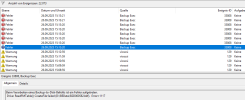

und:

Backup Exec 57600 Auf GerΣt "Plattenspeicher 0001" trat ein unbekannter Fehler auf.

Backup Exec 33808 Beim Verarbeiten eines Backup-to-Disk-Befehls ist ein Fehler aufgetreten. Drive: ReadMTFData() ReadFile failed (D:\BEData\B2D000379.bkf)

3773858. Error=1117

Backup Exec 58057 Backup Exec-Meldung: Medienfehler (Server: "ISER-BK02X") Der Datenträger ist offline.

Backup Exec 58053 Backup Exec-Meldung: Speicherfehler (Server: "ISER-BK02X") Der Gerätestatus wurde aufgrund eines E/A-Fehlers auf offline eingestellt.

bis zu:

Disk 153 Der E/A-Vorgang an der logischen Blockadresse "0x39de0460" für den Datenträger "1" (PDO-Name: \Device\00000027) wurde wiederholt.

Ich habe bisher alle Gerätetreiber des SAS-HBA, der Library, der Tape-Drives sowie Proxmox und Windows aktualisiert. Außerdem habe ich mit mehreren

Versionen des VirtIO SCSI-Passthrough Treibers (100.93.104.24000 sowie 100.93.104.20400, weil ich gelesen habe, die neueren hätten ein Problem) rumgespielt, aber

insgesamt ist die Situation unverändert.

Was ich komisch daran finde, ist die Tatsache, dass der/die Fehler ab einem Zeitpunkt X auftreten und nicht sofort zu Beginn des Backups. Und wie schon erwähnt läuft

die Backup2Disk-Sicherung (auf den Plattenspeicher) problemlos - erst bei der Kopie auf Tape gibt's diese Probleme.

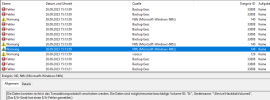

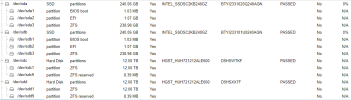

Im Geräte-Manager der VM sieht es folgendermaßen aus:

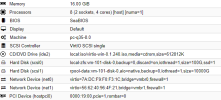

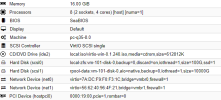

Die Hardware-Konfiguration der VM:

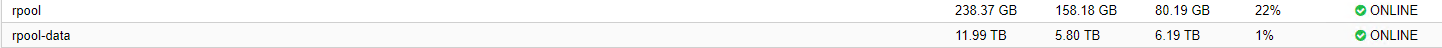

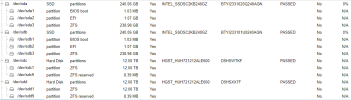

Disks

ZFS

Hat jemand einen Tipp, an was das liegen kann bzw. wie man es beheben könnte?

Gruß, Oliver

wir betreiben einen eigenständigen Proxmox-Server mit einer Windows Server 2019 VM, in der BackupExec 20.6 installiert ist.

Die Systemplatte (C: ) der VM liegt auf einem ZFS-Storage mit 2 SSD's (Mirror).

Der Backupspeicher (D: ) liegt ebenfalls auf einem (eigenen) ZFS-Storage mit 2 HDD's (Mirror), die in der Windows-VM eingebunden sind.

Die Tapelibrary (HP) mit 2 Tapedrives wird per PCI-Passthrough (SAS-HBA) ebenfalls in der Windows-VM eingebunden, was soweit auch fehlerfrei funktioniert.

Backup2Disk läuft problemlos (Sicherung von Windows-VM's auf einem Proxmox-Cluster).

Nun passiert beim Kopieren der Backups (2Tape) irgendwann irgendwas und der Backupspeicher ist anscheinend nicht mehr (so richtig) verfügbar. Das kann bei 4GB sein

oder bei 400GB. Das Backup (1,8TB) wird auf jeden Fall nicht abgeschlossen und irgendwann wird der Plattenspeicher wg. EA-Fehlern von BackupExec "offline" geschaltet.

In der Ereignissanzeige sind dann unzählige Fehler zu finden.

Es fängt an mit (minütlich):

vioscsi 129 Ein Zurücksetzen auf Gerät "\Device\RaidPort2" wurde ausgegeben. (Obwohl das Backup an dieser Stelle trotzdem noch weiterzulaufen scheint).

gefolgt von:

Ntfs (Microsoft-Windows-Ntfs) 140 Die Daten konnten nicht in das Transaktionsprotokoll verschoben werden. Die Daten sind möglicherweise beschädigt:

Volume-ID: "D:", Gerätename: "\Device\HarddiskVolume4". (Das E/A-Gerät hat einen E/A-Fehler gemeldet.)

und:

Backup Exec 57600 Auf GerΣt "Plattenspeicher 0001" trat ein unbekannter Fehler auf.

Backup Exec 33808 Beim Verarbeiten eines Backup-to-Disk-Befehls ist ein Fehler aufgetreten. Drive: ReadMTFData() ReadFile failed (D:\BEData\B2D000379.bkf)

3773858. Error=1117

Backup Exec 58057 Backup Exec-Meldung: Medienfehler (Server: "ISER-BK02X") Der Datenträger ist offline.

Backup Exec 58053 Backup Exec-Meldung: Speicherfehler (Server: "ISER-BK02X") Der Gerätestatus wurde aufgrund eines E/A-Fehlers auf offline eingestellt.

bis zu:

Disk 153 Der E/A-Vorgang an der logischen Blockadresse "0x39de0460" für den Datenträger "1" (PDO-Name: \Device\00000027) wurde wiederholt.

Ich habe bisher alle Gerätetreiber des SAS-HBA, der Library, der Tape-Drives sowie Proxmox und Windows aktualisiert. Außerdem habe ich mit mehreren

Versionen des VirtIO SCSI-Passthrough Treibers (100.93.104.24000 sowie 100.93.104.20400, weil ich gelesen habe, die neueren hätten ein Problem) rumgespielt, aber

insgesamt ist die Situation unverändert.

Was ich komisch daran finde, ist die Tatsache, dass der/die Fehler ab einem Zeitpunkt X auftreten und nicht sofort zu Beginn des Backups. Und wie schon erwähnt läuft

die Backup2Disk-Sicherung (auf den Plattenspeicher) problemlos - erst bei der Kopie auf Tape gibt's diese Probleme.

Im Geräte-Manager der VM sieht es folgendermaßen aus:

Die Hardware-Konfiguration der VM:

Disks

ZFS

Hat jemand einen Tipp, an was das liegen kann bzw. wie man es beheben könnte?

Gruß, Oliver

Last edited: