Hallo zusammen!

Da ich von einem Arbeitskollegen einen Fujitsu Primergy RX300 S8 mit vielen "oldschoo" HDDs geschenkt bekommen habe,

habe ich mir auf diesen HDDs einen ZFS-Pool 'Datengrab' eingerichtet.

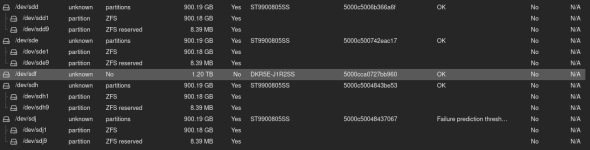

Nun hab ich festgestellt, dass anscheinende nicht alle 8 Festplatten in dem Pool sind (sda + sdb ist meine gemirrorte Proxmox-Installation):

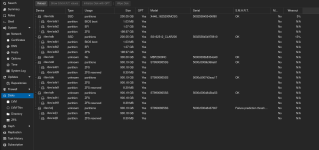

In der Web-GUI sieht das dann so aus:

Kann ich die Platten 'sdc', 'sdf' und 'sdg' noch zum Pool hinzufügen, oder zumindest herausfinden, was mit diesen ist?

Ich danke euch für eure Rückmeldung

Da ich von einem Arbeitskollegen einen Fujitsu Primergy RX300 S8 mit vielen "oldschoo" HDDs geschenkt bekommen habe,

habe ich mir auf diesen HDDs einen ZFS-Pool 'Datengrab' eingerichtet.

Nun hab ich festgestellt, dass anscheinende nicht alle 8 Festplatten in dem Pool sind (sda + sdb ist meine gemirrorte Proxmox-Installation):

Bash:

root@pve:~# lsblk -e230 -o+FSTYPE,LABEL,MODEL

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINTS FSTYPE LABEL MODEL

sda 8:0 0 186.3G 0 disk X446_1625200MCSG

├─sda1 8:1 0 1007K 0 part

├─sda2 8:2 0 1G 0 part vfat

└─sda3 8:3 0 185.3G 0 part zfs_member rpool

sdb 8:16 0 186.3G 0 disk SS162512 CLAR200

├─sdb1 8:17 0 1007K 0 part

├─sdb2 8:18 0 1G 0 part vfat

└─sdb3 8:19 0 185.3G 0 part zfs_member rpool

sdc 8:32 0 279.4G 0 disk MBF2300RC

sdd 8:48 0 838.4G 0 disk ST9900805SS

├─sdd1 8:49 0 838.4G 0 part zfs_member Datengrab

└─sdd9 8:57 0 8M 0 part

sde 8:64 0 838.4G 0 disk ST9900805SS

├─sde1 8:65 0 838.4G 0 part zfs_member Datengrab

└─sde9 8:73 0 8M 0 part

sdf 8:80 0 0B 0 disk DKR5E-J1R2SS

sdg 8:96 0 0B 0 disk DKR5E-J1R2SS

sdh 8:112 0 838.4G 0 disk ST9900805SS

├─sdh1 8:113 0 838.4G 0 part zfs_member Datengrab

└─sdh9 8:121 0 8M 0 part

sdi 8:128 0 0B 0 disk DKR5E-J1R2SS

sdj 8:144 0 838.4G 0 disk ST9900805SS

├─sdj1 8:145 0 838.4G 0 part zfs_member Datengrab

└─sdj9 8:153 0 8M 0 part

sr0 11:0 1 1024M 0 rom TSSTcorp CDDVDW SN-208AB

Bash:

root@pve:~# zpool status -vLP

pool: Datengrab

state: ONLINE

scan: scrub in progress since Sun Feb 8 00:24:01 2026

1.97T / 1.97T scanned, 352G / 1.97T issued at 522M/s

0B repaired, 17.45% done, 00:54:24 to go

config:

NAME STATE READ WRITE CKSUM

Datengrab ONLINE 0 0 0

raidz1-0 ONLINE 0 0 0

/dev/sdd1 ONLINE 0 0 0

/dev/sde1 ONLINE 0 0 0

/dev/sdh1 ONLINE 0 0 0

/dev/sdj1 ONLINE 0 0 0

errors: No known data errors

pool: rpool

state: ONLINE

scan: scrub repaired 0B in 00:00:32 with 0 errors on Sun Feb 8 00:24:37 2026

config:

NAME STATE READ WRITE CKSUM

rpool ONLINE 0 0 0

mirror-0 ONLINE 0 0 0

/dev/sda3 ONLINE 0 0 0

/dev/sdb3 ONLINE 0 0 0

errors: No known data errorsIn der Web-GUI sieht das dann so aus:

Kann ich die Platten 'sdc', 'sdf' und 'sdg' noch zum Pool hinzufügen, oder zumindest herausfinden, was mit diesen ist?

Ich danke euch für eure Rückmeldung