Hallo allerseits!

Ich setze PVE in einer Arztpraxis ein. Die wesentliche Anwendung ist die Praxissoftware, die auf einer Windows Server 2016 VM läuft und Firebird als Datenbank verwendet. Damit ist die Performance gefühlt ganz ok, aber es fehlt noch ein Quäntchen an Geschwindigkeit und "Schwupdizität".

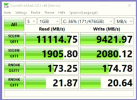

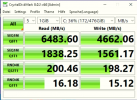

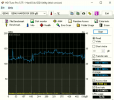

Darüber habe ich mich lange mit dem Dienstleister für die Praxissoftware unterhalten. Er meint, es läge an der Virtualisierung. Meiner Meinung nach liegt es eher an den SAS HDDs, die im Server verbaut sind (Specs siehe unten).

Bevor ich aber entweder Windows Server 2016 nativ auf dem Server installiere oder teure Server SSDs anschaffe, wollte ich Euch fragen, wie denn Eure Meinung dazu ist? Was bringt den größeren Performancegewinn bei besagter Datenbankanwendung (Firebird) unter Windows Server 2016? Auf die Virtualisierung verzichten oder auf SSDs umsteigen? Oder etwas ganz anderes? Über Eure Erfahrungen aus der Praxis wäre ich sehr dankbar!

Hier die Specs des Servers:

Vielen Dank!

Beste Grüße

Thorsten

Ich setze PVE in einer Arztpraxis ein. Die wesentliche Anwendung ist die Praxissoftware, die auf einer Windows Server 2016 VM läuft und Firebird als Datenbank verwendet. Damit ist die Performance gefühlt ganz ok, aber es fehlt noch ein Quäntchen an Geschwindigkeit und "Schwupdizität".

Darüber habe ich mich lange mit dem Dienstleister für die Praxissoftware unterhalten. Er meint, es läge an der Virtualisierung. Meiner Meinung nach liegt es eher an den SAS HDDs, die im Server verbaut sind (Specs siehe unten).

Bevor ich aber entweder Windows Server 2016 nativ auf dem Server installiere oder teure Server SSDs anschaffe, wollte ich Euch fragen, wie denn Eure Meinung dazu ist? Was bringt den größeren Performancegewinn bei besagter Datenbankanwendung (Firebird) unter Windows Server 2016? Auf die Virtualisierung verzichten oder auf SSDs umsteigen? Oder etwas ganz anderes? Über Eure Erfahrungen aus der Praxis wäre ich sehr dankbar!

Hier die Specs des Servers:

- HPE ProLiant DL360 Gen9 E5-2620v4

- HPE 16 GB RAM

- 3x HPE HPE 300 GB SAS 10K SFF SC DS HDD im RAID 1 mit Spare

- 3x HPE HPE 600 GB SAS 10K SFF SC DS HDD im RAIS 1 mit Spare

Vielen Dank!

Beste Grüße

Thorsten