Hi,

ich habe seit ein paar Tagen OMV OS in einer VM laufen. Zwei USB Festplatten sind durchgereicht. Nun kommen "plötzlich" beim kopieren von Daten

Fehler bzw. die VM wird sofort gestoppt. Im der kern.log Datei ist das einzige Indiz:

Dann ist die VM aus tot. OK, Fehler im Dateisystem sind das Eine, I/O Fehler am USB das Andere, aber das sich das system direkt zerschießt?

Hat jemand eine Idee?

beste Grüße

ich habe seit ein paar Tagen OMV OS in einer VM laufen. Zwei USB Festplatten sind durchgereicht. Nun kommen "plötzlich" beim kopieren von Daten

Fehler bzw. die VM wird sofort gestoppt. Im der kern.log Datei ist das einzige Indiz:

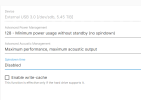

Code:

openmediavault kernel: [ 743.712763] I/O error, dev sdc, sector 3029837056 op 0x0:(READ) flags 0x80700 phys_seg 212 prio class 2Dann ist die VM aus tot. OK, Fehler im Dateisystem sind das Eine, I/O Fehler am USB das Andere, aber das sich das system direkt zerschießt?

Hat jemand eine Idee?

beste Grüße