Hallo,

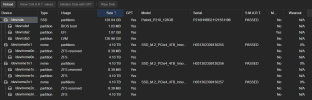

ich habe Proxmox (v8.1.4) auf einer SATA-SSDs installiert und einen Raid 5 mit 3x 4TB NVMe SSDs über Proxmox (ZFS) erstellt. Nun teste ich gerade das neue System, unter anderem auch die Schreib- und Leseraten des Raid 5 auf einer neuen VM. Hier erreiche ich allerdings relativ geringe Werte (400 MB/s), laut Datenblatt wären theoretisch 7.000 MB/s pro SSD möglich.

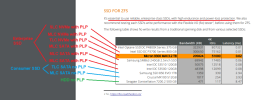

Verbaut ist folgendes:

- AMD Epyc 7551p

- H11SSL-NC Rev 2.0

- 256GB DDR4-2666

- 3x Innovation IT PerformanceY GEN4 4TB auf Asus Hyper M.2 X16 Card V2

Und wenn ich schon diesen Thread erstelle, habe ich noch zwei weitere Fragen:

- Wäre es eine Überlegung wert, etwas anderes als ZFS zu nutzen? Scheinbar benötigt man dafür relativ viel Arbeitsspeicher.

- Ist es Sinnvoll beim erstellen von ZFS die Kompression zu aktivieren?

Viele Grüße,

Cornelius

ich habe Proxmox (v8.1.4) auf einer SATA-SSDs installiert und einen Raid 5 mit 3x 4TB NVMe SSDs über Proxmox (ZFS) erstellt. Nun teste ich gerade das neue System, unter anderem auch die Schreib- und Leseraten des Raid 5 auf einer neuen VM. Hier erreiche ich allerdings relativ geringe Werte (400 MB/s), laut Datenblatt wären theoretisch 7.000 MB/s pro SSD möglich.

Verbaut ist folgendes:

- AMD Epyc 7551p

- H11SSL-NC Rev 2.0

- 256GB DDR4-2666

- 3x Innovation IT PerformanceY GEN4 4TB auf Asus Hyper M.2 X16 Card V2

Und wenn ich schon diesen Thread erstelle, habe ich noch zwei weitere Fragen:

- Wäre es eine Überlegung wert, etwas anderes als ZFS zu nutzen? Scheinbar benötigt man dafür relativ viel Arbeitsspeicher.

- Ist es Sinnvoll beim erstellen von ZFS die Kompression zu aktivieren?

Viele Grüße,

Cornelius