Moin,

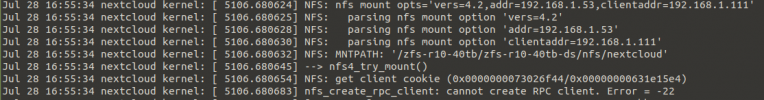

nach upgrade auf PVE 8 funktioniert einer mainer NFS mounts (nfs server läuft direkt auf einem PVE server) nicht mehr.

Das storage welches ich direkt im CLuster eingebunden habe geht noch aber ein mount aus einer DMZ geht nicht und endet im timeout. D.h. der NFS server funktioniert prinzipiell.

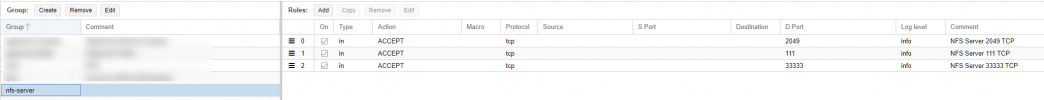

hat sich etwas bei NFS geändert? oder Firewall. Irgendein Idee - wo schauen?

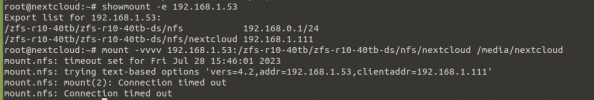

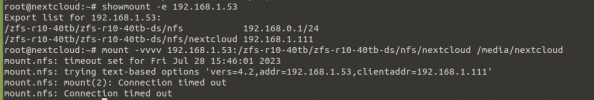

exports

/zfs-r10-40tb/zfs-r10-40tb-ds/nfs/nextcloud 192.168.1.111(rw,sync,no_subtree_check)

nach upgrade auf PVE 8 funktioniert einer mainer NFS mounts (nfs server läuft direkt auf einem PVE server) nicht mehr.

Das storage welches ich direkt im CLuster eingebunden habe geht noch aber ein mount aus einer DMZ geht nicht und endet im timeout. D.h. der NFS server funktioniert prinzipiell.

hat sich etwas bei NFS geändert? oder Firewall. Irgendein Idee - wo schauen?

exports

/zfs-r10-40tb/zfs-r10-40tb-ds/nfs/nextcloud 192.168.1.111(rw,sync,no_subtree_check)

Last edited: