Guten Morgen Community,

ich stehe ein wenig auf dem Schlauch. Kurz um zum Problem: Proxmox / Debian knallt nach ungewisser Zeit die Netzwerk Interfaces von unseren Mellanox Karten weg (ens*). Im dmesg steht nahe zu nichts und auch das syslog ist sehr dürftig.

Folgend mal ein paar Screenshots und auszüge von Logs - vielleicht wisst ihr mehr oder kennt das Verhalten schon? Nach einem Neustart ist dann alles wieder fine und kann verwendet werden. Für wenige Stunden / manchmal auch 1 1/2 Tage.

Zudem sind die PCI-Devices unter lspci zu sehen aber in ip -br addr sind die Interfaces weg. Kennt jemand von euch das Verhalten? Das sind zwei fabrikneue Karten.

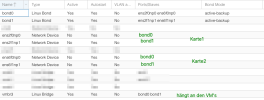

Network Configuration in Proxmox

dmesg Auszug (grep bond0)

dmesg Auszug (grep ens*)

Weitere Informationen ausm dmesg

ich stehe ein wenig auf dem Schlauch. Kurz um zum Problem: Proxmox / Debian knallt nach ungewisser Zeit die Netzwerk Interfaces von unseren Mellanox Karten weg (ens*). Im dmesg steht nahe zu nichts und auch das syslog ist sehr dürftig.

Folgend mal ein paar Screenshots und auszüge von Logs - vielleicht wisst ihr mehr oder kennt das Verhalten schon? Nach einem Neustart ist dann alles wieder fine und kann verwendet werden. Für wenige Stunden / manchmal auch 1 1/2 Tage.

Zudem sind die PCI-Devices unter lspci zu sehen aber in ip -br addr sind die Interfaces weg. Kennt jemand von euch das Verhalten? Das sind zwei fabrikneue Karten.

Network Configuration in Proxmox

dmesg Auszug (grep bond0)

Bash:

root@server-01:~# dmesg -T | grep -i bond0

[Thu Nov 2 10:02:50 2023] bond0: (slave ens2f0np0): making interface the new active one

[Thu Nov 2 10:02:50 2023] bond0: (slave ens2f0np0): Enslaving as an active interface with an up link

[Thu Nov 2 10:02:51 2023] bond0: (slave ens6f0np0): Enslaving as a backup interface with an up link

[Thu Nov 2 10:02:52 2023] vmbr3: port 1(bond0) entered blocking state

[Thu Nov 2 10:02:52 2023] vmbr3: port 1(bond0) entered disabled state

[Thu Nov 2 10:02:52 2023] device bond0 entered promiscuous mode

[Thu Nov 2 10:02:52 2023] vmbr3: port 1(bond0) entered blocking state

[Thu Nov 2 10:02:52 2023] vmbr3: port 1(bond0) entered forwarding state

[Thu Nov 2 10:02:52 2023] vmbr3: received packet on bond0 with own address as source address (addr:e8:eb:d3:c1:20:4c, vlan:0)

[Thu Nov 2 10:02:52 2023] vmbr3: received packet on bond0 with own address as source address (addr:e8:eb:d3:c1:20:4c, vlan:0)

[Thu Nov 2 10:02:52 2023] vmbr3: received packet on bond0 with own address as source address (addr:e8:eb:d3:c1:20:4c, vlan:0)

[Thu Nov 2 10:02:52 2023] vmbr3: received packet on bond0 with own address as source address (addr:e8:eb:d3:c1:20:4c, vlan:0)

[Thu Nov 2 10:03:03 2023] 8021q: adding VLAN 0 to HW filter on device bond0

[Thu Nov 2 10:22:49 2023] bond0: (slave ens2f0np0): Releasing backup interface

[Thu Nov 2 10:22:49 2023] bond0: (slave ens2f0np0): the permanent HWaddr of slave - e8:eb:d3:c1:20:4c - is still in use by bond - set the HWaddr of slave to a different address to avoid conflicts

[Thu Nov 2 10:22:49 2023] bond0: (slave ens6f0np0): making interface the new active one

[Thu Nov 2 10:22:53 2023] bond0: (slave ens6f0np0): Releasing backup interface

[Thu Nov 2 10:22:53 2023] vmbr3: port 1(bond0) entered disabled state

[Thu Nov 2 10:22:58 2023] vmbr3v230: port 1(bond0.230) entered blocking state

[Thu Nov 2 10:22:58 2023] vmbr3v230: port 1(bond0.230) entered disabled state

[Thu Nov 2 10:22:58 2023] device bond0.230 entered promiscuous modedmesg Auszug (grep ens*)

Bash:

root@server-01:~# dmesg -T | grep -i ens

[Thu Nov 2 10:02:29 2023] ACPI: Added _OSI(3.0 _SCP Extensions)

[Thu Nov 2 10:02:30 2023] megaraid_sas 0000:b2:00.0: unevenspan support : no

[Thu Nov 2 10:02:30 2023] sd 0:2:0:0: [sda] Mode Sense: 1f 00 00 08

[Thu Nov 2 10:02:30 2023] sd 0:2:1:0: [sdb] Mode Sense: 1f 00 00 08

[Thu Nov 2 10:02:30 2023] i40e 0000:61:00.1 ens4f1: renamed from eth1

[Thu Nov 2 10:02:32 2023] mlx5_core 0000:3e:00.0 ens2f0np0: renamed from eth0

[Thu Nov 2 10:02:32 2023] mlx5_core 0000:3e:00.1 ens2f1np1: renamed from eth1

[Thu Nov 2 10:02:32 2023] mlx5_core 0000:b1:00.1 ens6f1np1: renamed from eth3

[Thu Nov 2 10:02:32 2023] mlx5_core 0000:b1:00.0 ens6f0np0: renamed from eth2

[Thu Nov 2 10:02:36 2023] systemd[1]: systemd 252.17-1~deb12u1 running in system mode (+PAM +AUDIT +SELINUX +APPARMOR +IMA +SMACK +SECCOMP +GCRYPT -GNUTLS +OPENSSL +ACL +BLKID +CURL +ELFUTILS +FIDO2 +IDN2 -IDN +IPTC +KMOD +LIBCRYPTSETUP +LIBFDISK +PCRE2 -PWQUALITY +P11KIT +QRENCODE +TPM2 +BZIP2 +LZ4 +XZ +ZLIB +ZSTD -BPF_FRAMEWORK -XKBCOMMON +UTMP +SYSVINIT default-hierarchy=unified)

[Thu Nov 2 10:02:38 2023] znvpair: module license 'CDDL' taints kernel.

[Thu Nov 2 10:02:40 2023] ipmi_si IPI0001:00: The BMC does not support clearing the recv irq bit, compensating, but the BMC needs to be fixed.

[Thu Nov 2 10:02:50 2023] vmbr1: port 1(ens4f1) entered blocking state

[Thu Nov 2 10:02:50 2023] vmbr1: port 1(ens4f1) entered disabled state

[Thu Nov 2 10:02:50 2023] device ens4f1 entered promiscuous mode

[Thu Nov 2 10:02:50 2023] mlx5_core 0000:3e:00.0 ens2f0np0: Link up

[Thu Nov 2 10:02:50 2023] bond0: (slave ens2f0np0): making interface the new active one

[Thu Nov 2 10:02:50 2023] bond0: (slave ens2f0np0): Enslaving as an active interface with an up link

[Thu Nov 2 10:02:51 2023] mlx5_core 0000:b1:00.0 ens6f0np0: Link up

[Thu Nov 2 10:02:51 2023] bond0: (slave ens6f0np0): Enslaving as a backup interface with an up link

[Thu Nov 2 10:02:51 2023] vmbr1: port 1(ens4f1) entered blocking state

[Thu Nov 2 10:02:51 2023] vmbr1: port 1(ens4f1) entered forwarding state

[Thu Nov 2 10:02:52 2023] mlx5_core 0000:3e:00.1 ens2f1np1: Link up

[Thu Nov 2 10:02:52 2023] bond1: (slave ens2f1np1): making interface the new active one

[Thu Nov 2 10:02:52 2023] bond1: (slave ens2f1np1): Enslaving as an active interface with an up link

[Thu Nov 2 10:02:52 2023] mlx5_core 0000:b1:00.1 ens6f1np1: Link up

[Thu Nov 2 10:02:52 2023] bond1: (slave ens6f1np1): Enslaving as a backup interface with an up link

[Thu Nov 2 10:02:52 2023] device ens2f0np0 entered promiscuous mode

[Thu Nov 2 10:02:52 2023] device ens2f1np1 entered promiscuous mode

[Thu Nov 2 10:03:03 2023] 8021q: adding VLAN 0 to HW filter on device ens4f1

[Thu Nov 2 10:03:03 2023] 8021q: adding VLAN 0 to HW filter on device ens2f0np0

[Thu Nov 2 10:03:03 2023] 8021q: adding VLAN 0 to HW filter on device ens2f1np1

[Thu Nov 2 10:03:03 2023] 8021q: adding VLAN 0 to HW filter on device ens6f0np0

[Thu Nov 2 10:03:03 2023] 8021q: adding VLAN 0 to HW filter on device ens6f1np1

[Thu Nov 2 10:03:03 2023] vmbr1v230: port 1(ens4f1.230) entered blocking state

[Thu Nov 2 10:03:03 2023] vmbr1v230: port 1(ens4f1.230) entered disabled state

[Thu Nov 2 10:03:03 2023] device ens4f1.230 entered promiscuous mode

[Thu Nov 2 10:03:03 2023] vmbr1v230: port 1(ens4f1.230) entered blocking state

[Thu Nov 2 10:03:03 2023] vmbr1v230: port 1(ens4f1.230) entered forwarding state

[Thu Nov 2 10:22:49 2023] bond0: (slave ens2f0np0): Releasing backup interface

[Thu Nov 2 10:22:49 2023] bond0: (slave ens2f0np0): the permanent HWaddr of slave - e8:eb:d3:c1:20:4c - is still in use by bond - set the HWaddr of slave to a different address to avoid conflicts

[Thu Nov 2 10:22:49 2023] device ens2f0np0 left promiscuous mode

[Thu Nov 2 10:22:49 2023] bond0: (slave ens6f0np0): making interface the new active one

[Thu Nov 2 10:22:49 2023] device ens6f0np0 entered promiscuous mode

[Thu Nov 2 10:22:53 2023] bond0: (slave ens6f0np0): Releasing backup interface

[Thu Nov 2 10:22:53 2023] device ens6f0np0 left promiscuous mode

[Thu Nov 2 10:22:56 2023] bond1: (slave ens2f1np1): Releasing backup interface

[Thu Nov 2 10:22:56 2023] bond1: (slave ens2f1np1): the permanent HWaddr of slave - e8:eb:d3:c1:20:4d - is still in use by bond - set the HWaddr of slave to a different address to avoid conflicts

[Thu Nov 2 10:22:56 2023] device ens2f1np1 left promiscuous mode

[Thu Nov 2 10:22:56 2023] bond1: (slave ens6f1np1): making interface the new active one

[Thu Nov 2 10:22:56 2023] device ens6f1np1 entered promiscuous mode

[Thu Nov 2 10:22:59 2023] bond1: (slave ens6f1np1): Releasing backup interface

[Thu Nov 2 10:22:59 2023] device ens6f1np1 left promiscuous modeWeitere Informationen ausm dmesg

Bash:

[Thu Nov 2 10:22:50 2023] kvm [135476]: ignored rdmsr: 0xc0011029 data 0x0

[Thu Nov 2 10:22:50 2023] kvm [135476]: ignored wrmsr: 0x150 data 0x8000001c00000000

[Thu Nov 2 10:22:50 2023] kvm [135476]: ignored rdmsr: 0x150 data 0x0

[Thu Nov 2 10:22:50 2023] kvm [135476]: ignored wrmsr: 0x150 data 0x8000001c00000000

[Thu Nov 2 10:22:50 2023] kvm [135476]: ignored rdmsr: 0x150 data 0x0

[Thu Nov 2 10:22:50 2023] kvm [135476]: ignored wrmsr: 0x150 data 0x8000001c00000000

[Thu Nov 2 10:22:50 2023] kvm [135476]: ignored rdmsr: 0x150 data 0x0

[Thu Nov 2 10:22:50 2023] kvm [135476]: ignored wrmsr: 0x150 data 0x8000001c00000000

[Thu Nov 2 10:22:50 2023] kvm [135476]: ignored rdmsr: 0x150 data 0x0

Last edited: