Guten Morgen,

tja was soll ich sagen. Die erste " Amtshandlung" nachdem ich nun dabei bin langsam von meinem NAS weg zu einem Mini PC mit Proxmox und diversen VM zu wechseln etc. wurde der Sache nun recht schnell einen Dämpfer verpasst.

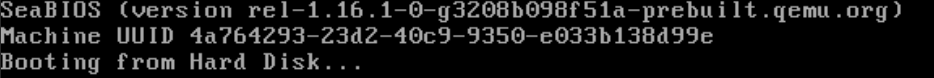

Nachdem ich erfolgreich Homeassistant in einer VM erstellt und laufen hatte, wollte ich die Backup funktion mal ausprobieren um sicher zu sein das es funzt. Habe eine NFS Freigabe von meinem NAS in Proxmox für ein Backup eingebunden, das Backup hat er auch gemacht ( Dump vorhanden ). Nun habe ich ein Update von Proxmox gemacht, in der geöffneten Konsole stand nach dem Update das wohl auch ein Kernel ein Update bekommen hat und bitte Neugestartet werden soll. Ok, in der Konsole Reboot und fertig. Nach dem Start komme ich jedoch nicht mehr auf die HA Weboberfläche, Neustartet von Proxmox oder VM bringt keine Abhilfe. Dann habe ich das Backup " zurückgespielt" und auch damit keinen Erfolg. Komischerweise habe ich nun 2 Homeassistant VM´s, hä?? Im Task von Proxmox sehe ich folgende Meldungen:

VM 101: Shutdoen: TASK ERROR: can't lock file '/var/lock/qemu-server/lock-101.conf' - got timeout

VM 101 Reboot: TASK ERROR: VM quit/powerdown failed

Ich weis ich bin neu, und ich weis auch das ich bzgl. Proxmox / Linux etc. völliger Noob bin, aber es kann doch nicht sein das ich ein Programm nutze das bei der ersten " Nutzung " sofort Probleme macht. Wie soll das nur weiter gehen wenn man mal zig VM´s und / oder LXc Container hat, dann hat man ja mehr mit Problemen als mit dem Nutzen des Systems zu tun.

Danke vorab für eure Hilfe!!!

Gruß

Mark

tja was soll ich sagen. Die erste " Amtshandlung" nachdem ich nun dabei bin langsam von meinem NAS weg zu einem Mini PC mit Proxmox und diversen VM zu wechseln etc. wurde der Sache nun recht schnell einen Dämpfer verpasst.

Nachdem ich erfolgreich Homeassistant in einer VM erstellt und laufen hatte, wollte ich die Backup funktion mal ausprobieren um sicher zu sein das es funzt. Habe eine NFS Freigabe von meinem NAS in Proxmox für ein Backup eingebunden, das Backup hat er auch gemacht ( Dump vorhanden ). Nun habe ich ein Update von Proxmox gemacht, in der geöffneten Konsole stand nach dem Update das wohl auch ein Kernel ein Update bekommen hat und bitte Neugestartet werden soll. Ok, in der Konsole Reboot und fertig. Nach dem Start komme ich jedoch nicht mehr auf die HA Weboberfläche, Neustartet von Proxmox oder VM bringt keine Abhilfe. Dann habe ich das Backup " zurückgespielt" und auch damit keinen Erfolg. Komischerweise habe ich nun 2 Homeassistant VM´s, hä?? Im Task von Proxmox sehe ich folgende Meldungen:

VM 101: Shutdoen: TASK ERROR: can't lock file '/var/lock/qemu-server/lock-101.conf' - got timeout

VM 101 Reboot: TASK ERROR: VM quit/powerdown failed

Ich weis ich bin neu, und ich weis auch das ich bzgl. Proxmox / Linux etc. völliger Noob bin, aber es kann doch nicht sein das ich ein Programm nutze das bei der ersten " Nutzung " sofort Probleme macht. Wie soll das nur weiter gehen wenn man mal zig VM´s und / oder LXc Container hat, dann hat man ja mehr mit Problemen als mit dem Nutzen des Systems zu tun.

Danke vorab für eure Hilfe!!!

Gruß

Mark

Last edited: