Das Glück ist mir nicht hold. Gestern diesen OVF-Vorlage-exportieren mit ausgeschalteter VMware-VM.

Heute wollte ich nach Anleitung importieren:

https://pve.proxmox.com/wiki/Migration_of_servers_to_Proxmox_VE#VMware_vCenter_Settings

root@wkst01:/mnt/pve/nas15.10G/venus# qm importovf 119 ./support-venus.ovf SSD-Pool1

qemu-img: Could not open '/mnt/pve/nas15.10G/venus/support-venus-4.vmdk': Invalid footer

could not parse qemu-img info command output for '/mnt/pve/nas15.10G/venus/support-venus-4.vmdk' - malformed JSON string, neither tag, array, obj

ect, number, string or atom, at character offset 0 (before "(end of string)") at /usr/share/perl5/PVE/Storage/Plugin.pm line 946.

error parsing /mnt/pve/nas15.10G/venus/support-venus-4.vmdk, cannot determine file size

root@wkst01:/mnt/pve/nas15.10G/venus# ls -lh

total 35G

-rw------- 1 root root 309 Sep 6 22:31 nohup.out

-rw-r--r-- 1 1000 1000 16G Sep 6 20:04 support-venus-1.vmdk

-rw-r--r-- 1 1000 1000 4.5G Sep 6 19:02 support-venus-2.vmdk

-rw-r--r-- 1 1000 1000 3.9G Sep 6 18:48 support-venus-3.vmdk

-rw-r--r-- 1 1000 1000 3.8G Sep 6 18:47 support-venus-4.vmdk

-rw-r--r-- 1 1000 1000 7.2G Sep 6 18:59 support-venus-5.vmdk

-rw-r--r-- 1 1000 1000 8.5K Sep 6 18:34 support-venus-6.nvram

-rw-r--r-- 1 1000 1000 663 Sep 6 20:06 support-venus.mf

-rw-r--r-- 1 1000 1000 9.6K Sep 6 18:35 support-venus.ovf

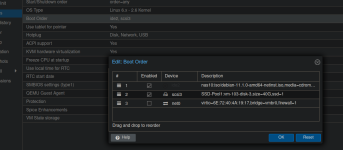

Die Clone sind normalerweise so 80G groß, die Summe der Plattengrößen lt. vSphere: 180G, siehe scrnsht.

Na gut, da gibt es ja noch den Hinweis auf den Direktexport über das ovftool:

root@wkst01:/mnt/pve/nas15.10G# mkdir venus.ovf2

root@wkst01:/mnt/pve/nas15.10G# cd venus.ovf2/

root@wkst01:/mnt/pve/nas15.10G/venus.ovf2# ovftool vi://

root@10.56.12.88/support-venus .

Enter login information for source vi://10.56.12.88/

Username: root

Password: ***********

Opening VI source: vi://

root@10.56.12.88:443/support-venus

Error: Message is: Received SOAP response fault from [<SSL(<io_obj p:0x00007fb314019878, h:7, <TCP '10.56.17.201 : 40022'>, <TCP '10.56.12.88 : 4

43'>>), /sdk>]: exportVm

The operation is not allowed in the current state.,

Fault cause: vim.fault.InvalidState

Completed with errors

Das war übrigens ganz viel früher mal ein SLES11.

Ich glaub, ich bau besser ne neue VM. pDNS und otrs. Mit debian.