Hallo zusammen,

erstmal vorab ein Lob an das Forum. Hier findet so jeder die richtigen Antworten auf fast alle Fragen

Hier mal meine Frage:

Ich habe eine 2x SFP+ Karte (Mellanox X3-Pro) verbaut. Alle Schnittsellen entsprechend den Win Servern zugeordnet und funktionieren auch soweit. Jetzt habe ich mittels "iperf3" einen Speedtest gemacht. Leider bekomme ich nur max. 5gbit hin. Die Karte ist im x8 PCIe Slot verbaut. Die MTU ist auf 9000 gesetzt.

Jemand eine Idee dazu ?

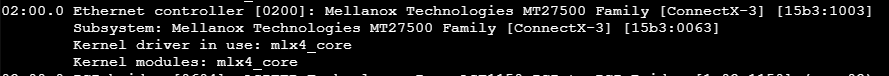

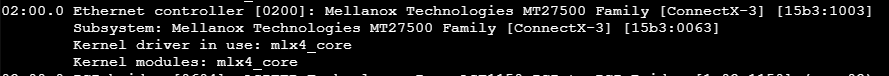

Auszug PVE lspci -nnk

Auszug PVE lspci -v -v -v -s 02:00.0

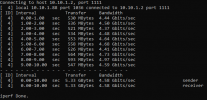

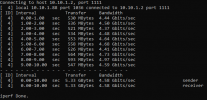

Auszug iperf3 vom Windows 10 Host

Auszug PVE ethtool enp2s0

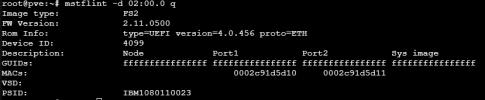

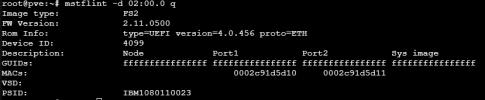

Auszug PVE mstflint -d 02:00.0 q

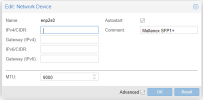

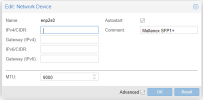

Konfig PVE Schnittstellen:

Auszug Windows Server Netzwerkkarte:

Hier werden 10gbit angezeigt.

Auf den Windows Servern ist aktuell der virtio driver 0.1.190 installiert.

Iperf3 habe ich zwischen einem Windows Host mit 10gbit (funktioniert mit anderen 10gbit Teilnehmern mit Fullspeed) und dem PVE-Windows Server laufen lassen.

Ich habe soweit keine Ahnung mehr was hier schief läuft ?

Eventuell habt ihr noch Ideen

Vorab schon mal Danke.

erstmal vorab ein Lob an das Forum. Hier findet so jeder die richtigen Antworten auf fast alle Fragen

Hier mal meine Frage:

Ich habe eine 2x SFP+ Karte (Mellanox X3-Pro) verbaut. Alle Schnittsellen entsprechend den Win Servern zugeordnet und funktionieren auch soweit. Jetzt habe ich mittels "iperf3" einen Speedtest gemacht. Leider bekomme ich nur max. 5gbit hin. Die Karte ist im x8 PCIe Slot verbaut. Die MTU ist auf 9000 gesetzt.

Jemand eine Idee dazu ?

Auszug PVE lspci -nnk

Auszug PVE lspci -v -v -v -s 02:00.0

Auszug iperf3 vom Windows 10 Host

Auszug PVE ethtool enp2s0

Auszug PVE mstflint -d 02:00.0 q

Konfig PVE Schnittstellen:

Auszug Windows Server Netzwerkkarte:

Hier werden 10gbit angezeigt.

Auf den Windows Servern ist aktuell der virtio driver 0.1.190 installiert.

Iperf3 habe ich zwischen einem Windows Host mit 10gbit (funktioniert mit anderen 10gbit Teilnehmern mit Fullspeed) und dem PVE-Windows Server laufen lassen.

Ich habe soweit keine Ahnung mehr was hier schief läuft ?

Eventuell habt ihr noch Ideen

Vorab schon mal Danke.