Hallo,

ich bin neu in Proxmox und man würde sagen, dass ich auch neu im Berufsleben bin, da ich gerade erst aus der Ausbildung komme. Ich habe heute blöderweise ein ganzes Netzwerk lahm gelegt und würde gerne verstehen was ich falsch gemacht habe und wie ich das in Zukunft verhindern kann.

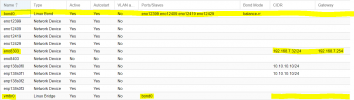

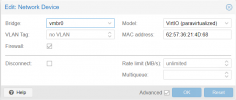

Wir haben bei einem Kunden ein Proxmox Cluster, bestehend aus 3 Servern, stehen. Jeder Server ist mit einem onboard NIC (eno8303) und 4 PCIe NICs (eno12399 , eno12409, eno12419, eno12429) an einem Switch angeschlossen. Die Katastrophe begann, als ich auf dem zweiten der drei Server die vmbr0 an die auf dem ersten Server angeglichen habe. Ich habe die vmbr0 editiert und unter Ports/Slaves die PCIe NICs (eno12399 - eno12429) hinzugefügt. Dies war bereits auf dem ersten Server geschehen und das lief über Wochen problemlos. Nachdem ich diese Einstellungen auf der zweiten node übernommen hatte ging im gesamten Netzwerk des Kunden gar nichts mehr.

Nun würde ich gerne wissen, warum das solange es nur auf Server1 konfiguriert war funktioniert hat, warum das alles zerstört hat und wie ich das in Zukunft verhindern kann.

Vielen Dank im Voraus für eure Zeit. Eventuelle Logs kann ich morgen nachliefern, mir muss nur jemand sagen was benötigt wird.

ich bin neu in Proxmox und man würde sagen, dass ich auch neu im Berufsleben bin, da ich gerade erst aus der Ausbildung komme. Ich habe heute blöderweise ein ganzes Netzwerk lahm gelegt und würde gerne verstehen was ich falsch gemacht habe und wie ich das in Zukunft verhindern kann.

Wir haben bei einem Kunden ein Proxmox Cluster, bestehend aus 3 Servern, stehen. Jeder Server ist mit einem onboard NIC (eno8303) und 4 PCIe NICs (eno12399 , eno12409, eno12419, eno12429) an einem Switch angeschlossen. Die Katastrophe begann, als ich auf dem zweiten der drei Server die vmbr0 an die auf dem ersten Server angeglichen habe. Ich habe die vmbr0 editiert und unter Ports/Slaves die PCIe NICs (eno12399 - eno12429) hinzugefügt. Dies war bereits auf dem ersten Server geschehen und das lief über Wochen problemlos. Nachdem ich diese Einstellungen auf der zweiten node übernommen hatte ging im gesamten Netzwerk des Kunden gar nichts mehr.

Nun würde ich gerne wissen, warum das solange es nur auf Server1 konfiguriert war funktioniert hat, warum das alles zerstört hat und wie ich das in Zukunft verhindern kann.

Vielen Dank im Voraus für eure Zeit. Eventuelle Logs kann ich morgen nachliefern, mir muss nur jemand sagen was benötigt wird.