Hallo zusammen,

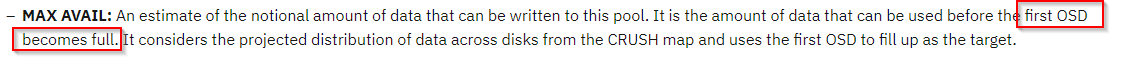

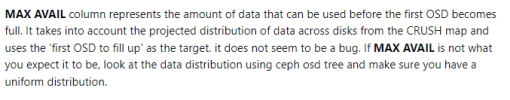

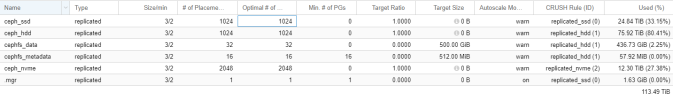

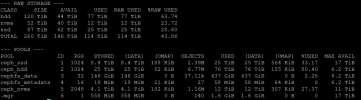

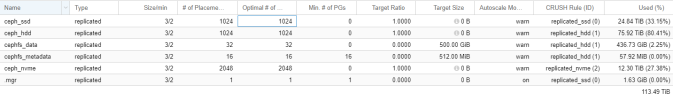

ich habe eine Frage zu CEPH Pools mit unterschiedlichen Crush Rules. Wir haben im Einsatz: HDD's, SSD's und NVMe's. Bei den SSDs und NVMes gibt es nur einen einzigen Pool pro Typ/Crush Rule, aber für HDD haben wir einen Pool für die VMs und einen CEPHFS Pool. Dieser verwendet ebenfalls HDDs. Nun ist es so, das wir beim belegten Speicherplatz theoretisch "falsche" Werte angezeigt bekommen. Ich habe für die CEPHFS Pools eine (rel. niedrige) Target Size angegeben, da hier nicht viel an Daten drin liegt. Trotzdem passen die anzeigten Werte nicht.

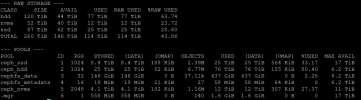

ceph_hdd

RAW USED: 63.74%

Pool Used: 80.41%

Hat hier jemand eine Idee? Lieg es evtl. an der Target Ratio von 1.0?

Btw: Im CephFS liegen nur ISO Images, aber ich habe keinen weiteren Shared Storage, worauf ich für die paar hundert GB ausweichen könnte.

LG

Tan

ich habe eine Frage zu CEPH Pools mit unterschiedlichen Crush Rules. Wir haben im Einsatz: HDD's, SSD's und NVMe's. Bei den SSDs und NVMes gibt es nur einen einzigen Pool pro Typ/Crush Rule, aber für HDD haben wir einen Pool für die VMs und einen CEPHFS Pool. Dieser verwendet ebenfalls HDDs. Nun ist es so, das wir beim belegten Speicherplatz theoretisch "falsche" Werte angezeigt bekommen. Ich habe für die CEPHFS Pools eine (rel. niedrige) Target Size angegeben, da hier nicht viel an Daten drin liegt. Trotzdem passen die anzeigten Werte nicht.

ceph_hdd

RAW USED: 63.74%

Pool Used: 80.41%

Hat hier jemand eine Idee? Lieg es evtl. an der Target Ratio von 1.0?

Btw: Im CephFS liegen nur ISO Images, aber ich habe keinen weiteren Shared Storage, worauf ich für die paar hundert GB ausweichen könnte.

LG

Tan