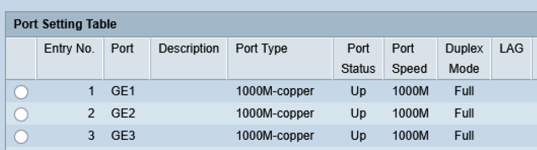

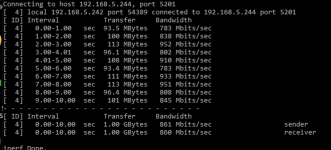

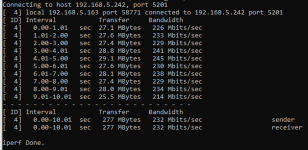

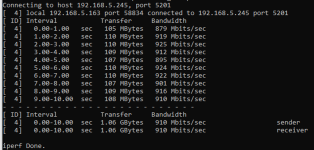

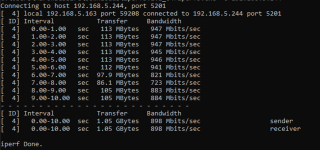

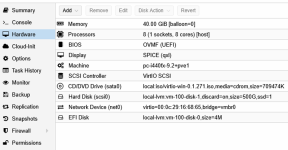

Hallo zusammen. ich habe nun begonnen, meine Projekte von VMWARE auf Proxmox zu migrieren, da ich nicht mehr bereit bin, die Kosten für Broadcom zu tragen. Ich habe die Migration meiner beiden Server über die Proxmox Migration durchgeführt. Das Ganze hat wunderbar funktioniert. Nachdem ich die Einstellungen ein wenig anpassen musste, um die richtigen Einstellungen für einen HPE Server ProLiant DL380 Gen11 Intel Xeon Gold 5415+ zu finden, sieht es jetzt so aus, wie auf dem Bild. Aber mein grösstes Problem ist jetzt folgendes. Auf Server 2 läuft eine Server/Client-Anwendung mit einem SQL-Server. Wenn ich die Software direkt auf dem Server starte, wird alles schnell geladen. Wenn ich es auf dem Client öffne, dauert es sehr lange. Allerdings habe ich dieses Phänomen erst nach der Migration. Was kann ich sonst noch tun, um dieses Problem zu lösen? Ich habe auch bei einem Ping zwischen 40 und 60ms. Aber die Karte ist mit 1GB angeschlossen. Auch der Transfer von ESXI auf Proxmox wurde mit fast 1GB angezeigt. Vielen Dank für Ihre Hilfe, ich bin ratlos.

Last edited: